Чёрный список Чёрной Бороды.

Большое руководство по чёрным спискам IP-адресов.

Для начала давайте с вами определимся с основными понятиями:

- Что такое угроза?

- Что такое признак атаки?

- Как узнать о том, что сервер находится в большой опасности?

- Что вообще такое фаервол, и какие они бывают в Linux-ах.

- И многое другое ...

После чего посмотрим каким образом блокировать и разблокировать угрозы безопасности.

Далее определимся с пониятием черных и белых списков и зачем они вообще нужны.

Посмотрим с вами на реальные примеры и виртуального и реального (VPS) серверов.

Оглавление

- Что можно сделать с украденными личными данными?

- Введение.

- Одновременный доступ к файлам журналов.

- Межсетевые экраны.

- История, определения.

- Netfilter.

- Таблицы и цепочки IPTables.

- NFTABLES.

- UFW / Firewalld.

- Примеры использования UFW / Firewalld.

- Fail2ban.

- NGINX / Nginx Proxy Manager.

- Черный и белый списки.

- Черный и белый список. Введение.

- Скрипты.

- Версии скриптов.

- Символическая ссылка в «/usr/bin/».

- Работа с логами, командами и выводом информации.

- Работа с черным и белым списками.

- IP(6)TABLES / NFTABLES.

- Работа с таблицами и цепочками.

- Сервисные команды скрипта.

- Systemd.

- Использование скриптов в Fail2ban.

1. Что можно сделать с украденными личными данными?

Однажды человека может разбудить неожиданный звонок с требованием вернуть долг, а в почтовом ящике окажется повестка в суд. Но кредитов он не брал, закон не нарушал.

Чтобы взять кредит в крупном банке, одних паспортных данных недостаточно: потребуется хотя бы копия документа. А вот оформить микрозаем в интернете можно с помощью сведений с первых страниц паспорта — номера, даты выдачи, кода подразделения и места рождения.

Обратившись в несколько микрофинансовых организаций, мошенники получат существенную сумму на свои карты — а затем исчезнут, оставив жертву с долгами.

Пользуясь данными чужого паспорта, мошенники регистрируют фирму-однодневку. Так они безнаказанно творят темные дела: уклоняются от налогов или собирают с обычных людей деньги за предзаказ дорогих товаров.

Когда обман вскроется, мошенники заберут деньги и останутся вне подозрений — а вот владельцу паспорта придется объясняться с полицией.

Некоторые интернет-магазины предлагают клиентам покупать товары в рассрочку: чтобы забрать вещь, нужно указать паспортные данные, а оплатить покупку можно позже.

Это на руку мошенникам: они заказывают товар по чужому документу, а курьеру говорят, что покупку получит другой человек — не владелец паспорта. Предупрежденный курьер спокойно отдает дорогую вещь аферисту, но расплачиваться за нее должен ничего не подозревающий владелец паспорта.

Если у «заемщика» хорошая кредитная история, рассрочку, скорее всего, одобрят. Правда, техника попадет в руки мошенникам, а расплачиваться придется вам.

Зная ФИО жертвы и адрес регистрации, мошенники подделывают квитанции на оплату штрафов от государственных органов.

По номеру паспорта на сайте налоговой службы легко узнать ИНН: этот номер поможет придать письму из налоговой убедительности и сообщить жертве об огромной задолженности.

Чтобы оплатить «штраф» и избежать суда, аферисты просят как можно скорее воспользоваться вложенной квитанцией.

Мошенники, которые обманывают людей в интернете, часто просят жертв выслать им деньги на электронный кошелек — поэтому аферистам выгодно использовать чужие данные. Так вся ответственность за мошенничество ляжет на плечи подставного владельца кошелька, а настоящие преступники останутся незамеченными.

Чтобы изготовить паспорт, которым преступник сможет полноценно пользоваться, недостаточно подделать водяные знаки — паспорт с фальшивыми данными не пройдет ни одну проверку в электронных базах.

Поэтому мошенники используют информацию из настоящего документа, а фотографию в фальшивый паспорт вклеивают свою. По паспорту с реальными данными, но фотографией афериста можно брать кредиты в мелких организациях, не вызывая подозрений, — а отвечать по долгам придется владельцу настоящего паспорта.

Выяснить номер телефона по паспортным данным несложно. Многие указывают его на страницах в соцсетях или на страницах-визитках, которые можно найти, просто набрав имя и фамилию жертвы в поисковике.

Мошенник размещает объявление о продаже дорогой вещи по бросовой цене: утверждает, что надо продать срочно, поэтому и скидка большая. А так как цена привлекательная, то и желающих много, поэтому аферист настаивает на предоплате: чтобы не терять время, если покупатель вдруг передумает. В качестве гарантии липовый продавец высылает скан паспорта — разумеется, чужого, а после получения денег перестает отвечать на сообщения.

Это только цветочки, а бывают и ягодки!

Это только для того, чтобы вы относились к безопасности вашего сервера серьёзно! Даже если у вас простенький сайт без каких-либо конфидециальных данных.

2. Введение.

Немного напугал, перейдём к теме серверов и их безопасности.

Защита информации становится необходимостью для предотвращения потенциальных угроз и минимизации рисков.

Защита информации обеспечивает личную безопасность и приватность, предотвращает утечку личных данных и защищает от возможных мошеннических действий.

Под термином «угроза» следует понимать любое программное средство, косвенно или напрямую способное нанести ущерб компьютеру, сети, информации или правам пользователя (то есть вредоносные и прочие нежелательные программы). В более широком смысле термин «угроза» может означать любую потенциальную опасность для компьютера или сети (то есть ее уязвимость, которая может быть использована для проведения хакерских атак).

Сетевая атака – это вторжение в операционную систему удаленного компьютера. Злоумышленники предпринимают сетевые атаки, чтобы захватить управление над операционной системой, привести ее к отказу в обслуживании или получить доступ к защищенной информации.

Следует понимать, что защита от взлома серверов — это комплекс мер, в том числе подразумевающий постоянный мониторинг работы сервера и работу по совершенствованию защиты. Невозможно защитить сервер от внешнего доступа раз и навсегда, ведь каждый день обнаруживаются новые уязвимости и появляются новые способы взлома сервера.

Основной признак попыток — «подозрительная активность» в логах. Это могут быть регулярные попытки подключения с разных IP-адресов, запросы к различным портам сервера, запросы на те или иные ресурсы.

Лог (log) — это текстовый файл, куда автоматически записывается важная информация о работе системы или программы. Чаще всего говорят о логах сервера. Их записывает программное обеспечение, которое управляет внутренней частью сайта или онлайн-системы. Лог-файл — своеобразный журнал событий.

В логи записываются сведения об ошибках, действиях пользователей и других событиях, которые происходят на сервере или в системе.

Чтобы обнаружить угрозу, необходимо регулярно анализировать все логи, начиная с системных, и заканчивая логами различных утилит, которые работают на вашем сервере.

Однако, анализировать логи вручную - не самая лучшая затея, хотя и вполне возможная. Для анализа логов существуют специальнные утилиты автоматического анализа и блокирования несанкционированного доступа. В простейшем случае они анализируют логи на подозрительную активность и при необходимости блокируют все попытки несанкционированного получения доступа на те или иные ресурсы сервера.

Что значит несанкционированного?

Несанкционированно - осуществляемый без санкции, официального разрешения. Т.е. в нашем случае при самом простом способе прямого входа на ваш веб-сайт через веб-браузер вы увидите в логах действительные статусы состояний сервера. При любой попытке обойти формы ввода логина и пароля, даже напрямую вручную через браузер, в логи будет выведен совершенно другой статус состояния вашего сайта или всего сервера. При этом там же будут отображены все попытки запросов и все адреса и порты, на которые происходили запросы. В случае же использования любых утилит - не браузеров - эта информация сразу же отобразится в логах.

Обычно любая утилита или программа (не важно Windows или Linux) во время запроса обязательно вставляет в посылаемый на сервер запрос (пакет) минимальную информацию о себе. В случае же хакерских утилит такой информации не будет.

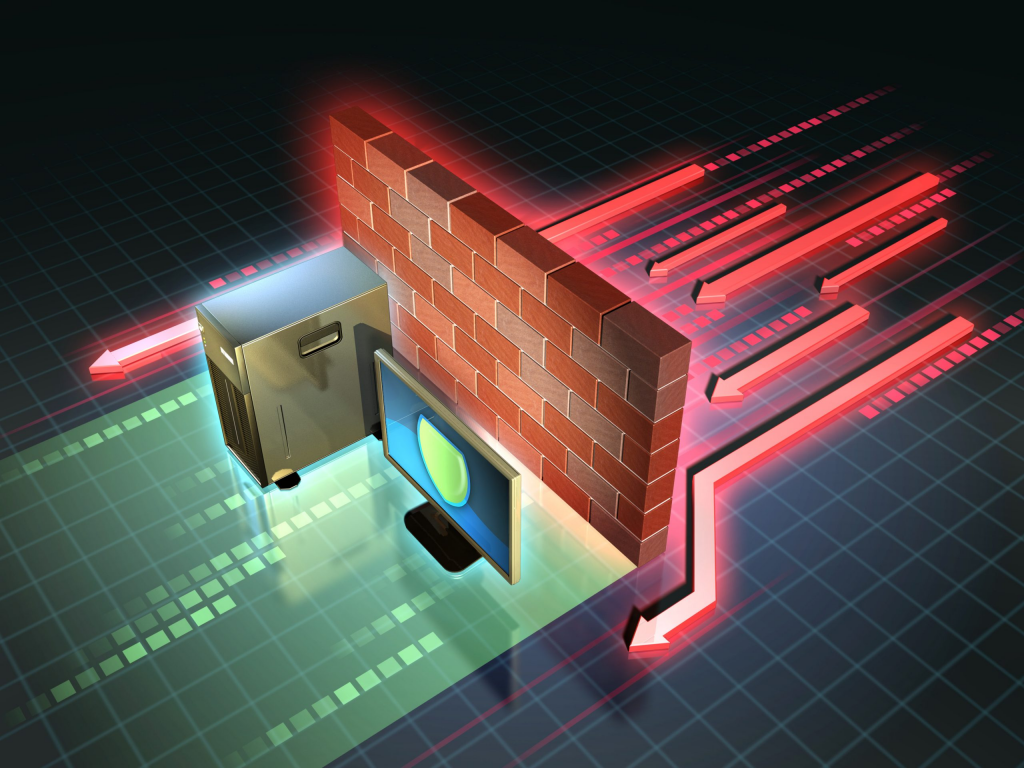

Посмотрим на частичный лог одного веб-сайта. IP-ардеса и некоторые другие данные лога я закрасил в целях безопасности.

Мы здесь можем видеть - что некий IP-адрес (пользователь, закрашен в самой левой части перед датой и временем) делает GET-запрос. При этом у адреса есть операционная система, и делает он свой запрос через браузер Google-chrome. Ну и соответственно видим дату и время запроса, а также статус состояния сайта, т.е. ответ веб-сайта.

Судя по этой скудной информации мы можем сделать вывод о том, что некий пользователь напрямую через веб-браузер, т.е. санкционированно, обращался к некому веб-сайту.

В последних 2 строках GET-запросы происходили не через браузер и с помощью утилиты Curl. При этом видим также и версию этой утилиты.

В этих последних строках из-за статуса состояния сайта мы можем сделать вывод о том, что запрос хоть и был санкционированный, но не прямой, т.е. не через веб-браузер, и к этому стоит присмотреться.

Существуют утилиты не только для автоматического мониторинга работы сервера и его доступности в интернете, но и оповещения по электронной почте или СМС в случае обнаружения проблем.

Причём располагать утилиты мониторинга доступности сервера в интернете и оповещений непосредственно на самом сервере - не самая лучшая затея, хотя и вполне реализуемая и частенько практикуемая. Практикуемая именно потому что денег на второй сервер только для мониторинга нет. Такие утилиты вполне можно установить на сервер в виртуальной машине, которая будет не доступна из интернета, тем самым защищена. Она же и будет производить мониторинг работы и оповещать в случае проблем. Однако, не все могут оставить работать свой ПК с работающей виртуальной машиной на круглосуточную работу ради одного сервера. Обычно так делают когда серверов много.

Кстати говоря, любые подобные утилиты мониторинга и оповещений вполне можно создать самостоятельно.

Сегодня мы с вами рассмотрим одну из утилит для блокировки вторжений на сервер. Рассматривать утилиты оповещений и мониторинга сегодня мы не будем.

Однако, это не говорит о том, что при использовании утилит блокировок вам не нужно будет использовать утилиты мониторинга или антивирусные средства. Как раз наоборот.

Просто базовое понимание утилит блокировки даст вам понимание того, как запускать все программы и под-программы мониторинга, блокировок и оповещений одновременно так, чтобы данные получаемые из логов были на тот момент актуальными и одинаковыми для всех утилит. Иначе вы можете столкнуться с тем, что для одной из программ в логах у вас будут одни данные, для другой уже другие. В результате одна из утилит просто не сработает во время. Или вообще пропустит важные данные для обработки результата.

Чем это чревато? Надеюсь, вы и сами понимаете!

Также, этот же момент не говорит о том, что вам всё равно не придётся создавать регулярные резервные копии данных сайта или всего сервера. Потому что взломать можно всё что угодно! Было бы желание. Вот как раз на случай проникновения и/или захвата управления, чтобы иметь возможность быстро восстановить сервер после атаки, как раз и нужны резеревные копии данных.

Помимо описанного, необходимо регулярно следить за обновлениями программного обеспечения и операционной системы сервера. Обновления обычно устраняют уязвимости, которые могут использоваться для проведения атак.

3. Одновременный доступ к файлам журналов.

При чтении или записи любого файла создаётся так называемый файловый дескриптор.

Файловый дескриптор — это неотрицательное число, которое является идентификатором потока ввода-вывода. Дескриптор может быть связан с файлом, каталогом, сокетом.

Например, когда вы открываете или создаете новый файл, операционная система формирует для себя запись для представления этого файла и хранения информации о нем. У каждого файла индивидуальный файловый дескриптор Linux.

В Linux библиотека libc открывает для каждого запущенного приложения(процесса) 3 файл дескриптора, с номерами 0,1,2.

- Файл дескриптор 0 называется STDIN и ассоциируется с вводом данных у приложения.

- Файл дескриптор 1 называется STDOUT и используется приложениями для вывода данных, например командами print.

- Файл дескриптор 2 называется STDERR и используется приложениями для вывода данных, сообщающих об ошибке.

Если в вашей программе вы откроете какой-либо файл на чтение или запись, то скорее всего вы получите первый свободный ID и это будет номер 3.

Файл дескриптор с номером 255 можете смело игнорировать, он был открыт для своих нужд уже самим bash, а не прилинкованной библиотекой.

Например, откроем консоль с bash и посмотрим PID нашего процесса.

[user@localhost Загрузки]$ echo $$ 11644 [user@localhost Загрузки]$ ls -lha /proc/11644/fd/ итого 0 dr-x------ 2 user users 0 июл 22 08:26 . dr-xr-xr-x 9 user users 0 июл 22 08:26 .. lrwx------ 1 user users 64 июл 22 08:26 0 -> /dev/pts/1 lrwx------ 1 user users 64 июл 22 08:26 1 -> /dev/pts/1 lrwx------ 1 user users 64 июл 22 08:26 2 -> /dev/pts/1 lrwx------ 1 user users 64 июл 22 08:26 255 -> /dev/pts/1 [user@localhost Загрузки]$

Сейчас все 3 файл дескриптора связаны с устройством псевдотерминала /dev/pts, но мы все равно можем ими манипулировать, например запустим во второй консоли.

[user@localhost ]$ echo "hello world" > /proc/11644/fd/0

И в первой консоли мы увидим.

[user@localhost ]$ hello world

Вы можете легко переопределить эти 3 файл дескриптора в любом процессе, в том числе и в bash, например через трубу(pipe), соединяющую два процесса.

Продолжение смотрите в статье: «Файл дескриптор в Linux с примерами».

Допустим нас есть некий лог-файл, в который постоянно ведётся запись разных данных. Например, в лог-файл NGINX-а запись будет производиться только при поступления запроса на сервер и только на тот веб-адрес, который имеется в настройках конфигурации.

К примеру, у нас есть несколько программ в виде коротких скриптов, которые постоянно с разными временными задержками анализируют этот лог-файл.

Возникает логичный вопрос: А одинаковые ли будут данные у каждого из этих скриптов для анализа?

Проведём небольшой эксперимент. Для этого создадим 3 разных скрипта. Один будет записывать данные в некий предопределённый нами лог-файл, а 2 других читать этот лог и выводить результат чтения на экран.

Файл «./write.sh». Здесь мы будет 10 раз записывать время с секундами и наносекундами в лог-файл «./text.log», но с задержкой между записями в 2 секунды. Т.е. итоговое время выполнения, по идее, должно быть 18 секунд, включая вывод на экран.

$ nano ./write.sh

#!/bin/bash

echo "" > text.log

for x in {1..10}; do

_date=$(date '+%H:%M:%S:%N')

_random=$(echo "${_date}" | rev | cut -d ':' -f1 | rev)

echo "${_date} - ${_random}"

echo "${_date} - ${_random}" > text.log

sleep 2

done

exit 0

CTRL + o

CTRL + x

Файл «./read.sh». Здесь мы будет читать наш лог-файл «./text.log», но вместо простого вывода содержимого на экран будем подсчитать количество строк в этом файле, что будет несколько нагляднее. Читать будем 3 раза с задержкой открытого файла дескриптора на 1 секунду в каждый цикл чтения. Итоговое время выполнения, по идее, должно быть 3 секунды.

$ nano ./read.sh

#!/bin/bash

for x in {1..3}; do

date '+%H:%M:%S:%N'

count=0

while read line; do

let count+=1

sleep 1

done <text.log

echo "${count}"

date '+%H:%M:%S:%N'

echo ""

done

exit 0

CTRL + o

CTRL + x

Файл «./read2.sh». Ну а в этом скрипте мы также будем читать наш лог-файл «./text.log», но с задержкой файла-дескриптора уже на 2 секунды при каждом цикле чтения. Итоговое время выполнения, по идее, должно быть 6 секунд.

$ nano ./read2.sh

#!/bin/bash

for x in {1..3}; do

date '+%H:%M:%S:%N'

count=0

while read line; do

let count+=1

sleep 2

done <text.log

echo "${count}"

date '+%H:%M:%S:%N'

echo ""

done

exit 0

CTRL + o

CTRL + x

Теперь, откроем 3 разных косноли и попытаемся быстро-быстро запустить эти скрипты одновременно. Разумеется они будут работать не одновременно. Однако, из-за временных sleep задержек это будет не важно.

Смотрим на результат.

Как видите, и в первой и во второй консоли, из-за того, что скрипты долго держат файловый дескриптор открытым, они продолжают читать старый файл. Таким образом скрипты продолжает использовать старые данные и не успевают получить новые для обработки, в то время как в лог-файл уже была произведена запись и он был обновлён.

Более того, 2-й скрипт «./read2.sh» вообще потерял много данных, а задержка была неоправдано долго и в данном случае именно из-за того, что файловый дескриптор уже был открыт другим процессом, т.е. занятым в этот момент.

В простонародье говорят, что файл-журнала успел отротироваться, в то время как один из скриптов продолжает читать старый файл, уже после его ротации. При этом, открытый файловый дескриптор на чтение не позволяет другому скрипту прочитать тот же самый файл, и второму скрипту приходится ждать закрытия файлового дескриптора.

Под таким понятием как «ротация» подразумевается переодическая и в тоже время последовательная и целенаправленная смена чего-то или же кого-то.

В итоге, из-за такой, казалось бы, простой операции как «Чтение файла» - образовалась маленькая локальная война за ресурсы, в результате которой было потеряно много данных.

Проблема чтения данных ещё состоит и в том, что практически все утилиты или скрипты анализа лог-файлов могут быть очень разными и сложными, или наоборот простыми. Какие-то из них потребляют мало оперативной памяти, а какие-то напротив - очень много.

Уменьшать время работы одной из утилит ради ускорения обработки данных очень и очень плохая затея! Ведь таким образом вы можете чрезмерно нагрузить и процессор и оперативную память. А если у вас VPS или VDS сервер с ограниченным количеством ресурсов - в результате вы можете просто напросто зависнуть. Да-да, в Linux-е и зависнуть. Это не шутка!

Этот маленький эксперимент должен был сказать вам не о том, что необходимо уменьшать время запуска тех или иных программ или скриптов анализа, а о том, что анализировать данные лучше какой-то одной единственной утилитой, и уже в ней, внутри, запускать все остальные необходимые вам внешние скрипты и программы обработки результатов, при обнаружении проблем. При условии, что такая функция запуска внешних скриптов или программ имеется внутри утилиты анализа.

Обычно, у всех программ и утилит анализа имеются специальные макросы для запуска внешних программ или скриптов для обработки результатов или запуска какого-нибудь действия / противодействия в самой ОС.

Если же возможности самого анализа как такового ограничены - тогда да, запуск отдельной программы или отдельного скрипта в системе по таймеру - будет хорошим выходом из ситуации.

Но, тогда вы, скорее всего, будете вынуждены подбирать и калибровать время запуска по таймеру только ради 2 вышеуказанных условий - аткуальность данных и нагрузка на оперативную память.

Актуальность данных подразумевает несколько важных пунктов.

- Как часто обновляется нужный вам лог-файл, т.е. как часто в него записываются новые данные?

- Как часто необходимо анализировать лог-файл?

В зависимости от данных ответов настраивается время таймера.

Нагрузка же на процессор имеет немного более высокий приоритет. Для корректной настройки вам также необходимо будет ответить на пару вопросов.

- Сколько максимально в пике оперативной памяти потребляет ваша утилита или скрипт?

- Как сильно ваша утилита или скрипт нагружают процессор?

Последние 2 вопроса имеют место быть, в случае, когда утилита имеет внутри себя множество различных сложных вычислений. В таком случае стоит задуматься насчет частоты запуска и соответственно об увеличении времени таймера для её запуска.

При этом как именно будет запускаться утилита или скрипт не особо играет роли - будь то системный systemd-таймер или процесс запущенный из под сервиса cron, т.е. crontab.

4. Межсетевые экраны.

Содержание главы.

- История, определения.

- Netfilter

- Таблицы и цепочки IPTables.

- NFTABLES.

- UFW / Firewalld.

- Примеры использования UFW / Firewalld.

4.1. История, определения.

Рассмотрим первую линию обороны - межсетевые экраны.

Брандмауэр, фаервол или межсетевой экран – это система, которая выполняет роль защитной стены между глобальным интернетом и устройством пользователя.

Брандмауэр фильтрует всю входящую информацию и не пропускает вредоносный контент и вирусы.

Брандмауэры, как правило, контролируют двунаправленный поток трафика, поэтому представьте себе брандмауэр перед организацией, отделяющий ее от общедоступного Интернета. Он должен иметь возможность блокировать входящий трафик, чтобы попытаться удержать злоумышленников, но он также должен иметь возможность разрешать исходящий трафик, потому что людям нужно просматривать веб-страницы, отправлять электронные письма и иметь связь, которая выходит за пределы сети.

Наиболее распространённое место для установки межсетевых экранов — граница периметра локальной сети для защиты внутренних хостов от атак извне. Однако атаки могут начинаться и с внутренних узлов — в этом случае, если атакуемый хост расположен в той же сети, трафик не пересечёт границу сетевого периметра, и межсетевой экран не будет задействован. Поэтому в настоящее время межсетевые экраны размещают не только на границе, но и между различными сегментами сети, что обеспечивает дополнительный уровень безопасности.

Программные межсетевые экраны появились существенно позже и были гораздо моложе, чем антивирусные программы. Например, проект «Netfilter/iptables» (один из первых программных межсетевых экранов, встраиваемых в ядро Linux с версии 2.4) был основан в 1998 году.

Фильтрация трафика осуществляется на основе набора предварительно сконфигурированных правил, которые называются ruleset. Удобно представлять межсетевой экран как последовательность фильтров, обрабатывающих информационный поток. Каждый из фильтров предназначен для интерпретации отдельного правила. Последовательность правил в наборе существенно влияет на производительность межсетевого экрана. Например, многие межсетевые экраны последовательно сравнивают трафик с правилами до тех пор, пока не будет найдено соответствие.

Существует два принципа обработки поступающего трафика. Первый принцип гласит: «Что явно не запрещено, то разрешено». В данном случае, если межсетевой экран получил пакет, не попадающий ни под одно правило, то он передаётся далее. Противоположный принцип — «Что явно не разрешено, то запрещено» — гарантирует гораздо большую защищённость, так как он запрещает весь трафик, который явно не разрешён правилами. Однако этот принцип оборачивается дополнительной нагрузкой на администратора.

В конечном счёте межсетевые экраны выполняют над поступающим трафиком одну из двух операций: пропустить пакет далее (allow) или отбросить пакет (deny). Некоторые межсетевые экраны имеют ещё одну операцию — reject, при которой пакет отбрасывается, но отправителю сообщается о недоступности сервиса, доступ к которому он пытался получить. В противовес этому, при операции deny отправитель не информируется о недоступности сервиса, что является более безопасным.

Перейти к оглавлению. Перейти к главе.

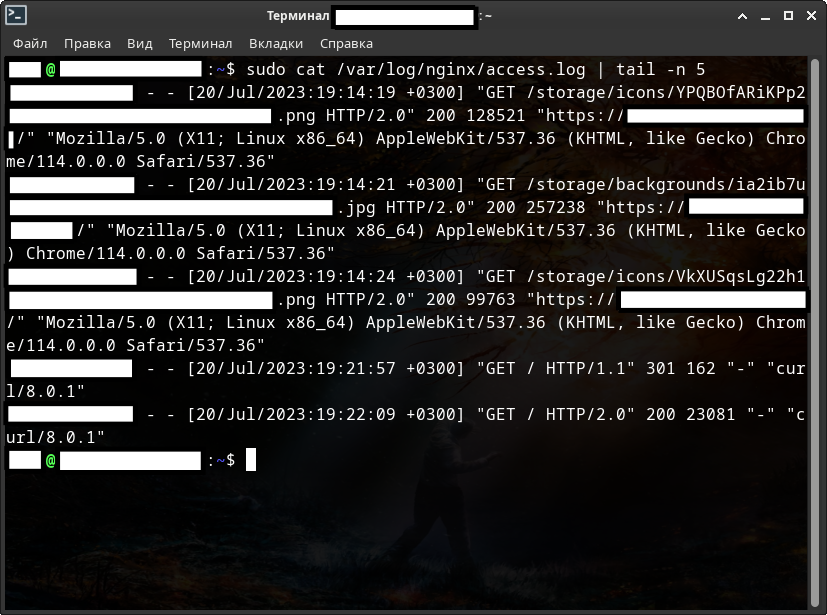

4.2. Netfilter.

Посмотрим на компаненты, которые входят в состав Netfilter.

Все компаненты обозначенные голубым цветом - это пользовательские утилиты, т.е. програмная часть, с помощью которых осуществляется доступ к нижележащим таблицам фильтрации и преобразования пакетов. У «{ip,ip6,arp,eb}tables» в итоге к «Xtables», соответственно у «iptables-nftables» и «nft» к «nf_tables».

Долгое время «Xtables», встроенная в ядро, считалась единственным способом управления Netfilter-ом.

iptables — утилита командной строки для настройки встроенного в ядро Linux межсетевого экрана, разработанного в рамках проекта Netfilter.

Термином iptables также часто называют сам межсетевой экран в ядре. Настройка экрана выполняется либо напрямую с помощью iptables, либо через один из фронтендов, консольных или графических. iptables работает с протоколом IPv4, для IPv6 разработана утилита ip6tables. В основном их синтаксис совпадает, но некоторые специфичные для протоколов опции различаются.

Тем временем постепенно развивался проект «nf_tables». Проект должен и выступил в качестве замены существующего фреймворка «{ip,ip6,arp,eb}tables» в 2021 году.

Этот проект предоставляет новую систему фильтрации пакетов, пользовательскую утилиту ntf, а также слой совместимости с {ip,ip6}tables. nftables использует существующие хуки, отслеживание соединений, очереди в пространстве пользователя и подсистему логирования netfilter.

Фреймворк iptables постепенно выходит из употребления; более современная замена — nftables, в котором предусмотрен слой совместимости.

В Debian 11 фреймворк nftables встроен в систему по умолчанию со слоем совместимости для iptables.

IPTABLES умер в 2021 году. Он конечно всё ещё встроен во многие системы, но постепенно будет полностью заменён на более эффективный NFTABLES.

Плохая новость: документация «NFTABLES» («nft»: man nft) содержит больше 3 тысяч строк.

Для облегчения перехода можно конвертировать правила iptables в nftables с помощью утилит iptables-translate, iptables-restore-translate, iptables-nft-restore и т.п. Утилиты находятся в пакете iptables, который необходимо установливать отдельно.

Грубо говоря, Netfilter по сути является как бы внутренней обороной ОС. Однако, самой ОС нужна ещё и внешняя оборона - инструмент или средство для управления брандмауэром, такие как UFW или Firewalld.

UFW (Uncomplicated Firewall) - является самым простым и довольно популярным инструментарием командной строки для настройки и управления брандмауэром.

Firewalld — программное обеспечение для управления брандмауэрами, поддерживаемое многими дистрибутивами Linux.

Чтобы понять как работает фильтрация пакетов в межсетевых экранах, для этого надо заглянуть в раздел «Таблицы и цепочки IPTABLES».

Перейти к оглавлению. Перейти к главе.

4.3. Таблицы и цепочки IPTables.

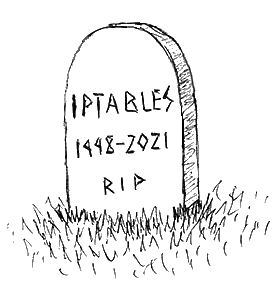

Чтобы разобрать работу Netfilter/iptables возьмём схему работы из википедии.

Ну, а для базового понимания схемы разберём с вами основные понятия: таблицы, цепочки, действия над пакетами и механизм определения состояния.

Каждый из пунктов важен для понимания работы любого межсетевого экрана.

Цепочки.

- PREROUTING - для изначальной обработки входящих пакетов.

- INPUT - для входящих пакетов, адресованных непосредственно локальному компьютеру.

- FORWARD - для проходящих (маршрутизируемых) пакетов.

- OUTPUT - для пакетов, создаваемых локальным компьютером, т.е. исходящих.

- POSTROUTING - для окончательной обработки исходящих пакетов.

Цепочки можно создавать самостоятельно, и также их уничтожать.

Почти в каждой цепочке имеется 4 таблицы:

- raw - пакет проходит данную таблицу до передачи системе определения состояний. Используется редко, например для маркировки пакетов, которые НЕ должны обрабатываться системой определения состояний. Для этого в правиле указывается действие NOTRACK. Содержитcя в цепочках PREROUTING и OUTPUT.

- mangle - содержит правила модификации IP‐пакетов. Среди прочего, поддерживает действия TTL, TOS, и MARK (для изменения полей TTL и TOS, и для изменения маркеров пакета). Редко необходима и может быть опасна.

- nat - предназначена для подмены адреса отправителя или получателя. Данную таблицу проходят только первый пакет из потока, трансляция адресов или маскировка (подмена адреса отправителя или получателя) применяются ко всем последующим пакетам в потоке автоматически. Поддерживает действия DNAT, SNAT, MASQUERADE, REDIRECT. Содержится в цепочках PREROUTING, OUTPUT, и POSTROUTING.

- filter - основная таблица, используется по умолчанию если название таблицы не указано. Используется для фильтрации пакетов. Содержится в цепочках INPUT, FORWARD, и OUTPUT.

Действия над пакетами.

- ACCEPT - принять пакет.

- DROP - отбросить пакет, при этом пакет не передается в другие таблицы/цепочки.

- REJECT - отбросить пакет, отправив отправителю ICMP-сообщение, при этом пакет не передается в другие таблицы/цепочки.

- RETURN - возвратить пакет в предыдущую цепочку и продолжить ее прохождение начиная со следующего правила.

- SNAT - применить трансляцию адреса источника в пакете. Может использоваться только в цепочках POSTROUTING и OUTPUT в таблицах nat.

- DNAT - применить трансляцию адреса назначения в пакете. Может использоваться в цепочке PREROUTING в таблице nat.

- LOG - протоколировать пакет и обработать остальными правилами.

- MASQUERADE - используется вместо SNAT при наличии соединения с динамическим IP (допускается указывать только в цепочке POSTROUTING таблицы nat).

- MARK - используется для установки меток на пакеты, передается для обработки дальнейшим правилам.

Есть и другие действия. Остановимся на базовых.

Механизм определения состояний (conntrack).

В общем, механизм определения состояний (он же state machine, он же connection tracking, он же conntrack) является частью пакетного фильтра и позволяет определить определить к какому соединению/сеансу принадлежит пакет.

Conntrack анализирует состояние всех пакетов, кроме тех, которые помечены как NOTRACK в таблице raw. На основе этого состояния определяется принадлежит пакет новому соединению (состояние NEW), уже установленному соединению (состояние ESTABLISHED), дополнительному к уже существующему (RELATED), либо к "другому" (неопределяемому) соединению (состояние INVALID). Состояние пакета определяется на основе анализа заголовков передаваемого TCP-пакета. Модуль conntrack позволяет реализовать межсетевой экран сеансового уровня (пятого уровня модели OSI). Для управления данным механизмом используется утилита conntrack, а так же параметр утилиты iptables: -m conntrack или -m state. Состояния текущих соединений conntrack хранит в ядре. Их можно просмотреть в файле /proc/net/nf_conntrack (или /proc/net/ip_conntrack).

Итак, разберём схему работы.

Пакет (из интернета в сеть, затем) из сети обязательно проходит цепочку PREROUTING, далее попадает в таблицу маршрутизации и в зависимости от принадлежности определяет куда пойдёт дальше. Если пакет не адресован локальной системе, он попадёт в цепочку FORWARD. Если адресован - в цепочку INPUT. После INPUT пакет обрабатывают системные процессы и демоны. После локальной обработки программы могут сформировать ответ и этот ответ в соответствии с правилами маршрутизации направляется в цепочку OUTPUT. Затем снова маршрутизируется и наконец попадает в цепочку POSTROUTING, как и пакет из цепочки FORWARD. И только после всех этих манипуляций с пакетом он наконец вновь отправляется обратно в сеть и уже дальше в интернет, если стоит такая задача.

Почему пакет несколько раз проходит через таблицу маршрутизации?

Каждая цепочка, которую проходит пакет состоит из набора таблиц (table). Таблицы в разных цепочках имеют одинаковое наименование, но тем не менее никак между собой не связаны. Например таблица nat в цепочке PREROUTING никак не связана с таблицей nat в цепочке POSTROUTING. Каждая таблица состоит из упорядоченного набора (списка) правил. Каждое правило содержит условие, которому должен соответствовать проходящий пакет и действия к пакету, подходящему данному условию.

Проходя через серию цепочек пакет последовательно проходит каждую таблицу и в каждой таблице последовательно сверяется с каждым правилом, и если пакет соответствует какому-либо критерию, то выполняется заданное действие над пакетом. При этом, в каждой таблице (кроме пользовательских) существует заданная по-умолчанию политика. Данная политика определяет действие над пакетом, в случае, если пакет не соответствует ни одному из правил в таблице. Чаще всего - это действие ACCEPT, чтобы принять пакет и передать в следующую таблицу или DROP - чтобы отбросить пакет. В случае, если пакет не был отброшен, он завершает свое путешествие по ядру системы и отправляется в сетевой интерфейс, которая подходит по правилам маршрутизации.

Таблица nat и mangle может модифицировать получателя или отправителя сетевого пакета. Именно поэтому сетевой пакет несколько раз сверяется с таблицей маршрутизации.

Блокировку и разблокировку ip-адресов, разрешающие и запрещающие правила, а также сохранение состояния при перезагрузке ОС вы можете посмотреть в статье: «Безопасность сетевых соединений: 6. Блокировка ip адреса или всей подсети».

Перейти к оглавлению. Перейти к главе.

4.4. NFTABLES.

В отличие от iptables, в nftables отсутствуют встроенные таблицы. Количество таблиц и их имена определяется пользователем. Тем не менее, каждая таблица имеет только одно семейство адресации и применяется к пакетам только этого семейства.

В отличие от iptables, в nftables отсутствуют встроенные цепочки. Соответственно, если опрелённые типы или хуки фреймворка netfilter не задействованы ни в одной цепочке, то проходящие через эти цепочки пакеты обрабатываться не будут (в отличие от iptables).

Есть два типа цепочек. Базовая цепочка является точкой входа для пакетов из сетевого стека; в ней указывается хук. Обычная цепочка может использоваться в качестве цели перехода и используется для лучшей организации правил.

Все спрашивают почему я так люблю Acrhlinux - как минимум за его прекрасную векипедию. Поэтому более подробную информацию о работе с NFTABLES вы можете найти на его страницах в статье: «ArchWiki: nftables (Русский)», а если вам будет мало этой информации и у вас по прежнему останутся пару вопросов - добро пожаловать в статью на losst.pro: «losst.pro: Как пользоваться nftables».

В этих статья подробно с разъяснено как работать с NFTABLES. Словом, мне дополнить нечем. Читайте внимательно, тогда ничего не пропустите и вам всё будет понятно.

Разьве что раздел установки для разных дистрибутивов Linux будет у всех разный. Во всём остальном - и настройки и работа с фреймворком будет абсолютно одинаковой.

Но самое главное в том, что знание схемы движения пакетов в системе IP(6)TABLES даёт вам базовое понимание того, какие таблицы и цепочки с предопределёнными типами и хуками для работы вашего сервера нужно будет создавать, а также какие правила и приоритеты устанавливать для этих цепочек. Понимание работы IP(6)TABLES значительно ускоряет процес настройки.

Также уделите внимание Firewalld, ибо с ним, вам в разы меньше придётся создавать различных таблиц, цепочек и правил поведения вашего сервера, включая nat-преобразование адресов, в разы будет усилена защита, но также может и в разы усложниться жизнь при работе с различными сервисами в т.ч. базами данных.

Перейти к оглавлению. Перейти к главе.

4.5. UFW / Firewalld.

Cерверы постоянно подвергаются различным атакам или сканируются в поиске уязвимостей. Как только эти уязвимости находятся, мы рискуем стать частью ботнета, раскрыть конфиденциальные данные или потерять деньги из-за сбоев в работе веб-приложений. Одной из первых мер по снижению рисков безопасности является грамотная настройка правил межсетевого экрана.

UFW (Uncomplicated Firewall) — удобный интерфейс для управления политиками безопасности межсетевого экрана. Он представляет собой интерфейс iptables, предназначенный для упрощения процесса настройки брандмауэра. Хотя iptables — надежный и гибкий инструмент, начинающим бывает сложно научиться использовать его для правильной настройки брандмауэра.

Подробно об установке и настройке UFW фаервола вы можете посмотреть в статье: «Безопасность сетевых соединений: 4. Фаерволы: 4.1. Фаервол UFW».

По сути UFW и Firewalld это фасад сервера, а {IP,IP6,ARP,EB}Tables / NFTables - это интерьер.

Firewalld - более продвинутая утилита управления Linux брандмауэром Netfilter. Несмотря на собственный синтаксис, имеет такой же принцип работы, как и Iptables.

В отличие от IPTABLES имеет более продвинутую безопасность, настройки, стабильную работу, а также сохранение правил фильтрации и маршрутизации без лишних скриптов и сервисов, и многое другое.

Подробно об установке и настройке Firewalld фаервола вы можете посмотреть в статье: «Безопасность сетевых соединений: 4. Фаерволы: 4.2. Фаервол Firewalld».

Удивительно, но Docker не работает из коробки с UFW, т.е. «Universal Firewall» Linux.

Проблема в том, что UFW и Docker пытаются изменить одни и те же базовые правила брандмауэра. В результате фаервол разрешает трафику идти дальше к Docker-контейнерам.

Допустим вы настроете базовый брандмауэр UFW на запрет по умолчанию и сделаете разрешение по HTTP и SSH портам. Однако, UFW не будет блокировать доступ к Docker-контейнерам, которые привязаны к другим портам.

Эту проблему может быть трудно обнаружить, поскольку UFW и Docker – это отдельные системы.

Тем не менее, UFW покажет, что всё настроено верно и с вашего рабочего места так и будет выглядеть, даже с учетом белого списка доступа. В результате вам будет казаться что всё в порядке. Но это не так!

Если какое-либо приложение запущено через Docker, например на порту 8000, то по умолчанию это приложение будет видно из любого места за пределами сервера.

Это может стать серьезной проблемой, если вы не решите ее! Потому что у любого пользователя интернета появляется возможность обращаться к любым сервисам внутри сервера по портам, включая и базы данных, и сервисы контроля баз (например, PHPMyAdmin). При этом пределить доступные порты для подключения абсолютно не сложно.

Для совмещения Docker-а и UFW воспользуйтесь статьёй: «Как использовать Docker с UFW параллельно».

Однако, не спешите переходить по ссылке. В данной статье используются решения, основанные на IPTABLES, фреймворке, который постепенно выходит из употребления.

Эти правила специфичны для каждого отдельного сервера и их придётся корректировать, чтобы они работали правильно. А самое забавное в том, что когда вы будете запускать какой-то новый Docker-контейнер - правила снова придётся корректировать. Плюс ко всему их обязательно необходимо восстанавливать при перезапуске ОС.

Не факт, что у вас получится, но если получится - вы счастливчик. Но, опять таки, не спешите радоваться. Потому что ваша настройка, скорее всего, продержится максимум лет 5...10, пока последний фреймворк полностью не заместит всеми любимый IPTABLES.

Из сложившейся ситуации есть выход - фаервол Firewalld.

В свою очередь он требует тщательной настройки и понимания как всё устроено! А самое главное - он легко совмещается с Docker-контейнерами.

Перейти к оглавлению. Перейти к главе.

4.6. Примеры использования UFW / Firewalld.

Вот тут начинается самое интересное!

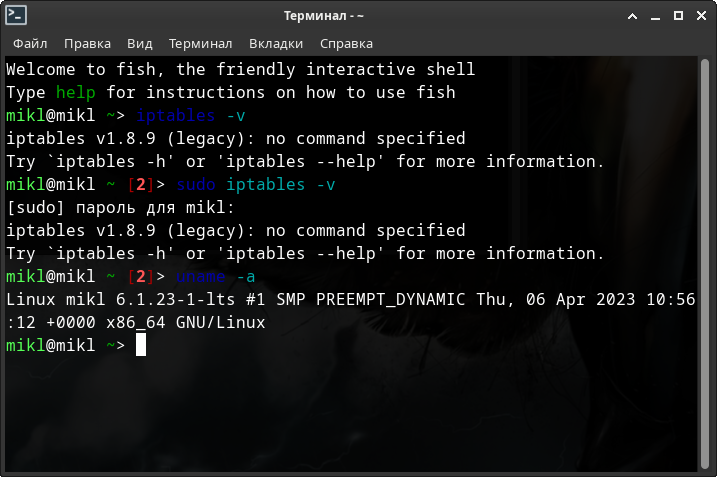

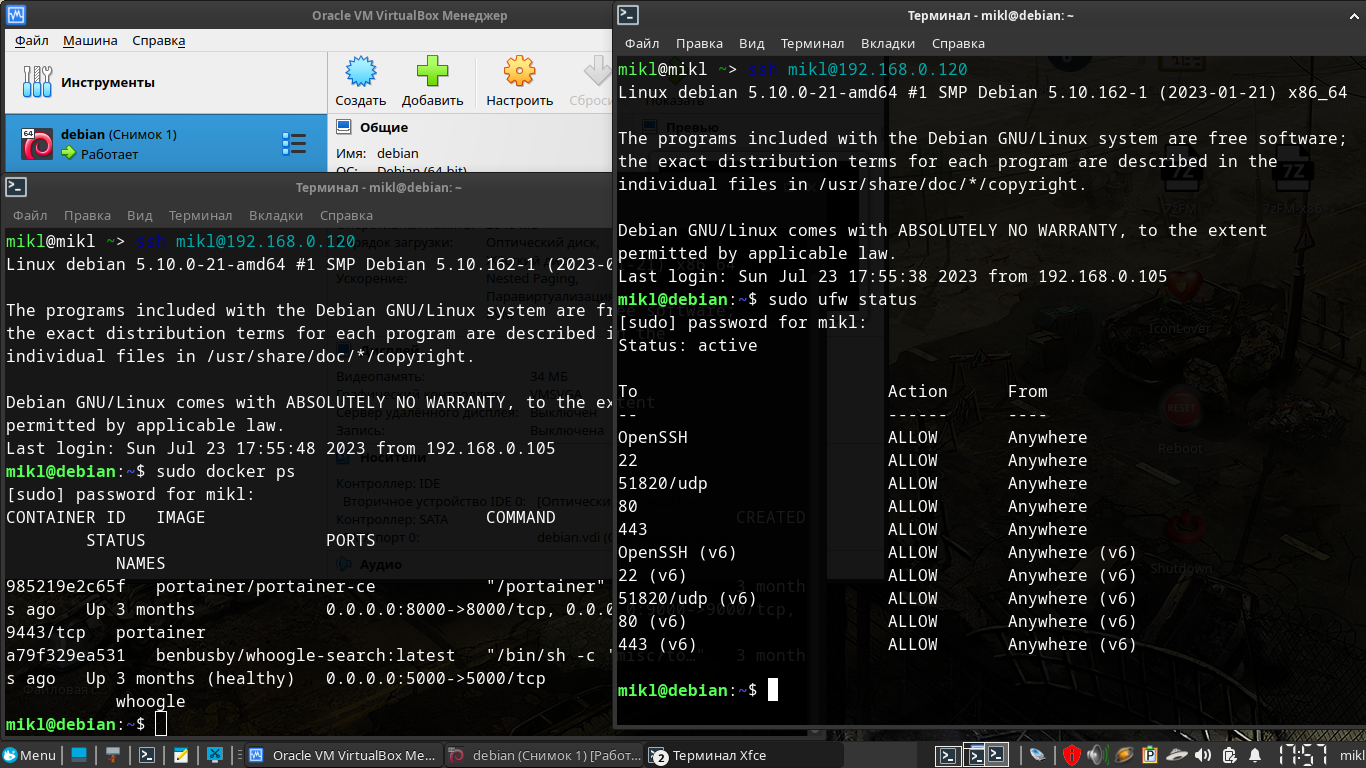

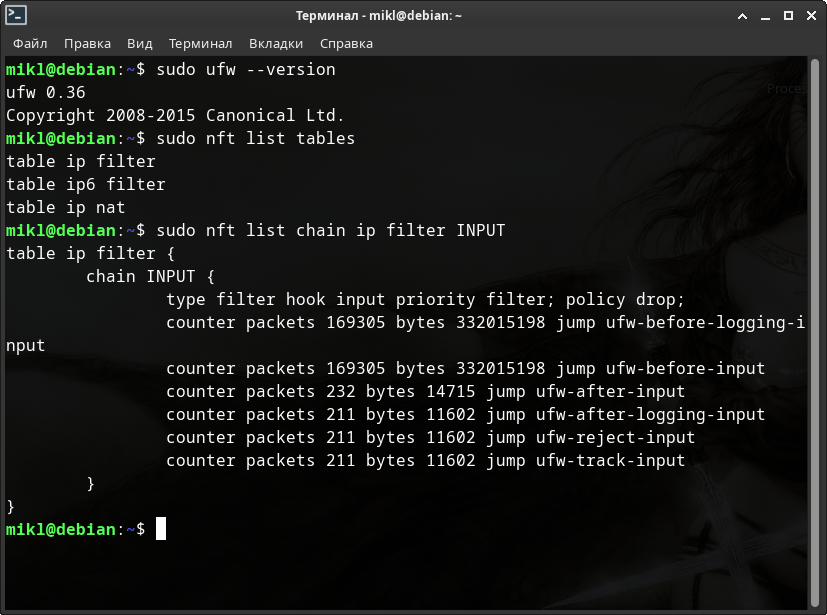

Рассмотрим с вами несколько примеров на основе моего Archlinux на ноутбуке и виртуальной машине на Debian 11 со следующими характеристиками:

Самое главное здесь то, что сеть установлена в режиме сетевого моста. Таким образом, если в ОС нет никаких фаерволов, кроме межсетевого экрана, то все внутренние сервисы должны быть доступны в локальной сети по IP-адресу, буквально напрямую.

Последовательно произведём все, почте без исключения, настройки по порядку, согласно статье: «Базовые настройки серверов Linux», но установим и настроим, пока что, фаервол UFW.

В Docker установим 2 сервиса: Whoogle и Portainer - как наиболее простые для проведений тестов. К первому проще всего прикрутить NGINX и Fail2ban, а с помощью второго будет легче следить за всеми контейнерами.

Запуск Portainer-а:

$ cd ~

$ mkdir -p portainer-data && cd portainer-data

$ nano docker-compose.yml

version: "3"

volumes:

portainer_data:

services:

portainer:

image: portainer/portainer-ce

container_name: portainer

volumes:

- /var/run/docker.sock:/var/run/docker.sock

- portainer_data:/data

ports:

- 9000:9000

- 8000:8000

restart: always

CTRL + o

CTRL + x

$ sudo docker-compose up -d

Запуск Whoogle:

$ cd ~ $ mkdir whoogle && cd whoogle $ nano docker-compose.yml --- version: '2' services: whoogle: image: benbusby/whoogle-search:latest container_name: whoogle ports: - 5000:5000 restart: unless-stopped CTRL + o CTRL + x $ sudo docker-compose up -d

Без вышеупомянутого совмещения Docker-а и UFW все внутренние сервисы Docker-а будут доступны за пределами вашего сервера.

Проверить последнее утверждение не составит никакого труда. Можно это сделать с помощью браузера, а можно воспользоваться утилитой Curl, которая вернёт нам статусное состояние нашего NGINX.

Т.е. если мы увидим в консоли ответ в виде числа 200 - значит и в браузере мы увидим сайт или сервис виртуальной машины, расположенный по запрашиваемому веб-адресу.

При числах - вроде 1xx или 3xx - скорее всего мы сами запрашиваем неправильно, например веб-адрес.

При числах - 4xx и 5xx - это ошибки в запросе и ошибки сервера.

А вот если у нас будет число 000 - это будет значит сразу 3 вещи:

- Сервис не доступен за фаерволом.

- Настройка фаервола выполнена верно.

- и Docker с фаерволом вполне неплохо ужились на одном сервере.

Команда curl выглядит следующим образом:

curl -s -o /dev/null -w "%{http_code}\n" веб-адрес

Например.

$ curl -s -o /dev/null -w "%{http_code}\n" https://192.168.0.120/

# и

$ curl -s -o /dev/null -w "%{http_code}\n" https://192.168.0.120:9000/

# т.к. запущен сервис и whoogle и portainer

Смотрим на результат.

Без указанного совмещения всё печально. Все сервисы, какие бы у вас не были запущены будут доступны за пределами сервера - и базы данных (например, MySQL / MariaDB) и сервисы доступа к последним (например, PHPMyAdmin) и многое другое, что вы не хотели бы выпускать в открытый доступ в интернет.

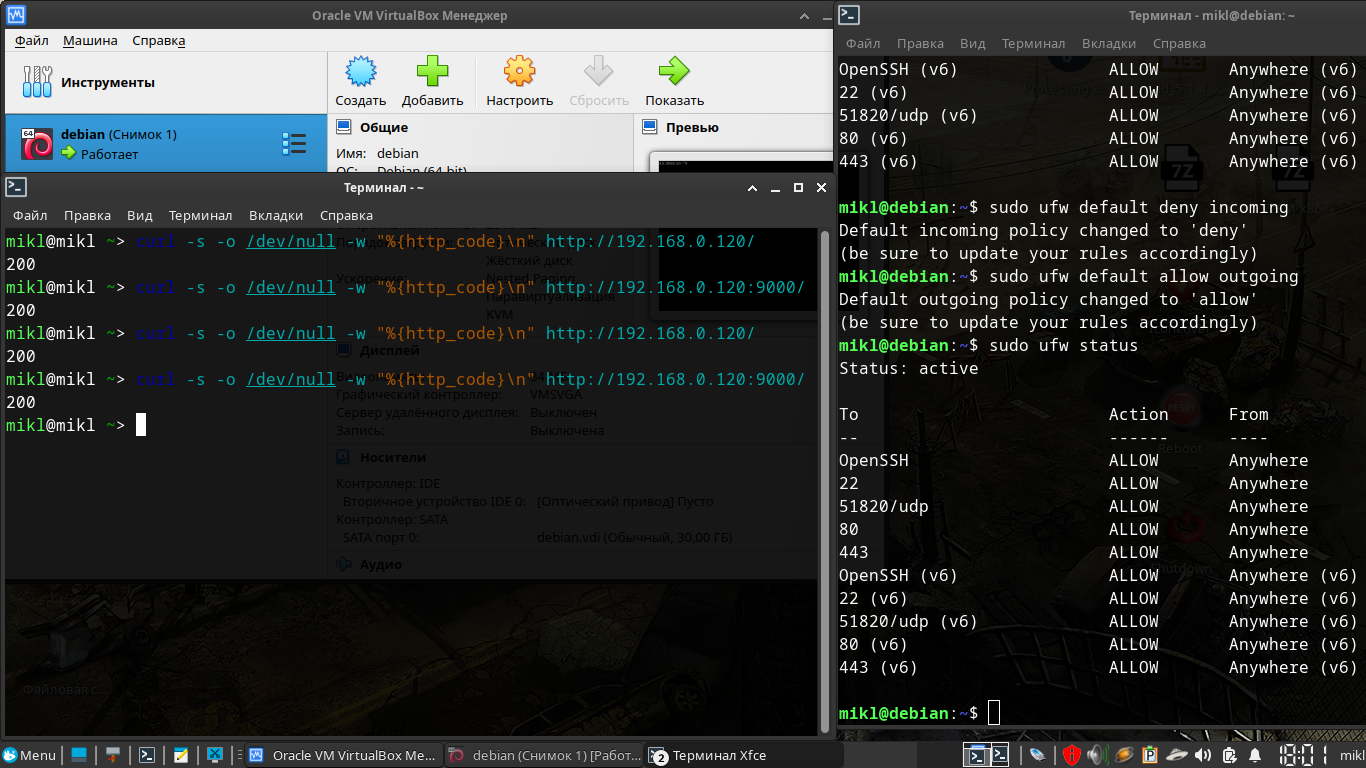

Однако, есть гораздо более продвинутая альтернатива - Firewalld.

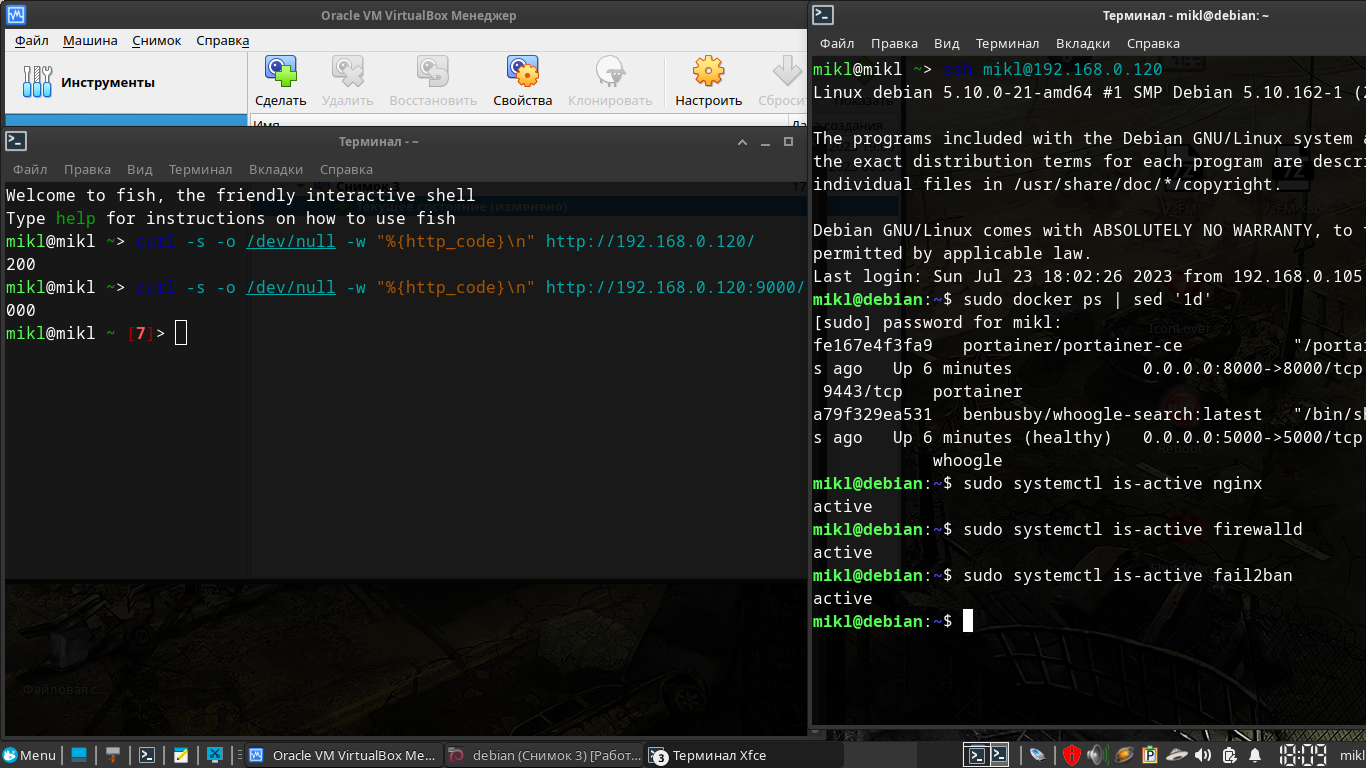

Теперь согласно указанной инструкции настройки серверов, установим и настроим Firewalld, запустим Fail2ban.

Прямой просмотр Systemd может выглядеть достаточно ёмко, т.е. занимать много экранного места. Вместо этого в systemctl существует такая операция, как «is-active». Дословно - «Check whether units are active» переводится как - «Проверка активности устройства».

Т.е. на выходе у нас будет конкретный ответ - запущен ли тот или иной сервис, сокет или таймер или нет.

Также с помощью Curl проверяем доступность запущенных docker сервисов. Я же, согласно инструкции, давал доступ только к NGINX портам - 80 и 443. 51820 в данном случае служит примером настроек wireguard.

ЧУДО СВЕРШИЛОСЬ, причём без танцев с бубном! Шутка. Но в каждой шутке...

Внутренние сервисы, к которым вы явно не давали доступа теперь не доступны за пределами самого сервера.

Это не может не радовать.

При этом лишний раз лазить в IP(6)TABLES / NFTABLES не придётся.

На самом деле дело в том, что в Firewalld имеется несколько сетей по умолчанию - внутренняя, внешняя (публичная) и другие. Это непосредственно связано с принципом работы самого фаервола как такового. Все сети разделяются разными правами доступа, разными политиками обработки пакетов, разными приоритетами и т.д. и т.п. Т.е. для любого сервиса можно настроить своё собственное поведение. Таким образом, для каждого сервиса будут разные базовые правила брендмауера, которые вы сами настроили. В итоге Docker просто перестаёт конфликтовать с фаерволом. Только если явно не указать другие настройки.

Правда появляется другой недостаток - не возможно запустить или остановить какой-либо Docker-контейнер. Для этого просто остановите сервис фаервола. Этого будет вполне достаточно.

$ sudo systemctl stop firewalld.service

Если вы настраивали фаервол по моей инструкции и создавали таймер запуска, то сначала придётся остановить этот таймер и затем уже сервис. Поработали с контейнерами - что-то остановили, что-то запустили, после этого вновь запустите только один сервис фаервола. Если у вас есть связанный с фаерволом Fail2ban, то и его и таймер, и сервис тоже надо будет остановить, а после всех работ запустить хотя бы сервис. После этого не забудьте проверить новые сети Docker-контейнеров и обязательно добавить их во внутреннюю зону internal фаервола с сохранением параметров при перезагрузке.

$ sudo systemctl stop firewalld.timer

$ sudo systemctl stop firewalld.service

$ sudo systemctl start firewalld.timer

$ sudo systemctl start firewalld.service

Перейти к оглавлению. Перейти к главе.

5. Fail2ban

Содержание главы.

Fail2Ban – программа для защиты серверов от атак методом грубой силы. Написанная на языке Python, может работать на POSIX-системах имеющих встроенный менеджер пакетов и брандмауэр. Например, IPTABLES или NFTABLES. Также работает и с Firewalld.

Описывая Fail2ban в двух словах, можно сказать, что он позволяет на основе анализа логов блокировать тех, кто злоупотребляет доступностью сервера по сети. Например, защитить почтовые ящики от взлома путем перебора паролей или многократного запроса какого-либо ресурса.

Fail2Ban считывает логи (например, /var/log/apache2/error.log) и блокирует IP-адреса, активность которых является подозрительной (например, большое количество попыток войти с неправильно введенным паролем, выполнение опасных или бессмысленных действий и т.д.). В случае обнаружения подобных действий программа обновляет правила брандмауэра для блокировки такого IP-адреса на определенный промежуток времени. Программа может быть настроена и для выполнения любых других действий (например, отправки электронного письма).

Конфигурация программы по умолчанию содержит фильтры для Apache, Lighttpd, sshd, vsftpd, qmail, Postfix, Courier Mail Server, Asterisk и других популярных серверных приложений. В фильтрах используются регулярные выражения, которые могут быть легко изменены и настроены в случае необходимости.

Говоря о слабых сторонах Fail2Ban, вы должны знать, что он не очень хорошо работает против распределенных атак методом перебора. Причина в том, что мониторинг лог-файлов происходит примерно раз в секунду. Этого должно быть достаточно в большинстве случаев, однако можно получить больше отказов входа, чем указано в параметре “maxretry”.

Таким образом мы понимаем, что во первых файловый дескриптор какого-либо лога будет практически постоянно открыт и на чтение и на запись. Поэтому обратиться к файлу того или иного журнала с помощью стороннего скрипта может оказаться проблематично. Да и во вторых эффективность у Fail2ban-а, мне кажется, будет несколько выше, чем у сторонних скриптов и утилит.

На самом деле, прописать регулярные выражения для собственных фильтров (если таковые понадобятся) не так уж и сложно, как кажется на первый взгляд. А уж тем более создать свои собственные экшены действий при обнаружении нежелательной активности.

Таким образом необходимость в сторонних скриптах и утилитах анализа практически полностью отпадает.

Нужны будут только скрипты или утилиты для работы с самими пойманными ip-адресами для того, чтобы прописать их в экшенах Fail2ban-а. Т.е. что делать с этими адресами вы решаете самостоятельно - блокировать навсегда или сделать что-то другое.

Или же вы вполне можете прописать в экшенах отправку уведомлений по электронной почте или даже по СМС. Вообщем, на что хватит фантазии ...

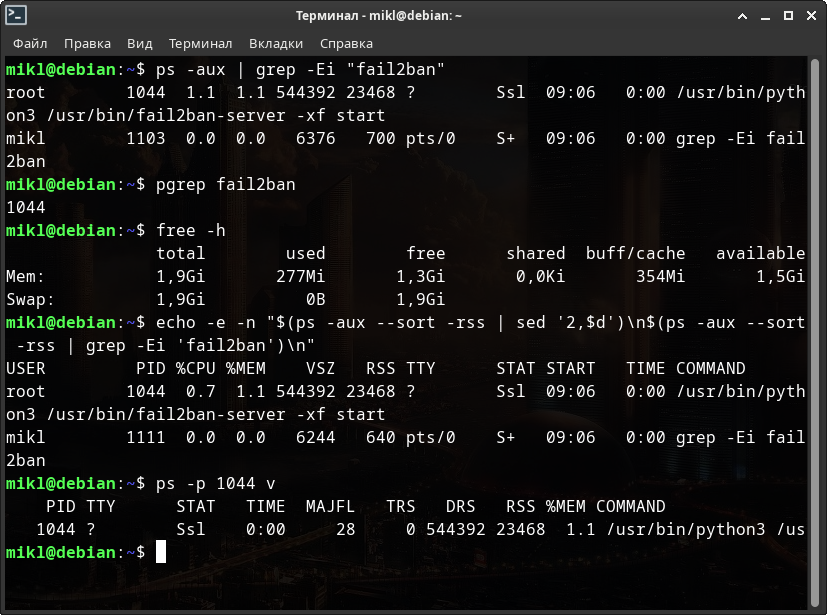

У Fail2Ban довольно низкие системные требования. При конфигурации только с sshd и несколькими различными правилами, Fail2Ban требует около 500 Мб памяти и загружает 1 ядро CPU в среднем менее чем на 0,2%.

Перейти к оглавлению. Перейти к главе.

5.1. Оперативная память.

Прежде чем обращаться к параметрам оперативной памяти процессов в Linux системах необходимо разобраться в нескольких понятиях, без которых вы можете не только запутаться в значениях, но и неверно их истолковать. В результате у вас будут ложные сведения не совпадающие с реальностью.

Физическая память остается после отключения питания. Оперативная память после отключения питания обнуляется.

К физической памяти можно отнести и жесткие диски (ЖД), в том числе, и твердотельные, встроенные к компьютер и внешние, а так же "флешки", забываемые ныне дискеты и пр.

Оперативная память - планки оперативной памяти (хранят информацию только при работе компьютера).

С виртуальной памятью можно легко соприкоснуться в случае, если операционной системе не хватает оперативной. В этом случае нехватка располагается на жестком или твердотельном диске.

Виртуальная память - это область выделенная Операционной системой на жестком диске!

Виртуальная память - временное хранилище, используемое компьютером для выполнения программ, превышающих размер доступной оперативной памяти. Например, программы могут использовать до 4 Гбайт виртуальной памяти на жестком диске, в то время как оперативная память компьютера составляет всего 32 Мбайт. Данные программы, для которых нет свободного места в оперативной памяти, сохраняются в файлах подкачки.

Файл подкачки - Скрытый файл на жестком диске, используемый для хранения частей программ и файлов данных, не помещающихся в оперативной памяти. Файл подкачки и физическая память составляют виртуальную память. По мере необходимости операционная система перемещает данные из файла подкачки в оперативную память (для их использования программами) и обратно (для освобождения места для новых данных).

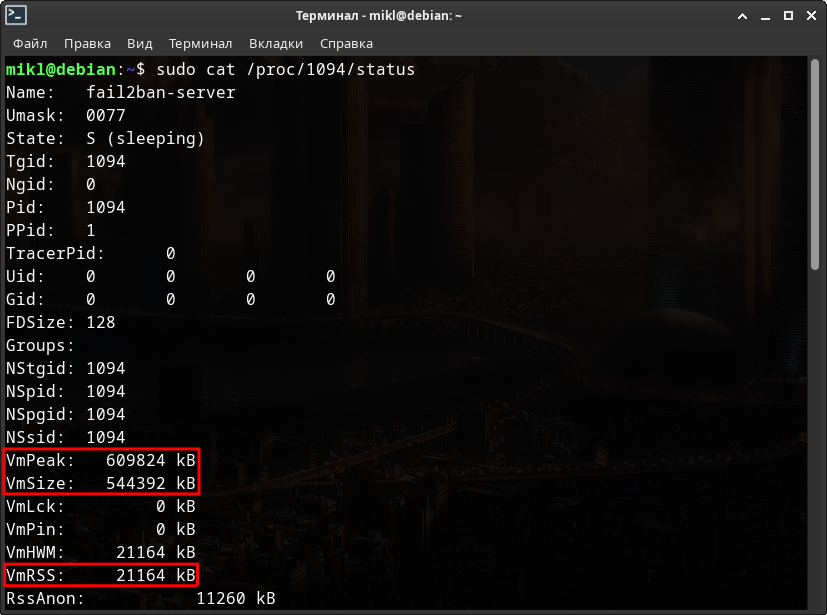

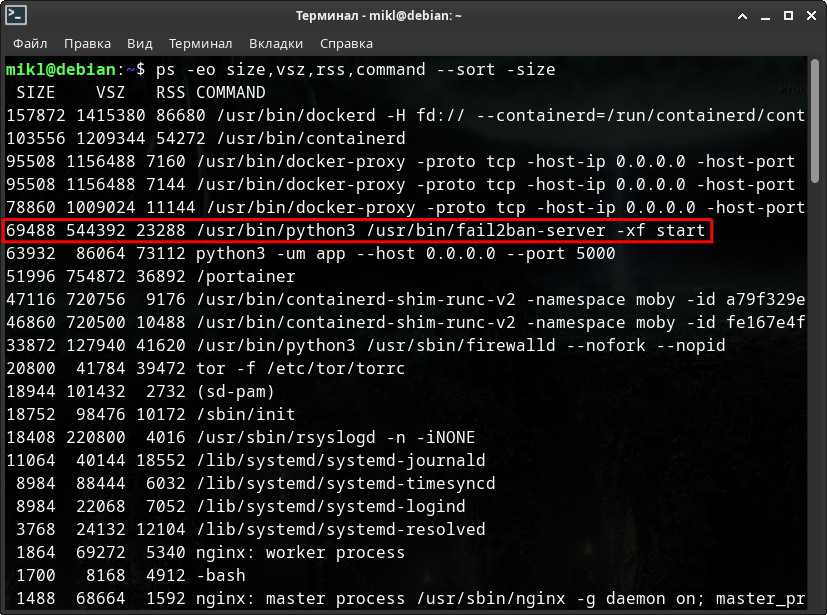

Посмотрим сколько реально памяти занимает Fail2ban - физической, виртуальной, оперативной. Для начала посмотрим на физическую и фиртуальную.

$ ps -aux | grep -Ei "fail2ban" $ pgrep fail2ban $ free -h $ echo -e -n "$(ps -aux --sort -rss | sed '2,$d')\n$(ps -aux --sort -rss | grep -Ei 'fail2ban')\n" $ ps -p 1044 v

Ещё немного физической и виртуальной памяти, но уже с помощью прямого доступа к информации о процессе.

А теперь посмотрим на все эти данные вместе и разберёмся что происходит на всех скриншотах работы виртуальной машины.

Итак, на скриншотах имеются следующие переменные:

- USER - Пользователь, от имени которого работает процесс.

- PID - Идентификатор процесса.

- RSS, VmRSS - Неподкачиваемая физическая память, используемая процессом.

- VSZ, VmSize, VmPeak - Виртуальная память, используемая процессом - 2 текущих, т.е. в данный момент и пиковая, т.е. максимальная.

- SIZE, %MEM - Оперативная память - в килобайтах и процентах соответственно.

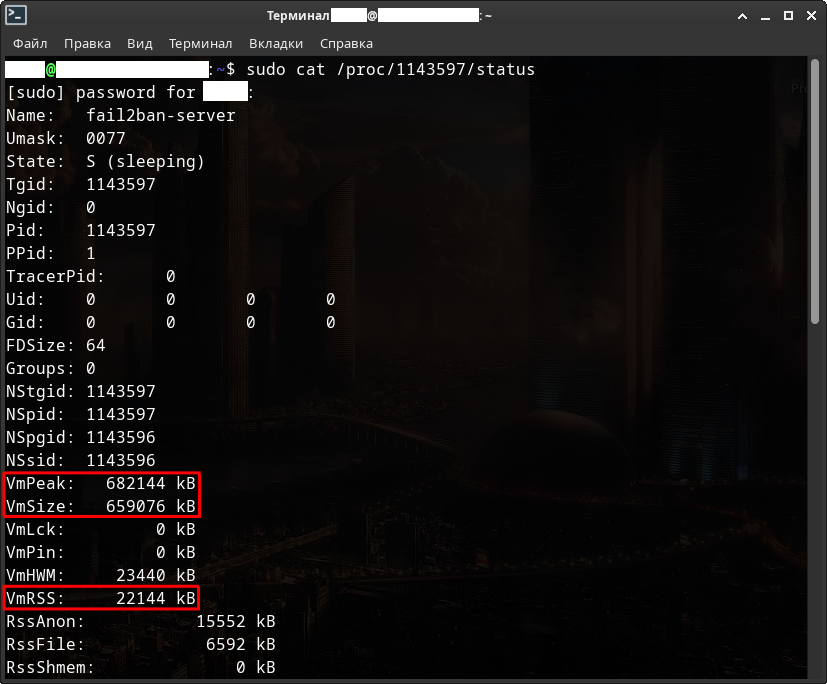

Как вы можете видеть - те самые 500 с лишним Мб - это виртуальной памяти. Реально же в оперативной всего 70 Мб. Соответственно физической памяти всего 24 Мб.

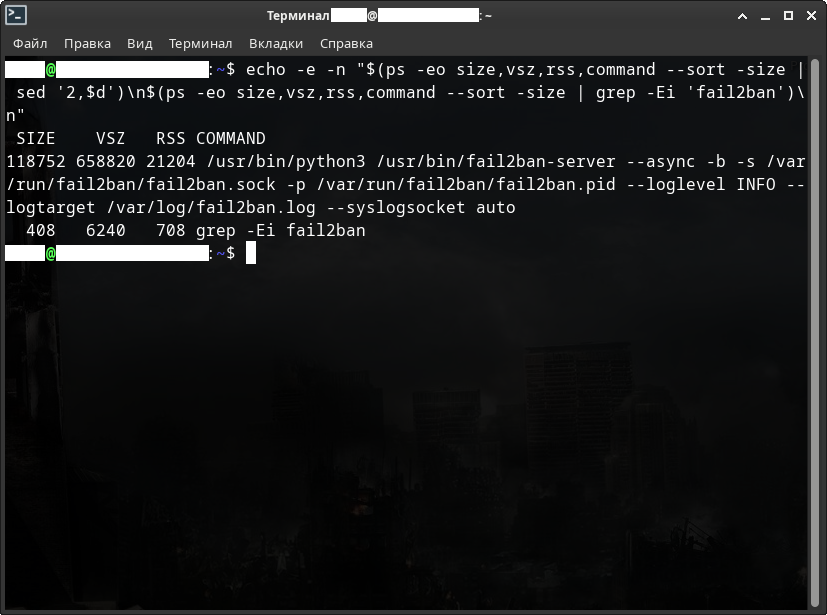

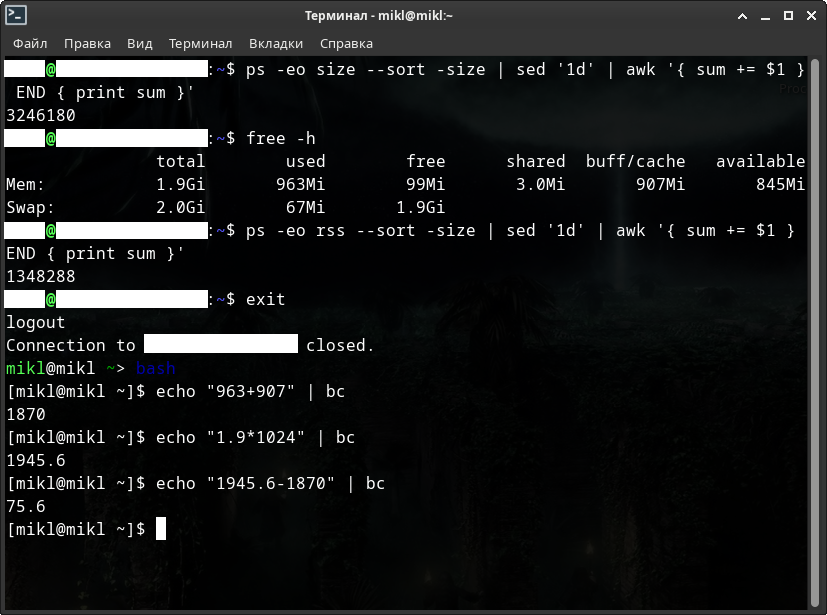

А теперь немного данных с реального VPS сервера.

Проведём небольшое расследование оперативной и физической памяти. Посмотрим дурят нас или нет.

Сначало необходимо узнать, а сколько у нас вообще имеется оперативной памяти и подкачки?

$ free -h

После этого посмотрим сумму оперативной памяти всех процессов, затем также сумму физической памяти всех процессов. Смотреть на сумму виртуальной памяти бессмыслено - она будет занимать по меньшей мере около 10 Гб, а то и в разы больше.

$ ps -eo size --sort -size | sed '1d' | awk '{ sum += $1 } END { print sum }'

$ ps -eo rss --sort -size | sed '1d' | awk '{ sum += $1 } END { print sum }'

$ ps -eo vsz --sort -size | sed '1d' | awk '{ sum += $1 } END { print sum }'

Подведём итоги - общий объём оперативной памяти минус (сумма используемой памяти и кешируемой) должна примерно равняться свободной оперативной памяти.

Если это так - то всё нормально! Если нет - у нас, возможно, утечка памяти и тогда - проблему необходимо решать! +/- 20...30 Мб обычное дело.

Перейти к оглавлению. Перейти к главе.

6. NGINX / Nginx Proxy Manager.

Nginx (NGINX, Engine-X, «Энджин-икс») — это веб-сервер, прокси-сервер, обратный прокси-сервер, smtp-сервер и балансировщик нагрузки с открытым кодом.

Nginx обслуживает более миллиона сайтов по всему миру и пользуется заслуженной любовью и почитанием. Однако несмотря на его популярность и большое количество материалов, вопросов по его использованию не убавляется.

Веб-сервер — это программа, которая принимает и обрабатывает запросы от клиентов по протоколам HTTP и HTTPS и возвращает им ответ в виде HTML-страницы.

Прокси-сервер принимает и обрабатывает запросы клиентов, а затем передает их дальше, другим программам.

Обратный прокси-сервер — принимает результат работы других серверов и отдаёт его клиентам.

Smtp-сервер — это сервер почтовой службы.

Балансировщик нагрузки — программа, которая распределяет сетевые запросы между серверами, следуя настройкам балансировки.

NGINX сочетает в себе все перечисленные возможности, хотя изначально он задумывался только как «web-» и «smtp-сервер».

Сегодня в век технологий давно существует система управления обратным прокси - «Nginx Proxy Manager» (NPM), работающая на Docker. NPM основан на сервере Nginx и предоставляет пользователям чистый, эффективный и красивый веб-интерфейс для упрощения управления. Инструмент прост в настройке и не требует, чтобы пользователи знали, как работать с серверами Nginx или сертификатами SSL.

NPM по сравнению с NGINX просто песня, если не сказка. Всё бы ничего, но есть и целая тарелка дёгтя в этой бочке мёда. А вот какая - вы сейчас узнаете.

Обратите также внимание, что речь идёт об Nginx Proxy Manager версий 3.8 и ниже. Возможно в новых версиях что-нибудь измениться и недостатки обернут в положительные качества.

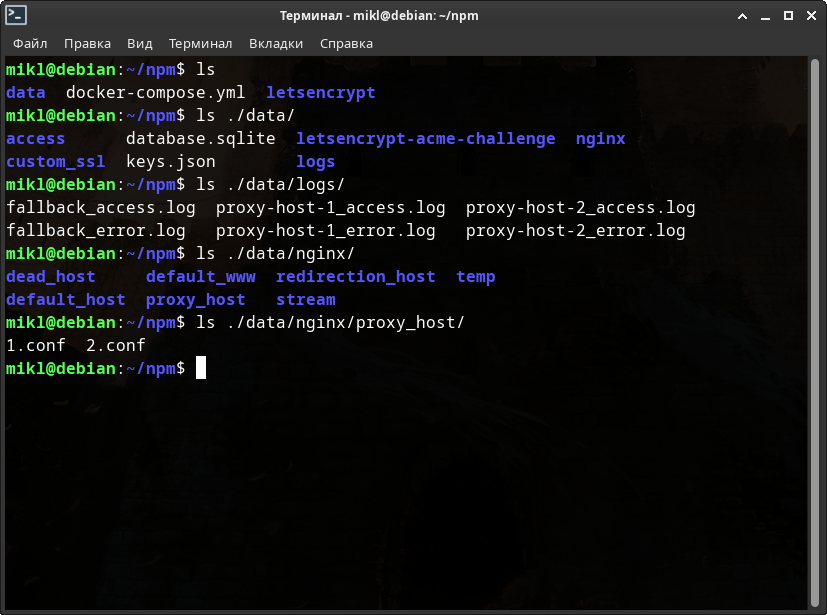

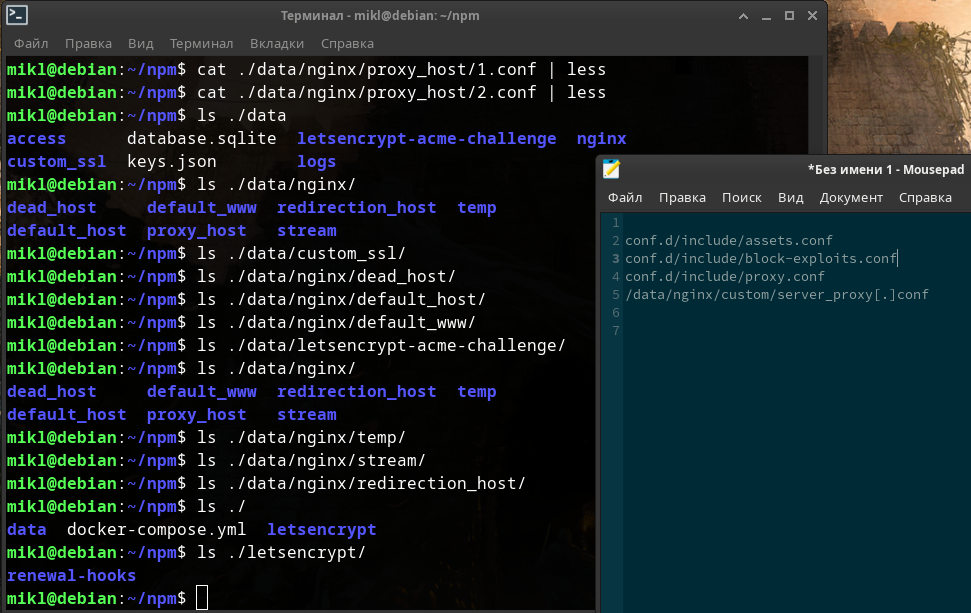

Для начала давайте посмотрим на 2 скриншота, в которых запущен docker-контейнер с «Nginx Proxy Manager» и парой папок с настройками менеджера. Эти папки примонтированы внутрь контейнера с менеджером. Поначалу этих папок не существовало, поэтому docker-compose автоматически их создал и поместил в них настройки из образа менеджера, который docker скачал с официального реестра образов - Docker Hub.

Файл «docker-compose.yml» Nginx Proxy Manager-а.

version: '3.8'

services:

app:

image: 'jc21/nginx-proxy-manager:latest'

restart: unless-stopped

ports:

- '80:80'

- '81:81'

- '443:443'

volumes:

- ./data:/data

- ./letsencrypt:/etc/letsencrypt

После запуска я специально заранее ввел в качестве прокси к определённым локальным ip-адресам пару фейковых доменов с определёнными портами. Попробуем найти созданные конфигурации, а также созданные файлы-логов в папках, которые примонтированы внутрь этого Docker-контейнера: «./data» и «./letsencrypt».

Подведём итог проведённого небольшого расследования:

- Количество файлов журналов на порядок увеличивается.

- В менеджере поддерживается защита от эксплоитов, DDOS атак и HSTS. Но, к сожалению, вы, скорее всего, не знаете что это за настройки и на что они влияют. При настройке определенных веб-ресурсов (веб-сайтов, веб-сервисов) это важно знать! Искать файлы этих настроек внутри Docker-контейнера Nginx Proxy Manager-а не очень то и хочется, только для того, чтобы разобраться что это за настройки. К тому же я не уверен, что при различных обновлениях менеджера эти настройки не изменятся к худшему или лучшему, будут ли меняться от домена к домену или остануться статичными.

- Читать файлы журналов в папках, которые примонтированы внутрь какого-либо Docker-контейнера не самая лучшая идея. Могут возникнуть различные проблемы с правами доступа. Некоторые из этих проблем бывает сложно обнаружить, хотя, чаще всего, просто исправить. Это всё чревато либо отсутствием данных, либо их неполноценностью. В любом случае обнаружить то, что утилиты не видят данные или не могут ничего прочитать внутри настроенных вами файлов логов бывает сложно.

- В Nginx Proxy Manager-е есть только стандартные настройки безопасности. В NGINX же их море поколено. Если вам вдруг понадобится, чтобы SSL какого-либо домена был на 100%, то с NPM такого точно не будет. При добавлении того или иного домена в NPM на последней вкладке настроек можно добавить любые настройки вручную текстом. Вот только какие это настройки? Да и настраивать придётся каждый введёный прокси отдельно.

- При необходимости создать простейшую файлопомойку в Nginx Proxy Manager у вас ничего не получится. Такая функция в менеджере просто не поддерживается. Вам всё равно придётся создавать отдельный контейнер с NGINX или Apache на неком порту (или запускать их непосредственно в системе), и уже затем проксировать к сервису доступ через Nginx Proxy Manager. Самое забавное в том, что не понятно где лучше прописывать ручные настройки безопасности и SSL - в созданном отдельном контейнере для файлопомойки или в самом Nginx Proxy Manager-е на последней вкладке во время добавления прокси хоста. В каком месте настройки будут работать, а в каком нет?

Ещё одна проблема состоит в том, что с большим количеством файлов журналов может не только возникнуть путаница, но и на порядок возрастёт потребляемая оперативная память в Fail2ban-е. Насчёт нагрузки на процессор я не уверен.

Прибавьте к описанным проблемам неизвестные параметры для SSL сертификатов, которые хотелось бы контролировать.

У Nginx Proxy Manager-а есть ещё много других недостатков. Остановимся на описанных.

Говоря о настройках безопасности, имеются введу следующие:

- NGINX DDoS (req limit).

- NGINX настройка файлов.

- NGINX настройка сжатия GZIP.

- NGINX X-XSS-Protection.

- NGINX X-Frame-Options.

- NGINX X-Permitted-Cross-Domain-Policies.

- NGINX Strict-Transport-Security.

- NGINX X-Content-Type-Options.

- NGINX настройки SSL.

- Nginx Отключение серверных токенов.

- Nginx Задание размеров буферов.

И многие другие параметры. Это базовые, одни из наиболее важных, на мой взгляд, правил.

Мне кажется, что такой менеджер подойдёт только новичкам, которые толком ничего не знают об NGINX. Хотя, по мне, так лучше сразу начать его изучать.

К тому же, если у вас на сервере предполагается иметь некие конфедициальные или личные данные я бы сразу начал настраивать только NGINX.

Объяснение всех описанных выше настроек безопасности для NGINX можете посмотреть в статье: «Безопасность сетевых соединений: 5. Fail2ban».

Пример готовых настроек безопасности можно посмотреть в статье: «Базовые настройки серверов Linux: 16. Nginx Reverse Proxy.».

Если всё таки решите устанавливать NPM в Docker-контейнер вместо NGINX, но вместе с Fail2ban-ом, будьте готовы к множеству трудностей, среди которых оперативная память будет занимат далеко не последнее место.

7. Черный и белый списки.

Содержание главы.

- Черный и белый список. Введение.

- Скрипты.

- Версии скриптов.

- Символическая ссылка в «/usr/bin/».

- Работа с логами, командами и выводом информации.

- Работа с черным и белым списками.

- IP(6)TABLES / NFTABLES.

- Работа с таблицами и цепочками.

- Сервисные команды скрипта.

- Systemd.

7.1. Черный и белый список. Ведение.

Представьте себя на минутку почтальоном, который разносит квитанции на оплату ЖКХ или газа по квартирам вашего района и получаете за это повышенную зарплату, т.к. вручаете эти квитанции в руки, а не суете в почтовые ящики. Из тысячи квартир в пяти квартирах живут агрессивные алкоголики, которые регулярно нападают на почтальонов. Пару раз вы порядочно получаете по голове и начинаете обходить эти квартиры стороной.

Этой информацией вы делитесь со своими коллегами почтальонами, а также с другими службами, в чьи задачи входит обход квартир. Например, если специалисты, отвечающие за проверку счетчиков, пойдут по квартирам без вашего черного списка, то наверняка надолго запомнят встречу с этими алкоголиками. А если они воспользуются вашим черным списком, то обойдут стороной все "опасные" квартиры.

Аналогичная ситуация и с IP-адресами: есть компании, которые отслеживают IP-адреса, осуществляющие DDoS-атаки, мошеннические действия, рассылающие спам, и добавляют эти адреса в свои черные списки (black list). А затем другие компании, в основном почтовые сервисы, интернет-провайдеры, платежные системы, банки, интернет-магазины, покупают проверку IP-адресов своих посетителей по этим базам.

Черный список IP-адресов - это список IP-адресов для блокировки, которые были идентифицированы как отправляющие спам или выполняющие другие нежелательные действия. Когда IP-адрес добавляется в "черный список", компьютеры, связанные с этим IP-адресом, больше не могут получать доступ к определенным вебсайтам.

Белый список IP-адресов — список доверенных IP-адресов, которым вы разрешаете доступ к приложениям вне зависимости от наличия в запросах признаков атак. Белый список имеет наиболее высокий приоритет среди других списков, поэтому при любом режиме фильтрации фаервола, последний не заблокирует запросы с IP-адресов из белого списка.

Особенно часто страдают пользователи VPN. IP-адреса публичных VPN-сервисов регулярно попадают в черные списки ввиду того, что к услугам VPN-сервисов прибегают и киберпреступники. Если IP-адрес VPN-сервера попал в черный список, то проблемы возникнут у всех пользователей, подключенных к данному серверу VPN.

Вы, естественно, не сможете никак проверить, не совершал ли кто-то ранее какие-либо преступления с полученного вами IP-адреса, а вот проверить наличие IP-адреса в черных списках может каждый.

Это касается и персонального VPN или прокси, так как хостинг может предоставить вам сервер c «грязным» IP-адресом. В этом случае вам необходимо будет обратиться к хостинг-провайдеру и попросить замену.

Помните, что черные списки не статичны и постоянно обновляются. Если вашим IP-адресом пользуется кто-то еще, IP-адрес может оказаться в черном списке в любое время. Сегодня он еще может быть белым и чистым, а завтра оказаться во всех популярных черных списках.

Компаний, составляющих подобные списки, немало, но самая крупная и авторитетная – Spamhaus. Пользователи могут проверять наличие IP-адреса в списках Spamhaus абсолютно.

Помимо Spamhaus, есть много других черных списков IP-адресов, однако они не получили широкого распространения и влияния. Проверить IP-адрес по другим спискам можно на сайте MXtoolbox.

Вернемся к нашим алкоголикам, с которых мы начали разговор. Вы купили одну из квартир алкоголиков по более выгодной стоимости по сравнению с рыночной и въехали в неё. Вскоре вы замечаете, что вам не приходит корреспонденция, и идете на почту узнать, что произошло. Там выясняется, что ваша квартира в черном списке, и вы просите вычеркнуть вас из него. Почтальон говорит: «Хорошо» и вычеркивает – и вы снова получаете почту.

Подобным образом работают и черные списки IP-адресов. Всегда можно удалить адрес из черного списка по обращению к модератору. Однако это не всегда просто, когда речь, например, идет об IP-адресе VPN или прокси. В это случае легче просто поменять IP-адрес.

Если речь идет об IP-адресе, предоставленном интернет-провайдером, то, иногда, для его смены достаточно просто перезагрузить WiFI-роутер. Если это не помогло, обратитесь к вашему интернет-провайдеру с просьбой о смене IP-адреса.

Теперь поговорим о черных и белый списках отдельных серверов.

В данном случае речь идёт не об общедоступных черных списках IP-адресов известных компаний, которые регулярно обновляются, а о локальном списке, в который сервер собирает ip-адреса самостоятельно. Т.е. используя утилиты анализа логов сервер анализирует нежелательную и вредоносную активность и блокирует эти адреса.

Можно провести аналогию с вышеупомянутыми алкоголиками. Допустим в одной из квартир до беспамятства, т.е. крепко, выпивают достаточно редко. Ну, т.е. только по большим праздникам. Вы, как почтальон, разносили письма и в один прекрасный день просто попали под горячую руку. Естественно, с этого момента именно эту квартиру, вы будете обходить стороной. Однако, буквально через пару недель, вы на улице, случайно, сталкиваетесь с этим же человеком лицом к лицу. Самое забавное в том, что человек то трезвый и спрашивает – почему вы не приносите ему корреспонденцию. Естественно вы объясняете ему причину, а мужчина тем временем извиняется и просит вновь приносить ему почту. И вы будете вынуждены вновь приходить к этой квартире.

Таким образом вы, как почтальон, временно обходили нежелательный адрес стороной.

Также и с ip-адресами в утилитах анализа. Они только временно блокируют вредоносную и нежелательную активность. Это время задается в настройках. Для постоянной блокировки необходимо использовать дополнительные программы и скрипты.

При использовании дополнительных программ для постоянной блокировки ip-адреса, которые были временно заблокированы с помощью утилит анализа, сразу будут добавляться и в черный список и затем уже блокироваться постоянно, т.е. навсегда.

Перейти к оглавлению. Перейти к главе.

7.2. Скрипты.

Почему необходимо использовать стороннее ПО для постоянной блокировки?

Дело в том, что если вы не будете проверять наличие ip-адреса в правилах брандмауэра и попытаетесь добавить этот же адрес ещё раз – он будет добавлен ещё раз, т.е. задвоен.

Когда вам понадобится разблокировать адрес – вы будете разблокировать ip-адрес столько раз, сколько добавляли в правила брандмауэра.

Такое поведение явно не приемлемо!

Вот за этим и нужны сторонние скрипты или программы. Они как раз и проверяют наличие того или иного ip-адреса и в локальной базе черного списка и в правилах брандмауэра, чтобы адрес попадал в оба места только единожды.

Причём самое интересное в том, что если вы добавили в правила фаервола ip-адрес с максимальной маской протокола, а затем решили добавить всю подсеть – оба адреса попадут и в эти правила и в базу данных черного списка.

Например, 192.168.0.130/32 и 192.168.0.0/24. Очевидно что первый адрес принадлежит всей подсети второго адреса, но т.к. они разные любые скрипты и утилиты будут считать их разными. Поэтому оба таких адреса будут попадать и в список и в правила блокировки, т.е. в брандмауэр.

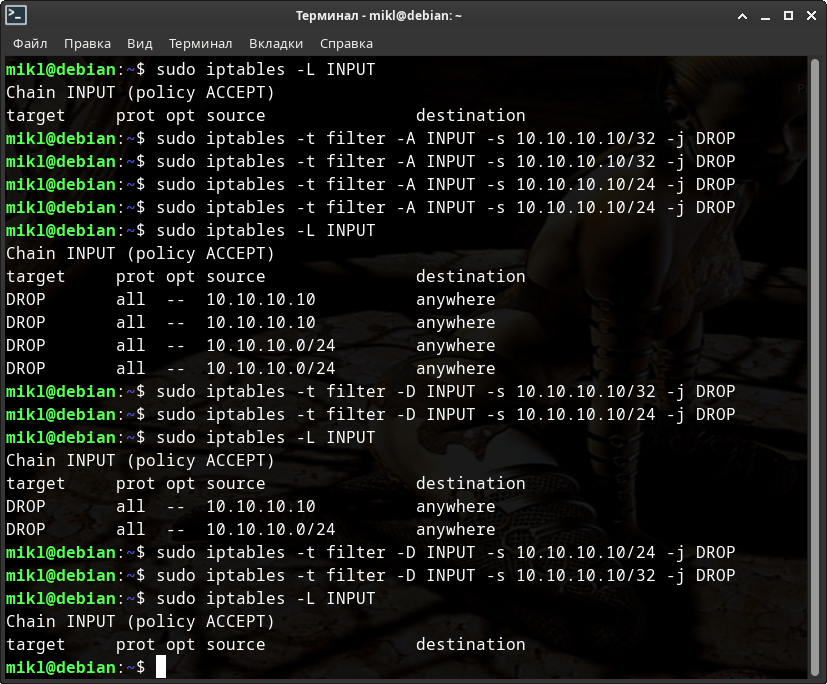

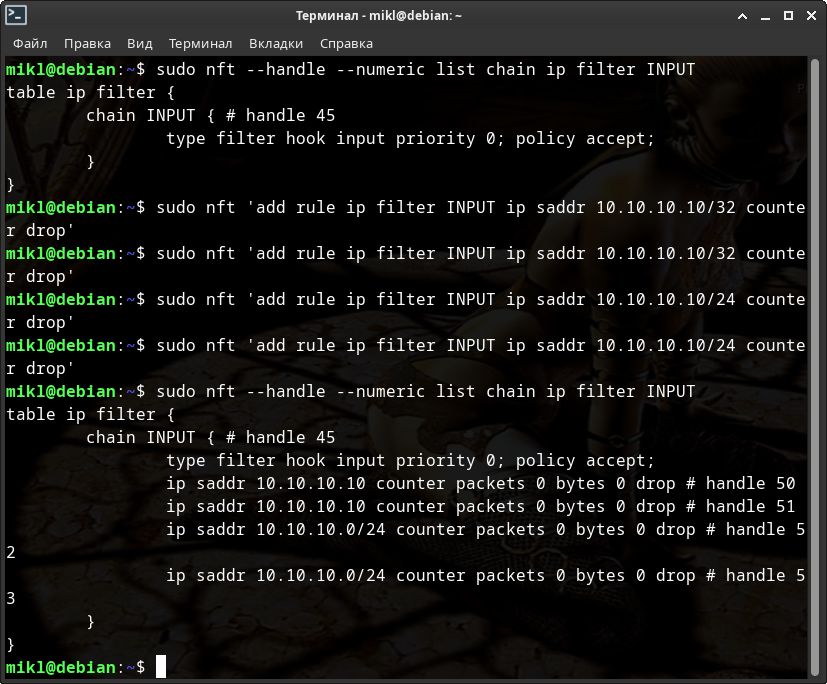

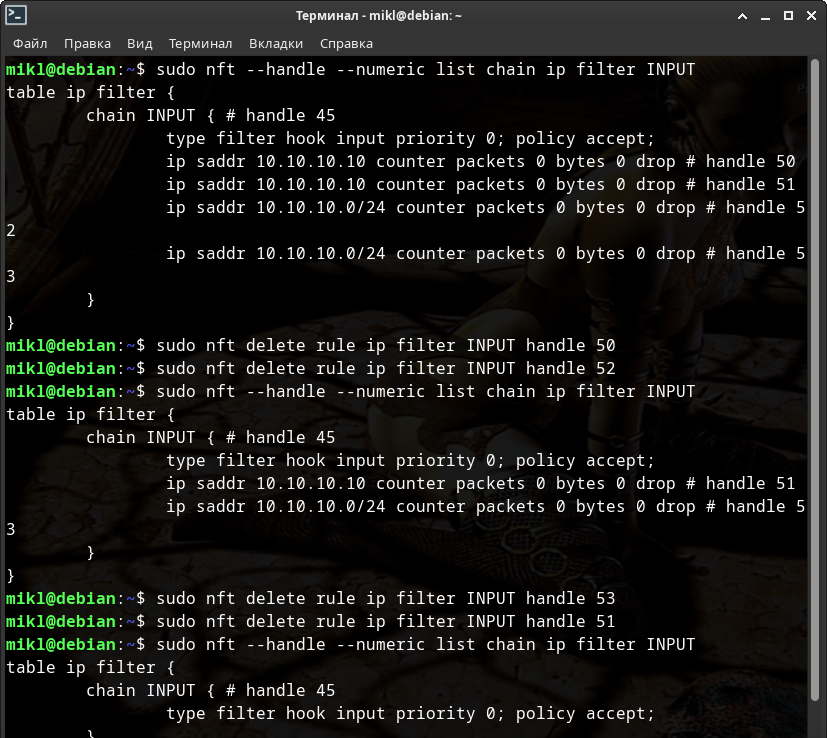

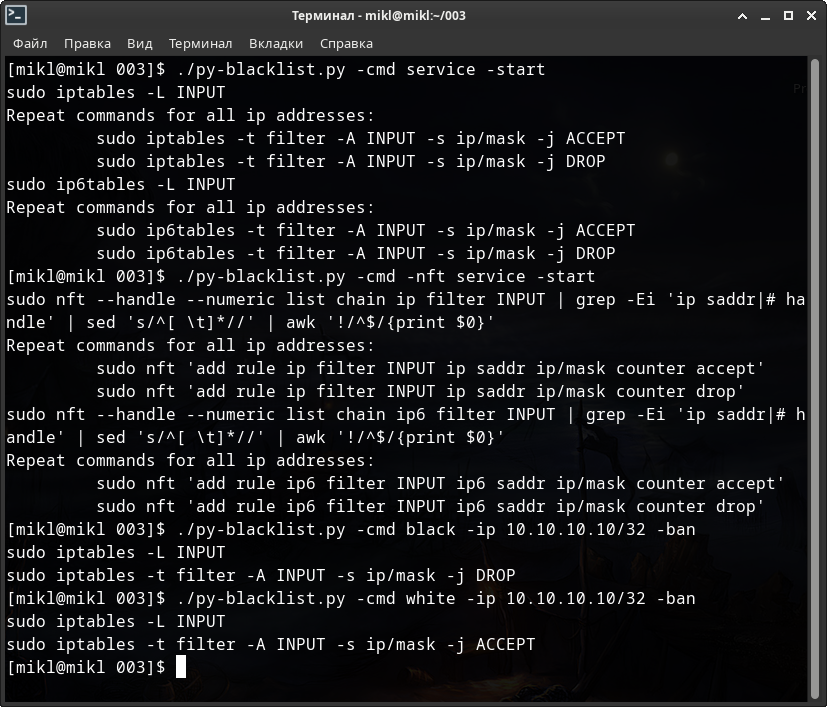

Давайте рассмотрим несколько примеров вышеупомянутого поведения и в IPTABLES и в NFTABLES.

Попробуем дважды добавить ip-адреса «10.10.10.10/32» и «10.10.10.10/24» в IPATBLES. И так же попробуем дважды их удалить оттуда.

Самое неприятное в том, что IPTABLES после добавления второго такого же ip-адреса сети начал жёстко лагать и подвисать!

Проделаем тоже самое для NFTABLES.

Как видите - также удалось!

При этом каких-либо подвисаний NFTABLES замечено не было.

Yandex и Google в ответ на попытку отыскать программу или утилиту для работы с черным списком ip-адресов для Linux предлагают либо способы блокировки через IPTABLES, либо создавать такой скрипт самостоятельно.

Ну а найденные утилиты или скрипты, мягко говоря, либо не оправдывают ожиданий, либо работают не совсем корректно, либо изготовлены только для XTables. А хотелось бы, чтобы они всё-таки работали с nf_tables.

Спешу вас обрадовать - такой скрипт уже существует и написан он вашим покорным слугой на языке «Python».

Не волнуйтесь! Скрипт многократно тестировался в течении нескольких недель на реальном VPS-сервере с реальными данными различных атак не только BootNet-сетей. Скрипт до сих пор там работает!

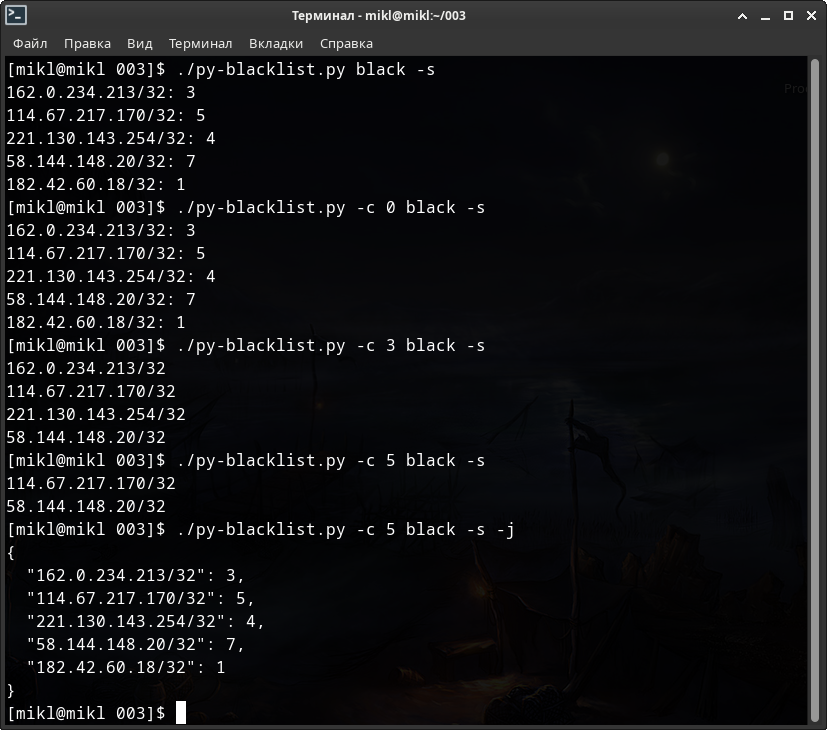

Знакомьтесь со скриптом: «py-blacklist.py». И у него имеется множество различных «Release-версии», большая часть из которых совместимы между собой.

Например, во второй версии 1.0.1 немного оптимизирован вывод логов событий, т.е. я сделал их немного более красивыми и менее громоздкими. Да, изначально они были достаточно объемными и полными. Я их немного сократил, улучшил и сделал более приятными для чтения.

Дело в том, что чем лучше логи программы тем быстрее и легче любому пользователю обнаружить и устранить ошибку или сбой.

В третьей версии 1.0.2 слегка оптизирован способ получения аргументов командной строки и появилась дата модификации программы, а не только её изначальная дата создания. В остальном программа никак не изменилась.

В 4-й версии 1.1.0 произведено уже немного более значительное улучшение - вывод информации об ip-адресах, добавленных в nf_tables, стал более точным и кратким.

В пятой версии 2.0.0 добавлена функциональность отображения не только одних цепочек заданных таблиц nf_tables, но и просмотр самих таблиц.

Таким образом запустив хоть 1-ю, хоть 5-ю версию - разницы в работе с программой особо не будет, потому что исправления касались по большей части не ошибок, а улучшений. Как только обнаружаться какие-либо ошибки или сбои об этом будет указано в 2 местах: в файле «CHANGELOG.txt» и в описании «Release-версии».

В репозитории с утилитой имеется «README.md» файл с описанием программы и обзором её ключей и параметров с РУСИФИКАЦИЕЙ всех меню.

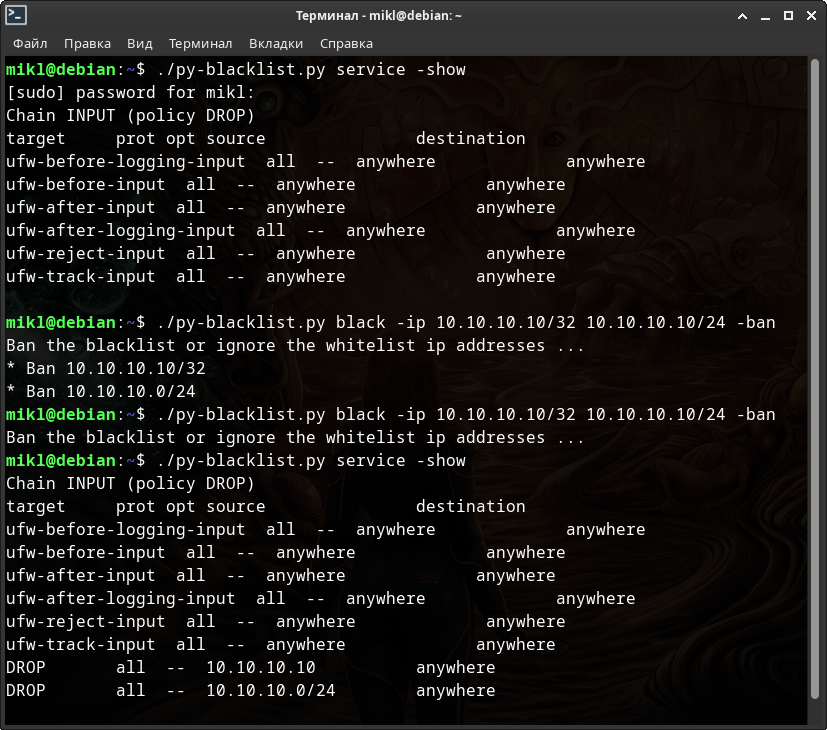

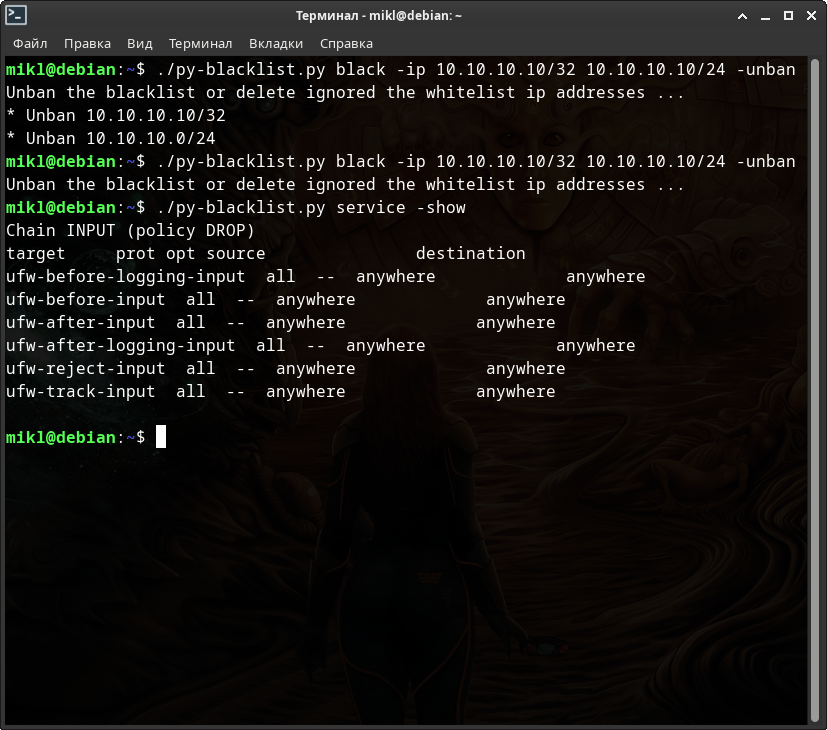

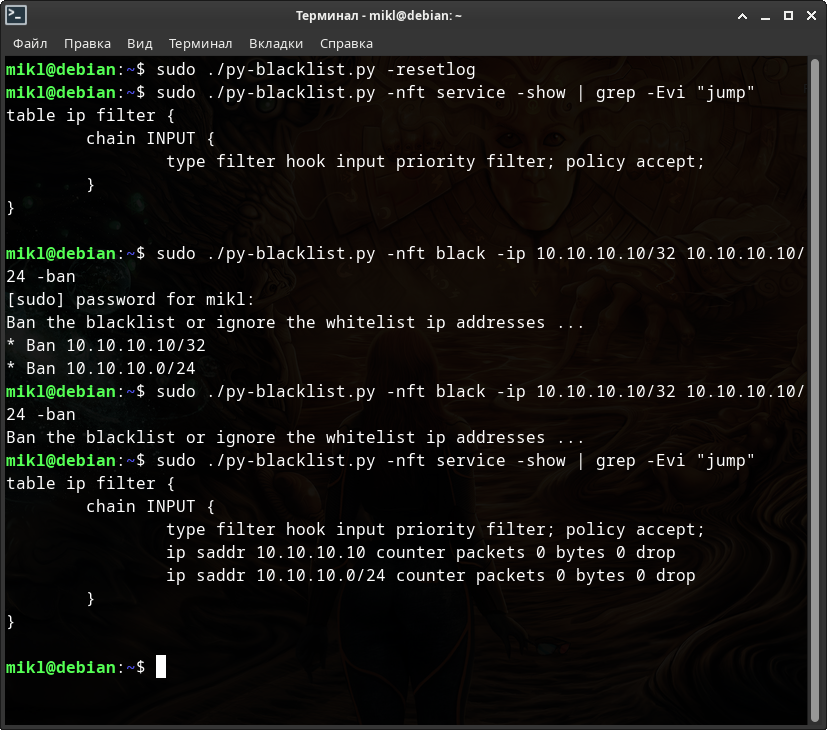

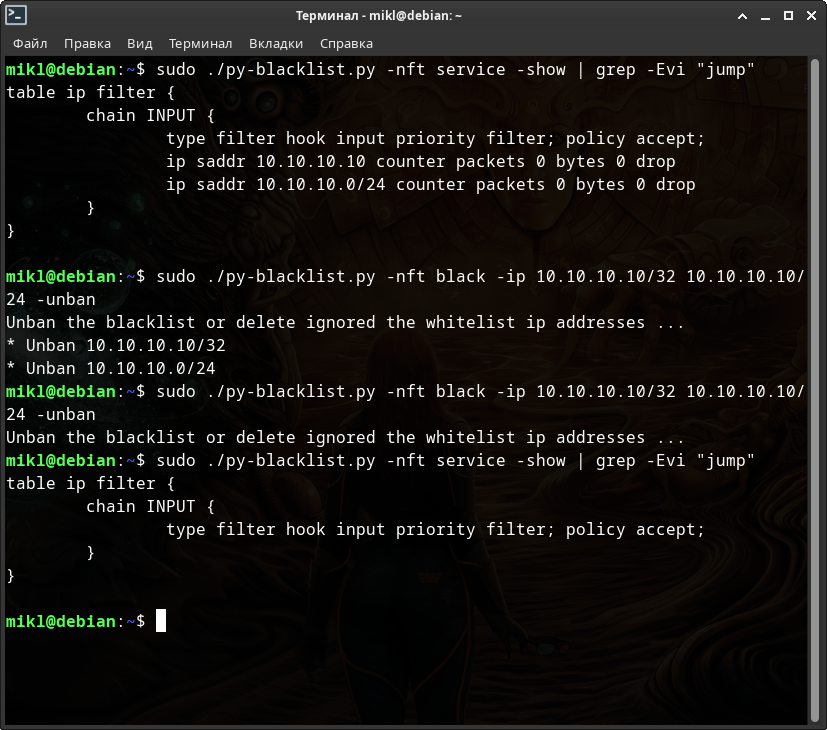

Проведём с моим скриптом тот же самый эксперимент - попробуем дважды добавить ip-адреса «10.10.10.10/32» и «10.10.10.10/24» в IPATBLES. И так же попробуем дважды их удалить оттуда.

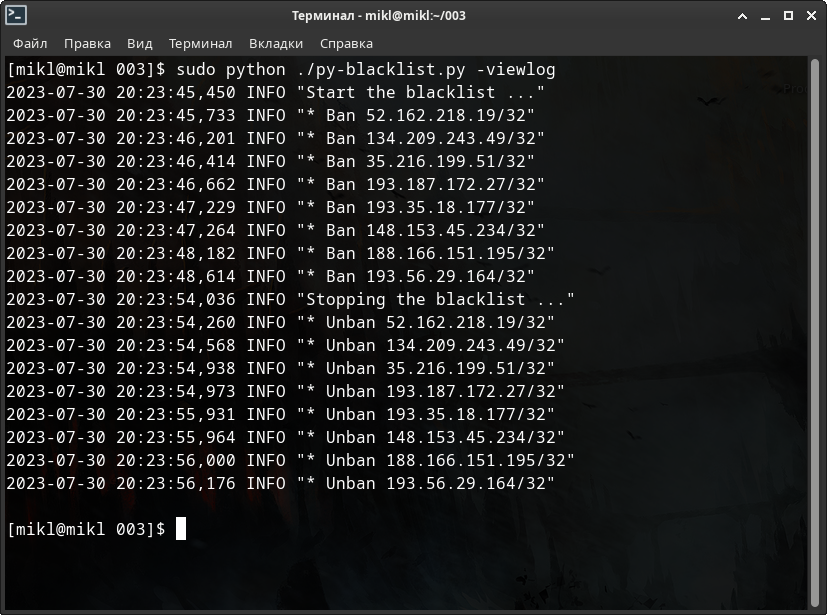

А теперь также дважды проделаем те же самые операции по добавлению и удалению указанных ip-адресов в nf_tables.

Перед работой с nf_tables я сбросил, т.е. обнулил, логи только для того чтобы сократить их вывод для данного примера.

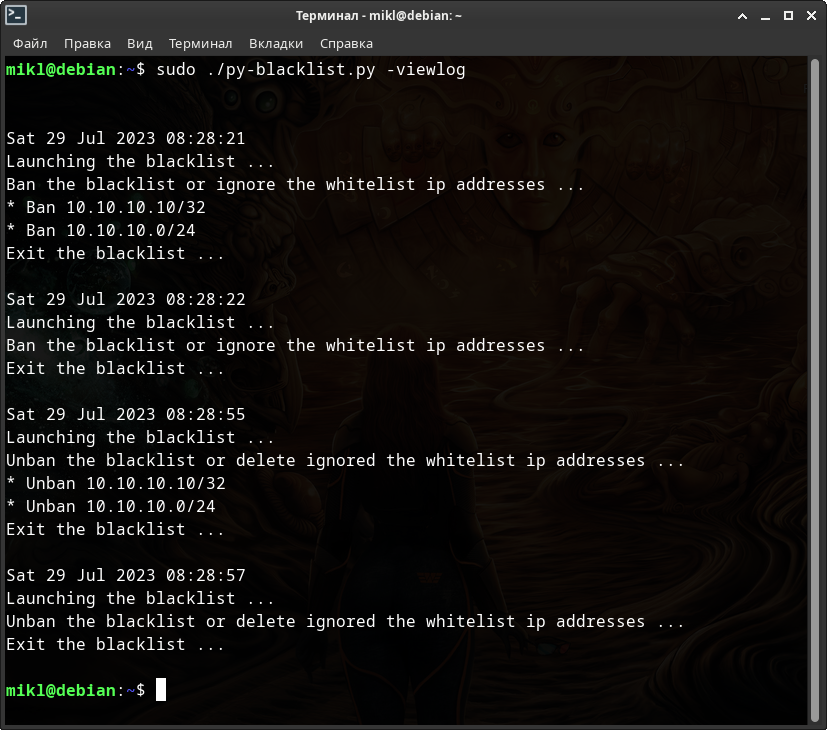

Посмотрим, что у нас в логах событий.

По мне так очень даже неплохой вывод журналов событий - понятно и эффективно. В случае обнаружения проблем - мы бы увидели здесь и саму ошибку и команды, которые вызвали проблемы.

Да, я прекрасно понимаю, что это не совсем правильный способ ведения журнала событий. Этому моменту будет уделено отдельное внимание в главе: 7.5. Работа с логами, командами и выводом информации.

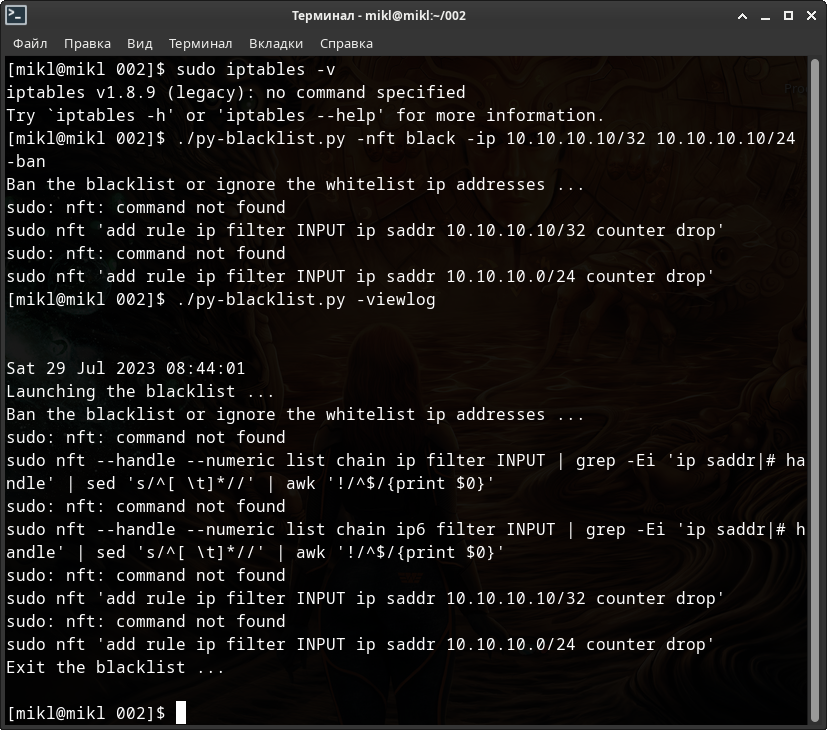

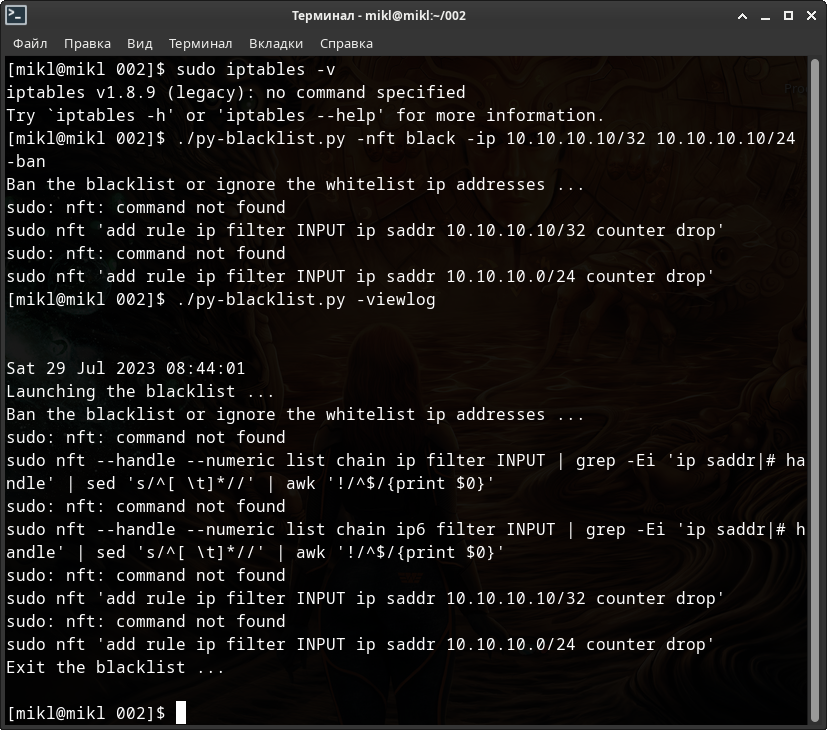

В моём Archlinux-е IPTABLES не поддерживает работу с nf_tables, точнее говоря в ОС нет слоя совместимости для работы с последней. Поэтому для работы с «Netfilter»-ом мне необходимо отдельно установить утилиту «nftables».

На этом можно сыграть. Я специально, с помощью ключей и параметров моего скрипта, запущу заведомо неисправную команду системы по добавлению 2 указанных выше ip-адресов через утилиту «nft» в nf_tables.

Посмотрим на журнал событий - как изменился вывод информации об ошибках?

Как вы можете видеть - и во время добавления была выведена информация об ошибке, и ошибочной команде, и в журнале событий было отображено всё тоже самое + дата событий.

Не очень красиво, зато удобно и понятно.

В любом случае этот скрипт не просто полностью заменяет всю ручную работу с «Безопасностю сетевых соединений: 6. Блокировкой ip-адреса или всей подсети», но и имеет массу других встроеных методов по работе с Netfilter-ом как таковым.

Например, при настройке фаервола Firewalld, если у вас используется Docker или любой другое подобное приложение с контейнерами - обязательно необходимо просматривать списки сетей и вносить новые Docker-сети в настройки фаервола.

Просматривать их стандартными утилитами - «ip» или «ifconfig» не очень удобно, т.к. вывод команды просто огромен, а знать другие способы просмотра наизусть просто невозможно.

По другому только один список доступных сетевых интерфейсов можно посмотреть так:

$ ls /sys/class/net

И тут на сцену выступает мой Python-скрипт. Уже в версии «2.2.0» встроен дополнительный ключ просмотра списка доступных сетевых интерфейсов вот этой самой командой + этот момент указан внутри помощи программы.

Перейти к оглавлению. Перейти к главе.

7.3. Версии скриптов.

Файл «CHANGELOG.txt» - это обязательный стандарт для любой разрабатываемой программы или утилиты. Он представляет из себя простой текстовый файл в который обязательно необходимо записывать изменения, которые были произведены. Причём не обязательно подробно. Здесь конкретно указывается дата изменений, наименование файла, в котором были произведены изменения, версия программы - и далее MarkDown списком описание изменений.

Причём желательно всё писать на английском языке, чтобы не только рускоязычные пользователи имели представление о чём идёт речь.

Обязательно придумать и вставить какой-нибудь разделитель между разными датами изменений.

Например, на момент создания главы этой статьи, в репозитории «blacklist-scripts», в файл «CHANGELOG.txt» была внесена следующая информация:

----- 29.07.2023 - 09:20 GMT +3 py-blacklist 2.0.0: * Added functionality for viewing not only some chains of specified NFTABLES tables, but also the tables themselves completely. ----- 29.07.2023 - 08:10 GMT +3 py-blacklist 1.1.0: * The output of information about ip-addresses added to "nf_tables" has been replaced with a more accurate one. ----- 27.07.2023 - 08:02 GMT +3 py-blacklist 1.0.2: * Optimization of ways to get command-line arguments. * Added the date of creation and date of modification of the program. ----- 26.07.2023 - 08:59 GMT +3 py-blacklist 1.0.1: * Optimization of event log output. ----- 25.07.2023 - 11:52 GMT +3 py-blacklist 1.0.0: Basic stable version. -----

Что такое версия программы и как она строится?

Версия представляет собой существенно изменённую программу или пакет программ, в который добавлены принципиально новые функции, используется иная организация программы, данных или применяются новые способы взаимодействия пользователя с программой. Как правило, новые модификации и версии имеют то же самое название, какое имел и исходный продукт.

Версия состоит из нескольких чисел (как правило, трёх), разделённых точкой: например, 1.5.2.

- Первое из них — таршая версия (major), изменяется при кардинальных изменениях программы,

- второе — младшая версия (minor), изменяется при значительных изменениях функциональности,

- третья — мелкие изменения (maintenance, micro).

Иногда через тире указывают номер выпуска, т.е. номер исправлений конкретных ошибок или сбоев в работе программы. Например, 1.5.1-1 или 1.5.1-3.

При увеличении одного из чисел все идущие после него сбрасываются до нуля: 1.0.0, 1.0.1, 1.0.2, 1.1.0, 1.2.0, 1.2.1, 2.0.0 …

Последний ноль может опускаться: 1.0.0 = 1.0.

Иногда можно встретить и такую нумерацию:

- 0 — альфа

- 1 — бета

- 2 — выпуск-кандидат

- 3 — публичный выпуск

Если вы вдруг видете, что нумерация в версиях ограничено 3-мя или 4-мя значениями каждой цифры - значит в этом случае можно понимать, что это за версия: альфа, бета тестирование или стабильный выпуск. В остальных случаях последний номер может и не значить ни альфу, ни бету.

Можно иногда встретить и то, что третье число может означать несколько другую нумерацию стадий разработки:

- Альфа версия - стадия тестирования приложения, число 0 или символ a.

- Бета версия - стадия публичного тестирования приложения, число 1 или символ b.

- RC (Release candidate) релиз-кандидат - стадия-кандидат на то, чтобы стать стабильной версией, число 2 или символы rc.

- RTM (Release To Manufacturing) релиз - стабильная версия приложения, число 3 или символы rtm.

- GA (General availability) - общедоступный релиз.

В Linux утилитах встречается похожий тип нумерации версий: «{major}.{minor}.{maintenance}-{revision}{development stage}». Причём, ревизия и стадия разработки не всегда в одном и том же порядке. Например: 2.0.5-23, 1.9.95-1rc, 5.0.r11084.a52b8759ff-1 и другие.

Например, Windows 7 на самом деле имеет нумерацию: «Windiows NT 6.1.7600», а Windows 7 Service Pack 1 - «Windows NT 6.1.7601». Windows 10 20H2 - «Windows NT 10.0.19042», а Windows 10 21H2 - «Windows NT 10.0.22000».

Тип нумерации версий утверждают перед первым релизом и обязательно декларируют этот тип в документации к программе, если он хоть немного отличается от привычного порядка.

Порой можно встретить и нумерацию по дате изготовления. Например, версия дистрибутива какого-нибудь Linux-а.

Если вы разрабатываете утилиту для себя, а не для компаний - намного удобнее, на мой взгляд, применять первоначально описанный способ нумерации: «major.minor.maintenance-revision».

Вообще-то, в Python, чаще всего, как раз и применяется именно такая нумерация, включая номер исправлений (ревизий) через тире. Если вам очень необходимо - можете также указывать и стадию разработки (альфа, бета, rc, rtm, ga). Обычно стадия опускается, т.е. не указывается. Разьве что в редких слуаях исключений.

Перейти к оглавлению. Перейти к главе.

7.4. Символическая ссылка в «/usr/bin/».

Символические и жесткие ссылки - это особенность файловой системы Linux, которая позволяет размещать один и тот же файл в нескольких директориях. Это очень похоже на ярлыки в Windows, так как файл на самом деле остается там же где и был, но вы можете на него сослаться из любого другого места.

В Linux существует два типа ссылок на файлы. Это символические и жесткие ссылки Linux.

Символические ссылки более всего похожи на обычные ярлыки. Они содержат адрес нужного файла в вашей файловой системе. Когда вы пытаетесь открыть такую ссылку, то открывается целевой файл или папка.

При удалении целевого файла ссылка останется, но она будет указывать в никуда, поскольку файла на самом деле больше нет.

Жесткая ссылка (hard link) является своего рода синонимом для существующего файла. Когда вы создаете жесткую ссылку, создается дополнительный указатель на существующий файл, но не копия файла. Жесткие ссылки выглядят в файловой структуре как еще один файл. Если вы создаете жесткую ссылку в том же каталоге, где находится целевой файл, то они должны иметь разные имена. Жесткая ссылка на файл должна находится в той же файловой системе, где и другие жесткие ссылки на этот файл.

В Linux каждый файл имеет уникальный идентификатор - индексный дескриптор (inode). Это число, которое однозначно идентифицирует файл в файловой системе. Жесткая ссылка и файл, для которой она создавалась имеют одинаковые inode. Поэтому жесткая ссылка имеет те же права доступа, владельца и время последней модификации, что и целевой файл. Различаются только имена файлов. Фактически жесткая ссылка это еще одно имя для файла.

Жесткие ссылки нельзя создавать для директорий! Жесткая ссылка не может указывать на несуществующий файл!

Нас же интересуют только символьные ссылки.

«/usr/bin/» - Содержит исполняемые файлы различных программ, которые не нужны на первых этапах загрузки системы, например, музыкальные плееры, графические редакторы, браузеры и так далее.

Обычно для запуска программ и утилит из любого места системы именно в этой папке располагают символьные ссылки. Естественно, они могут ссылаться почти в любое место в системе. Главный критерий - чтобы файлы, на который они ссылаются, были исполняемыми. Т.е. имели флаг исполнения (выполнения).