Базовые настройки серверов Linux

Хорош тот сервер, который настроен тщательно и с умом.

Введение.

Сервер Linux - это эффективный, мощный вариант операционной системы Linux с открытым исходным кодом (ОС). Серверы Linux созданы для удовлетворения постоянно растущих требований бизнес-приложений, таких как системное и сетевое администрирование, веб-службы и управление базами данных.

Многие так привыкли к Windows, что даже слышать про Linux не хотят, я имею в виду даже пользовательские варианты Linux с красивыми и удобными рабочими столами. И на вопрос, почему Вы не хотите использовать Linux? Все отвечают: «да он какой-то корявый!», «Программы, которые я использую в Windows не устанавливаются на Linux» и так далее. Но на самом деле всем пользователям, которые так категоричны к Linux, я хочу сказать, что Linux очень дружелюбная операционная система, и стоит всего лишь немного разобраться в ней и Вам все станет понятно.

Теперь я хочу перечислить некоторые преимущества Linux перед Windows, а также развеять некоторые мифы:

- Linux – абсолютно бесплатная операционная система (за исключением некоторых платных дистрибутивов), в отличие от Windows.

- В Linux практически отсутствуют вирусы. Они есть, но это скорее вопрос правильного разграничения прав доступа (между суперпользователем и пользователями - какие им выдаются права и на какое оборудование или ПО), не доверять чужому коду (сначала всё проверять, т.е. хотя бы мельком пролистывать, чтобы внутри не было зловредного влияния) и тщательности настройки безопасности вашего сервера, чтобы к нему было хотя бы сложно подобраться...

- Все кто говорит, что «Программы, которые я использую в Windows не устанавливаются на Linux», Вы задумайтесь, а зачем они должны устанавливаться!!! Ведь это совсем другая ОС, там свои программы! Также можно сказать и про Windows, что «программы которые работают в Linux не устанавливаются в Windows», для Linux существуют много своих программ не уступающим Windows-ким, также многие производители программного обеспечения выпускают свои продукты как для Windows, так и для Linux.

- Linux более производительней, тем более серверный вариант операционной системы. Объясняю, серверные операционные системы Linux без интерфейсные, а большую часть ресурсов (больше половины!!!) как раз занимает интерфейс ОС, т.е. визуальная оболочка (на сегодняшний день получили широкое распространение и версии Windows без графического интерфейса).

- ОС Linux, даже при самое корявой настройке, практически никогда не зависает (я имею в виду саму операционную систему). Например, все встречались с ситуацией, когда в Windows у Вас все замирает, Вы не можете не пошевелить мышкой, даже ctrl+alt+del нажать не можете, и Вам приходиться перезагружаться. Linux устроена таким образом что такая ситуация исключена, разве что в одном случае когда Вы сами вызываете такую ситуацию.

- Касаемо серверной ОС Linux она достаточно проста в конфигурирование, в отличие от аналогов Windows, в которых очень много всяких разных прибомбасов, в которых не так легко разобраться. Сама система Linux и все ее службы настраиваются путем редактирования конфигурационных файлов. Это обычные текстовые файлы, зная их расположение и формат, Вы сможете настроить любой дистрибутив, даже если у Вас под рукой нет никаких инструментов, кроме текстового редактора.

Я не хочу популяризировать ОС Linux и каким-то образом принижать Windows, но в большинстве случаев лучшего варианта как использование одного из дистрибутивов Linux не найти.

Предисловие

В данной большой статье рассматриваются базовые настройки серверов на различных дистрибутивах Linux. Статья пригодится для тех не всё помнит, может что-нибудь забыть, впервые настраивает или имеет пробелы в знаниях. Главное постоянно развиваться.

Все настройки проверены годами на многих дистрибутивах Linux.

Для всех примеров за основу берётся Debian 11 на VPS-сервере в сравнении на домашней виртуальной машине в Virtual Box. Однако, все настройки легко подойдут хоть на Archlinux, хоть на свеженький Ubuntu. Главное заменить один менеджер пакета на другой и подправить наименования некоторых утилит или библиотек, требующихся для установки. В некоторых дистрибутивах могут также измениться расположение файлов настроек в системе, но сами параметры остануться абсолютно одинаковыми.

Не обязательно следовать прямо по всем пунктам подряд, но с каждым пунктом безопасность вашего сервера будет на порядок расти. К тому же вы делаете более предсказуемое поведение любых сервисов, которые планируете установить. Если оставлять большинство параметров по умолчанию - велик шанс, что у вас что-нибудь может сразу и не заработать, т.е. с первой попытки. В этом случае вы, скорее всего, будете очень долго разбираться что и почему не работает так как вы этого хотели.

Вы можете использовать только те настройки, которые нужны вам здесь и сейчас и пропустить остальные. Безопасность, стабильность и предсказуемое поведение сервисов вашего сервера зависит только от вас. В любом случае - решать только вам.

Желаю вам удачи!

Теперь перейдем непосредственно к основам Linux Server.

Оглавление

- Настройка репозиториев в Debian и Ubuntu подобных дистрибутивах.

- Права доступа.

- Swap, swappiness.

- Настройки сетевых соединений.

- Настройка безопасности SSH соединений.

- Ловушка SSH.

- Форвардинг, sysctl.

- Конфликт портов или автозапуск из ниоткуда apache2.

- Apparmor.

- Настройка времени и локали.

- Настройка фаервола.

- Настройка Fail2ban.

- Настройка DNS.

- Установка и настройка wireguard.

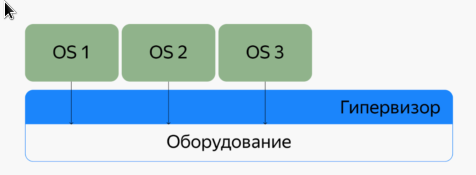

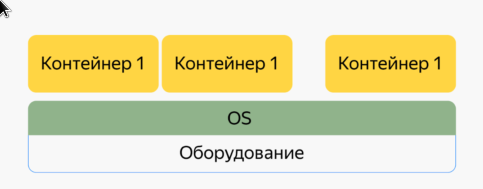

- Docker, docker-compose.

- Установка и настройка Docker + docker-compose.

- Запуск и остановка docker контейнеров.

- Примеры «docker-compose.yml» файлов.

- Nginx Reverse Proxy.

- Кэш память в Linux.

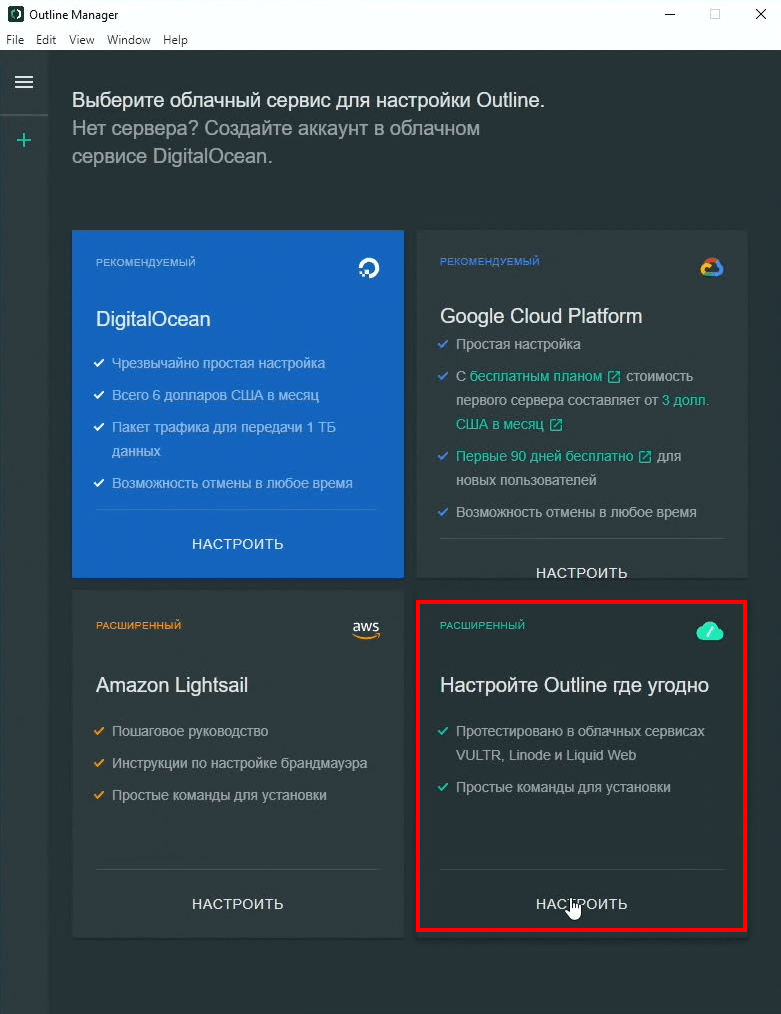

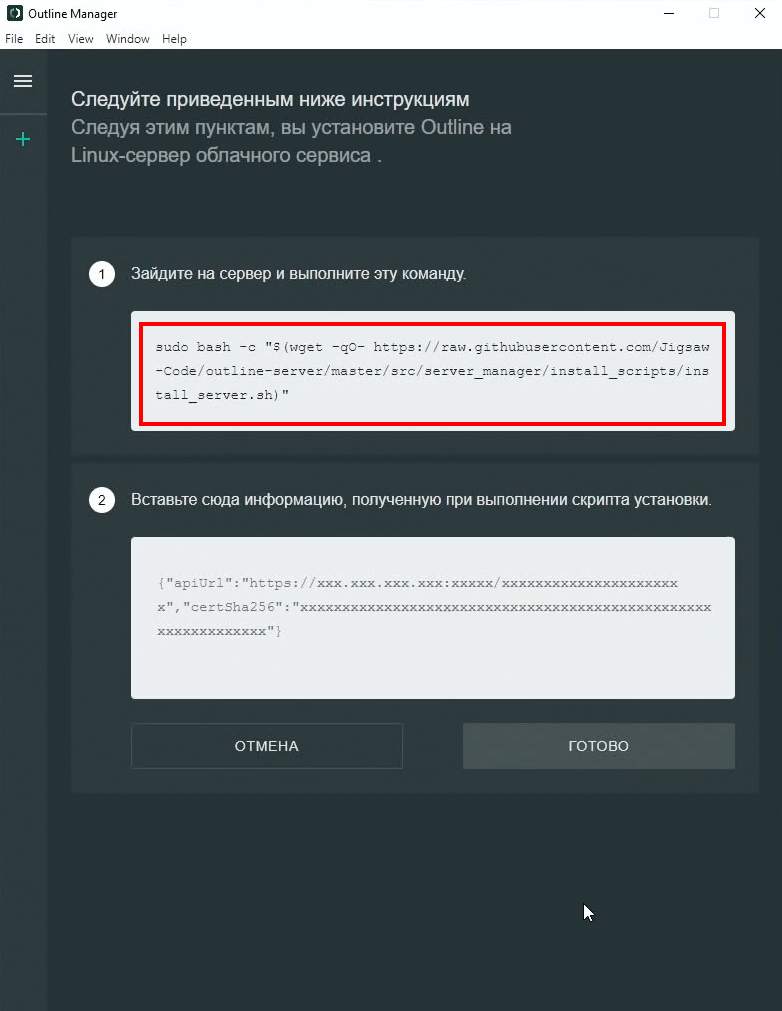

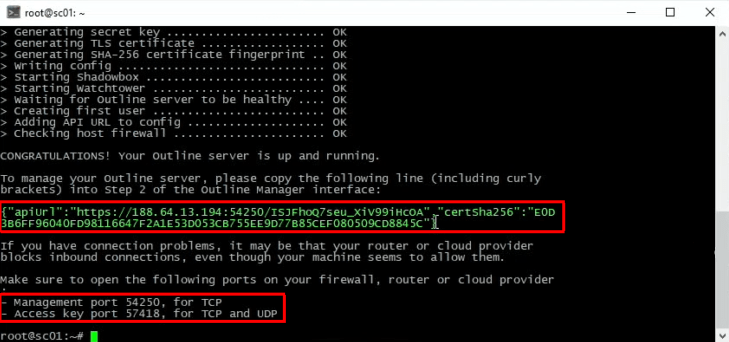

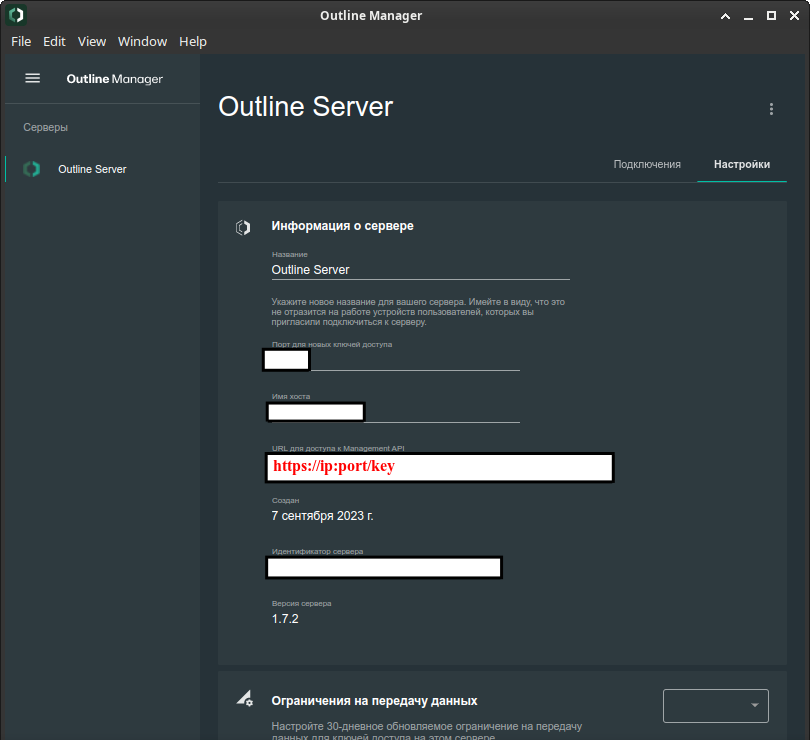

- Outline рядом с Wireguard.

- SOCKS5 Proxy.

- Большое руководство по чёрным спискам IP-адресов.

«Podman», «Podman-Compose» и «Cockpit» рассмотрим в другой статье, т.к. он на порядок сложнее, чем «Docker» и «Docker-Compose» и в установке, и в настройке, и в использовании.

1. Настройка репозиториев в Debian и Ubuntu подобных дистрибутивах.

Обычно при запуске любого Linux сервера на Debian или Ubuntu подобных дистрибутивах Linux у вас всегда будут одинаковые настройки репозиториев.

Обычно одна единственная настройка всегда мешает обновлению сервера и в принципе любой установке. А именно - это наличие ссылки на CD или DVD диск репозитория, с которого производилась установка системы, в настройках репозиториев.

Чтобы её исправить нужно выполнить всего одну команду - открыть файл с настройкой и закоментировать строку с этой ссылкой, сохранить и закрыть файл.

# Регистрируемся как суперпользователь, если вы входили под каким-нибудь обычным пользователем, например, когда система установлена вами самими, а не хостингом, или на вашем оборудовании $ su $ nano /etc/apt/sources.list # deb cdrom ... CTRL + o CTRL + x

Всё можно обновлять список пакетов.

$ apt update

2. Права доступа.

Обычно при запуске любого VPS или VDS сервера на любом дистрибутиве Linux у вас всегда будет только один суперпользователь. Если вы самостоятельно устанавливали систему, то наверняка указывали какого-нибудь пользователя.

В случае же когда у вас только один суперпользователь лучше сразу разграничить права доступа с помощью создания пользователей. Позже это разграничение поможет в настройке безопасности SSH-соединений. И ваш сервер станет чуточку безопаснее.

Но самое главное вот в чём:

Когда у вас есть некий пользователь с ограниченным набором прав доступа к вашему серверу, пусть даже если у вас будет использоваться вход только по паролю на ваш сервер через SSH-соединение, то даже если ваш пароль взламают - злоумышленникам ещё предстоит потрудится взломать пароль суперпользователя, чтобы получить полный контроль над сервером. В случае же, когда у вас только один суперпользователь - злоумышленники значительно легче забирают ваш сервер себе, сразу меняют все пароли и доступы.

И вы больше ничего и никогда не сможете сделать.

Кроме, как обратиться в тех-поддержку и полностью всё переустановить, удалив и полностью потеряв всё содержимое вашего сервера, т.к. злоумышленники наверняка уже к тому времени либо скомпрометируют ваши данные, либо заразят зловредным кодом.

Поэтому обязательно настраивайте себе отдельного пользователя с ограниченным набором прав доступа, руководствуясь этим пунктом.

Для начала необходимо установить утилиту sudo (она предназначена для того, чтобы делегировать привелегированные ресурсы пользователем с ведением протокола работы), создать группу привелегированного доступа (хотя это и не обязательно), дать группе соответствующие права доступа, создать пользователя и добавить пользователя в эту группу.

Команды выполняются от имени суперпользователя: «$ su».

# Устанавливаем sudo $ apt install sudo -y # Добавляем группу. Там уже в принципе есть нужная группа («sudo»), но мне, например, понятнее со своей группой, а не системной. $ /usr/sbin/groupadd wheel # Создаем пользователя и сразу добавляем в созданную группу $ /usr/sbin/useradd myuser -m -g users -G wheel,users -s /bin/bash # Меняем пароль пользователя $ passwd myuser # Добавляем группу wheel в sudo файл в самом конце $ nano /etc/sudoers %wheel ALL=(ALL:ALL) ALL CTRL + o CTRL + x

Теперь, перезагрузите ваш сервер.

Если вам необходимо можно добавить пользователю необходимые дополнительные полномочия. Вот список групп с описаниями полномочий. Обратите внимание, что в разных дистрибутивых могут быть разные наборы групп с соответствующими полномочиями. Т.е. каких-то групп может и не быть. Поэтому обязательно проверьте есть ли вообще в системе такая группа.

Проверим существование группы, например администрирования - adm. Естественно, проверка выполняется от имени суперпользователя.

$ cat /etc/group | grep -Ei "adm"

Переходим к спискам групп и полномочий.

| adm | Администрирование |

| ftp | Доступ к файлам FTP |

| games | Доступ к игровым программам |

| http | Доступ к файлам HTTP |

| log | Доступ к лог-файлам, syslog-ng |

| rfkill | Управление питанием беспроводных устройств |

| sys | Администрирование принтеров CUPS |

| systemd-journal | Доступ к журналам systemd |

| users | Стандартная группа пользователей |

| uucp | Доступ к устройствам RS-232 |

| dbus | Используется внутри dbus. |

| kmem | Доступ к виртуальной памяти ядра |

| locate | Доступ к быстрому поиску файлов по имени |

| lp | Доступ к устройствам параллельного порта |

| Доступ к почтовым клиентам | |

| nobody | Непривилигированная группа |

| proc | Доступ к информации о процессах |

| smmsp | sendmail группа |

| tty | Доступ к последовательным и параллельным портам |

| utmp | Полные представления о пользователях системы |

| audio | Прямой доступ к звуковому оборудованию |

| disk | Доступ к блочным устройствам |

| floppy | Доступ к флоппи-дискам |

| input | Доступ к устройствам ввода |

| kvm | Доступ к виртуальным машинам KVM |

| optical | Доступ к CD, DVD, ISO |

| scanner | Доступ к сканерам |

| storage | Доступ к съемным дискам |

| video | Доступ к устройствам захвата видео |

Добавляем пользователя во все необходимые группы одной командой.

$ sudo /usr/sbin/usermod -aG audio,video myuser

Если не получается, можно добавить в каждую группу по очерди, т.е. по одной.

$ gpasswd -a myuser audio

$ gpasswd -a myuser video

3. Swap, swappiness.

SWAP – один из механизмов виртуальной памяти, при котором отдельные фрагменты памяти перемещаются из ОЗУ в так называемые области подкачки (swap area или swap space), расположенные на вторичном хранилище данных (отдельный дисковый раздел или просто файл в файловой системе), освобождая ОЗУ для загрузки других активных фрагментов памяти.

У файла подкачки существуют параметры, которые сообщают ОС, как часто его нужно использовать. Это явление называется «свопингом» и может иметь значение в пределах 0 - 100. Если это значение ближе к 100, ядро будет перемещать в раздел подкачки больше информации чтобы освободить память. При значениях ближе к нулю, система будет использовать подкачку только при крайней необходимости.

К примеру, в версии Ubuntu Linux для рабочего стола устанавливается параметр 60, а в серверных редакциях операционной системы - 1.

Существует много споров - нужен ли swap вообще. Когда у вас большое количество оперативной памяти - то такой раздел может быть и не нужным, а если есть, то скорее всего никогда не будет использоваться.

НО! Обратите внимание!

Если swappinses у вас стоит по умолчанию, то скорее всего при заполнении оперативной памяти всего лишь на 40% - система потребует swap раздел, если система не находит такой раздел - то создаёт его автоматически. Естественно, если у вас твердотельный накопитель - скорость не сильно упадёт и вы можете даже ничего толком и не заметить. Однако, если у вас жесткий диск - даже в Linux могут ощущаться тормоза. Да, даже в Linux. Я такое несколько раз видел.

Самое интересное в том, что на любых VPS или VDS серверах swap раздела в принципе не существует, т.е. его никогда не создают, а swappines по умолчанию установлен на 60.

Давайте исправлять этот момент. Посмотрим сколько у нас оперативной памяти, есть ли вообще swap, если нет, то создадим.

В VPS и VDS серверах лучше хотя бы создать файл подкачки в корне системного раздела, т.к. менять структуру диска во избежании проблем с последним не рекомендуется. На своих серверах заранее продумывайте стркутукру и создавайте такой раздел, хотя бы, в 2 ГБ. О размерах такого раздела уже говорилось ранее в одной из предыдущих статей.

# Смотрим на всю оперативную память $ free -h # Проверяем swap $ sudo swapon --show # Создаем файл подкачки, форматируем и подключаем $ sudo fallocate -l 2G /swapfile $ sudo chmod 600 /swapfile $ sudo mkswap /swapfile $ sudo swapon /swapfile # Проверяем $ sudo swapon --show

Создали и подключили. Однако после перезагрузки системы он не подключиться автоматически. Сделаем это.

$ sudo nano /etc/fstab /swapfile none swap defaults,discard 0 0 CTRL + o CTRL + x

Теперь займемся настройкой swappiness.

Посмотрим сколько у нас установленно на данный момент.

$ sudo cat /proc/sys/vm/swappiness

Установим временное значение до перезагрузки системы.

$ sudo sysctl vm.swappiness=10

Установим значение постоянным.

$ sudo nano /etc/sysctl.d/00-sysctl.conf vm.swappiness=10 CTRL + o CTRL + x

4. Настройки сетевых соединений.

Обычно в VPS или VDS серверах настраивать сетевые интерфейсы не просто не требуется, а в принципе не рекомендуется. В домашнем сервере - будь то реальный ПК или виртуальная машина, такая настройка чаще всего просто необходима, чтобы не в роутере настраивать IP адреса ваших домашних ПК, а только на сервере. В организациях же чаще всего такая настройка тоже необходима, т.к. сам сервер и раздает всем ПК в сети IP адреса из заданного диапазона.

Поэтому рассмотрим только базовую настройку того, что вам точно пригодится.

Если какие-то команды не выполняются просто допишите к ним следующую строку: «/usr/sbin/». Дело в том, что почти во всех Debian или Ubuntu подобных дистрибутивах ссылки на многие утилиты перенесли именно в этот каталог, но не стали добавлять эти же ссылки в базовый путь по умолчанию. И также возможно, что данные утилиты просто не установлены в систему. Это вполне нормальное явление. В качестве примера - всеми любимая утилита ifconfig.

Доустановим всего, что нам не хватает.

$ sudo apt install curl gnupg wget bash-completion net-tools git -y

Теперь все необходимые утилиты точно есть в «/usr/sbin/».

Далее мне понадобится ip-калькулятр. Можно было бы посчитать подсети вручную, но лично мне лень и я воспользуюсь специальным калькулятором.

$ sudo apt install ipcalc -y # Пользоваться примерно так $ ipcalc 192.168.0.100/24

Теперь посмотрю какой мне на моем VPS выдал IP адрес провайдер, а также маску, вещательный адрес и шлюз по умолчанию. Просто, чтобы не потерять доступ их же и буду вводить в ручных настройках сети. На домашнем сервере или в организации, скорее всего, такой адрес будет выбран системным администратором самостоятельно, а не выдан неким маршрутизатором, чтобы не лазить в настройки маршрутизатора или роутера. Такое необходимо когда доступа к самому роутеру или маршрутизатору нет, а вы при этом всё равно хотите установить фиксированный ip-адрес.

Для примера, пусть ответ будет как на домашней виртуальной машине.

$ /usr/sbin/ifconfig ... enp0s3: ... inet 192.168.0.110 netmask 255.255.255.0 broadcast 192.168.0.255 ... $ sudo route Kernel IP routing table Destination Gateway Genmask Flags Metric Ref Use Iface default 192.168.0.1 0.0.0.0 UG 0 0 0 enp0s3 ...

Записываем.

- 192.168.0.110 - ipv4.

- 255.255.255.0 - маска.

- 192.168.0.255 - вещательный адрес.

- 192.168.0.1 - шлюз по умолчанию.

Проверяем через ip-калькулятор - на всякий случай. Вдруг что-нибудь где-нибудь введёте неправильно, ошибётесь на одну единственную циферку - из-за чего можете даже потерять доступ. Такие настройки лучше лишний раз перепроверить, т.е. перепроверить самого себя и убедиться что всё сделано правильно и без ошибок.

$ ipcalc 192.168.0.110/24 Address: 192.168.0.110 11000000.10101000.00000000. 01101110 Netmask: 255.255.255.0 = 24 11111111.11111111.11111111. 00000000 Wildcard: 0.0.0.255 00000000.00000000.00000000. 11111111 => Network: 192.168.0.0/24 11000000.10101000.00000000. 00000000 HostMin: 192.168.0.1 11000000.10101000.00000000. 00000001 HostMax: 192.168.0.254 11000000.10101000.00000000. 11111110 Broadcast: 192.168.0.255 11000000.10101000.00000000. 11111111 Hosts/Net: 254 Class C, Private Internet

- HostMin - шлюз. Верно.

- Broadcast - вещательный адрес. Тоже верно.

- Netmask - маска сети. Верно.

- Address - ip адрес присвоенный провайдером, маршрутизатором или выбранный вами самими.

В домашней сети я могу выбрать любой другой адрес в той же подсети. В организации надо смотреть на наличие свободных, т.е. не занятых, адресов в имеющейся подсети. В VPS и VDS серверах менять их ни в коем случае нельзя! Именно поэтому и нужно было узнать все эти параметры. Теперь можно вручную указать их в настройках сетевой конфигурации.

Вот теперь можно переходить к настройкам интерфесов.

$ sudo nano /etc/network/interfaces ... allow-hotplug enp0s3 auto enp0s3 # iface enp0s3 inet dhcp iface eth1 inet static address 192.168.0.110 netmask 255.255.255.0 gateway 192.168.0.1 broadcast 192.168.0.255 # dns-nameservers 192.168.0.1 8.8.8.8 # pre-up ifconfig enp0s3 hw ether xx:xx:xx:xx:xx:xx # pre-up ip link set enp0s3 address xx:xx:xx:xx:xx:xx ... # Сохраняем и выходим CTRL + o CTRL + x $ sudo systemctl restart networking # Но лучше бы было просто перезагрузить сервер и снова войти по ssh

Параметр «dns-nameservers» закоментирован и отвечает за настройку DNS-серверов для данного сетевого адаптера. Однако, здесь dns-сервера никогда не указывают, потому что это не совсем правильно, хотя и вполне возможно. Об этом будет подробнее рассказано в другой главе.

Настройка «pre-up» отвечает за запуск дополнительных параметров в зависимости от состояния сетевого адаптера. Например, смена мак-адреса перед запуском интерфейса. В данном случае указны 2 способа смены - утилитой из «net-tools» и встроенной. Их можно указывать несколько штук построчно, и даже одинаковые состояния в каждой из строк. Также сюда же можно вносить дополнительные iptables правила, которые должны быть вставлены при запуске того или иного интерфейса. Например, перед запуском интерфейса добавлять правила, а после отключения удалять. Или же, например записать все iptables правила добавления в один скрипт, правила удаления в другой скрипт и укаждый из этих скриптов указать в соответствующих строках перед запуском интерфейса и после отключения интерфейса.

Вот список состояний, которые могут вам пригодиться.

- pre-up - Выполнить команду перед запуском интерфейса.

- post-up - Выполнить команду после запуска интерфейса.

- pre-down - Команда перед отключением.

- post-down - Команда после отключения.

Если вы что-нибудь меняете вручную - вот список параметров, которые можно использовать в ручных, а не скриптовых, настройках.

- iface - Указывает имя интерфейса.

- up - Выполнить команду при запуске интерфейса.

- auto - автоматический запуск интерфейса.

- inet - Указывает description такие как static, dhcp или manual.

- address - Устанавливает ip адрес для статического соединения.

- netmask - Установка маски сети.

- broadcast - Широковещательный адрес.

- metric - Приоритет для шлюза по умолчанию.

- gateway - Шлюз по умолчанию.

- hwaddress - Установить MAC адрес.

- mtu - Размер одного пакета.

6. Ловушка SSH.

Не секрет, что интернет — очень враждебная среда. Как только вы поднимаете сервер, он мгновенно подвергается массированным атакам и множественным сканированиям. Фактически, на среднем сервере 99% трафика может быть вредоносным.

Tarpit — это порт-ловушка, который используется для замедления входящих соединений. Если сторонняя система подключается к этому порту, то быстро закрыть соединение не получится. Ей придётся тратить свои системные ресурсы и ждать, пока соединение не прервётся по таймауту, или вручную разрывать его.

Чаще всего тарпиты применяют для защиты. Технику впервые разработали для защиты от компьютерных червей. А сейчас её можно использовать, чтобы испортить жизнь спамерам и исследователям, которые занимаются широким сканированием всех IP-адресов подряд.

Одному из сисадминов по имени Крис Веллонс, видимо, надоело наблюдать за этим безобразием — и он написал маленькую программку «Endlessh», тарпит для SSH, замедляющий входящие соединения. Программа открывает порт (по умолчанию для тестирования указан порт «2222») и притворяется SSH-сервером, а на самом деле устанавливает бесконечное соединение с входящим клиентом, пока тот не сдастся. Это может продолжаться несколько дней или больше, пока клиент не отвалится.

В предыдущем пункте вы настраивали ваш SSH-сервер, и надеюсь всё-таки поменяли порт по умолчанию на какой-нибудь другой. Затем в фаерволе открыли именно этот другой порт. Чтобы ловушка работала для неё надо будет в фаерволе открыть порт на котором она будет работать. Пускай на порту по умолчанию - 22.

Обратите внимание на один момент перед тем, как будете или не будете использовать эту утилиту!

Открывать лишний порт в любом фаерволе - не слишком безопасно. Если вы добавляли отдельного обычного пользователя с ограниченными правами доступа и правильно настроили безопасность SSH-соединений только по SSH-ключам + обязательно использовали фаервол Firewalld и Fail2ban - то такая ловушка вам, скорее всего, будет и не нужна вообще. НО, если у вас используется вход по паролям - лучше, если вы откроете этот лишний порт в вашем фаерволе. Допустим, настоящий SSH-сервер, тогда будет на неком отличном от 22 порту (например, 2222) - то лучше, если ловушка при этом будет работать именно на 22 порту.

Установка утилиты.

Само собой, если вы ещё не устанавливали «docker» и «docker-compose» - пока что пропустите этот пункт и вернитесь к нему, как только установите.

Интернет предлагает установить утилиту напрямую 2-мя способами - с помощью установки и настроки пакета, который есть в Debian репозиториях и клонировать репозиторий.

Вы можете выбрать любой из этих способов, найти их в интернете и использовать. У каждого способа есть свои достоинства и недостатки. Что-то может заработать с первого раза, или наоборот не заработать вообще и вы просто промучаетесь пытаясь установить этими способами.

Я же предлагаю несколько более универсальный подход - используя docker-контейнер. В этом случае утилита точно заработает с первого раза.

Создадим для этой утилиты отдельную папку и запустим контейнер.

$ mkdir -p endlessh && cd endlessh

$ nano docker-compose.yml

---

version: "3.4"

services:

endlessh:

image: harshavardhanj/endlessh:alpine

container_name: endlessh

ports:

- "22:2222"

restart: unless-stopped

# Сохраняем и выходим

CTL + o

CTRL + x

# Запускаем, ждем когда запуститься и проверяем.

$ sudo docker-compose up -d

$ sudo docker ps

Разумеется, не забудьте поменять порт в вашем sshd_config и открыть оба порта в вашем фаерволе во входной зоне из интернета.

В данном конкретном примере - это 2222 и 22.

Если вам нужны подробности по установке или работе данной ловушки, то можете посмотреть о ней исчерпывающий ролик на youtube канале «#linux life».

7. Форвардинг, sysctl.

sysctl — в BSD и Linux — программа, предназначенная для управления отдельными параметрами ядра, безопасности, сетевой подсистемы. Позволяет определять и задавать такие параметры как размер сегмента разделяемой памяти, ограничение на число запущенных процессов, а также включать функции наподобие маршрутизации.

Имеет конфигурационный файл /etc/sysctl.conf, в котором переопределяются необходимые параметры.

Для начала сделаем его бэкап следующей командой:

$ sudo cp /etc/sysctl.conf /etc/sysctl.conf.back

Значение sysctl загружаются во время загрузки системы из файла /etc/sysctl.conf. В этом файле могут быть пустые строчки, комментарии (строки, начинающиеся на символ «#» или точку с запятой), а также строки в формате «переменная=значение». Если вы хотите применить его в любой момент времени, вы можете сделать это с помощью команды «sysctl -p».

О каждом из параметров вы можете почитать вот в этой «статье». Я же расскажу о наиболее часто применяемых.

- включить пересылку IP-пакетов (ipv4, ipv6).

- net.ipv4.ip_forward = 1

- net.ipv4.conf.all.forwarding = 1

- net.ipv6.conf.all.forwarding = 1

- net.ipv6.conf.default.forwarding = 1

- Позволяет осуществлять фильтрацию пакетов по адресу назначения (проверка адреса получателя).

- net.ipv4.conf.all.rp_filter = 1

- Включает/выключает проксирование arp-запросов для заданного интерфейса. ARP-прокси позволяет маршрутизатору отвечать на ARP запросы в одну сеть, в то время как запрашиваемый хост находится в другой сети. С помощью этого средства происходит обман отправителя, который отправил ARP запрос, после чего он думает, что маршрутизатор является хостом назначения, тогда как в действительности хост назначения находится на другой стороне маршрутизатора. Маршрутизатор выступает в роли уполномоченного агента хоста назначения, перекладывая пакеты от другого хоста.

- net.ipv4.conf.default.proxy_arp = 1

- net.ipv4.conf.all.proxy_arp = 1

- Включает/выключает выдачу ICMP Redirect другим хостам. Эта опция обязательно должна быть включена, если хост выступает в роли маршрутизатора любого рода. Как правило ICMP-сообщения о переадресации отправляются в том случае, когда необходимо сообщить хосту о том, что он должен вступить в контакт с другим сервером. Переменная может иметь два значения 0 (выключено) и 1 (включено). Значение по-умолчанию 1 (включено). Если компьютер не выступает в роли маршрутизатора, то эту переменную можно отключить.

- net.ipv4.conf.default.send_redirects = 1

- net.ipv4.conf.all.send_redirects = 0

- Отключения поддержки IPv6.

- net.ipv6.conf.all.disable_ipv6 = 1

- net.ipv6.conf.default.disable_ipv6 = 1

- net.ipv6.conf.lo.disable_ipv6 = 1

Вот все указанные настройки. Благо у меня на VPS сервере не используется IPV6, поэтому я его отключу. При необходимости, смогу зайти через ssh, закоментировать соответствующие строки и перезагрузить правила соответствующей командой.

$ sudo nano /etc/sysctl.conf net.ipv4.ip_forward=1 net.ipv4.conf.all.forwarding=1 net.ipv6.conf.all.forwarding=1 net.ipv6.conf.default.forwarding = 1 net.ipv4.conf.all.rp_filter = 1 net.ipv4.conf.default.proxy_arp = 1 net.ipv4.conf.all.proxy_arp=1 net.ipv4.conf.default.send_redirects = 1 net.ipv4.conf.all.send_redirects = 0 net.ipv6.conf.all.disable_ipv6 = 1 net.ipv6.conf.default.disable_ipv6 = 1 net.ipv6.conf.lo.disable_ipv6 = 1 # Сохраняем и выходим CTRL + o CTRL + x # Принимаем правила без перезагрузки ОС. $ sudo sysctl -p

Есть еще одни параметры ядра, которые часто используются при работе с «SOCK5 Proxy».

В конце файла параметров ядра «/etc/sysctl.conf» указываем такие настройки:

- Максимальное количество открытых файловых дескрипторов в системе. Это ограничение на уровне ядра, которое влияет на общее число одновременно открытых файлов и сокетов.

- fs.file-max = 51200

- Максимальный размер буфера приема данных для сокетов (в байтах). Позволяет увеличить объем данных, которые ядро может буферизовать при приеме.

- net.core.rmem_max = 67108864

- Максимальный размер буфера отправки данных для сокетов (в байтах)

- net.core.wmem_max = 67108864

- Максимальное количество пакетов, которые могут быть поставлены в очередь на обработку сетевым интерфейсом, если драйвер не успевает их обрабатывать. Увеличение помогает при высоких нагрузках на сеть.

- net.core.netdev_max_backlog = 250000

- Максимальное количество ожидающих соединений в очереди для TCP-сокетов (backlog). По умолчанию обычно 128, увеличение улучшает обработку большого числа одновременных подключений.

- net.core.somaxconn = 4096

- Устанавливает алгоритм планирования очереди пакетов по умолчанию. fq (Fair Queueing) — современный алгоритм, улучшающий производительность и справедливость распределения трафика.

- net.core.default_qdisc = fq

- Включает защиту от SYN-флуд атак с помощью TCP SYN cookies. Позволяет серверу корректно обрабатывать большое количество входящих SYN-запросов.

- net.ipv4.tcp_syncookies = 1

- Позволяет повторно использовать TCP-соединения в состоянии TIME_WAIT для новых исходящих соединений, что уменьшает количество занятых портов.

- net.ipv4.tcp_tw_reuse = 1

- Отключает агрессивное быстрое удаление TIME_WAIT-соединений. В новых ядрах этот параметр считается опасным и может нарушать работу с NAT.

- net.ipv4.tcp_tw_recycle = 0

- Время (в секундах), в течение которого TCP-соединение остается в состоянии FIN-WAIT-2 перед закрытием. Уменьшение этого времени освобождает ресурсы быстрее.

- net.ipv4.tcp_fin_timeout = 30

- Время (в секундах) бездействия TCP-соединения перед отправкой keepalive пакета для проверки живости соединения.

- net.ipv4.tcp_keepalive_time = 1200

- Диапазон локальных портов, используемых для исходящих соединений. Расширение диапазона помогает избежать исчерпания портов при большом количестве соединений.

- net.ipv4.ip_local_port_range = 10000 65000

- Максимальное количество ожидающих TCP-соединений в состоянии SYN_RECV (полуоткрытых соединений). Увеличение помогает при большом количестве одновременных попыток подключения.

- net.ipv4.tcp_max_syn_backlog = 4096

- Максимальное количество TCP-соединений в состоянии TIME_WAIT, которые ядро может хранить. Если превышено, старые соединения будут удаляться принудительно.

- net.ipv4.tcp_max_tw_buckets = 5000

- Включает TCP Fast Open — механизм ускоренного установления TCP-соединений. Значение 3 обычно означает включение как для клиентов, так и для серверов.

- net.ipv4.tcp_max_tw_buckets = 5000

- Память (в страницах) для TCP буферов: минимальное, среднее и максимальное значения. Управляет объемом памяти, выделяемой TCP стеку.

- net.ipv4.tcp_mem = 25600 51200 102400

- Размеры буферов приема TCP: минимальный, по умолчанию и максимальный (в байтах).

- net.ipv4.tcp_rmem = 4096 87380 67108864

- Размеры буферов отправки TCP: минимальный, по умолчанию и максимальный (в байтах).

- net.ipv4.tcp_wmem = 4096 65536 67108864

- Включает динамическое определение MTU (максимального размера пакета) для обхода проблем с фрагментацией.

- net.ipv4.tcp_mtu_probing = 1

- Устанавливает алгоритм управления перегрузкой TCP. Hybla — алгоритм, оптимизированный для сетей с высокой задержкой.

- net.ipv4.tcp_congestion_control = hybla

Выглядит это следующим образом.

$ sudo nano /etc/sysctl.conf fs.file-max = 51200 net.core.rmem_max = 67108864 net.core.wmem_max = 67108864 net.core.netdev_max_backlog = 250000 net.core.somaxconn = 4096 net.core.default_qdisc = fq net.ipv4.tcp_syncookies = 1 net.ipv4.tcp_tw_reuse = 1 net.ipv4.tcp_tw_recycle = 0 net.ipv4.tcp_fin_timeout = 30 net.ipv4.tcp_keepalive_time = 1200 net.ipv4.ip_local_port_range = 10000 65000 net.ipv4.tcp_max_syn_backlog = 4096 net.ipv4.tcp_max_tw_buckets = 5000 net.ipv4.tcp_fastopen = 3 net.ipv4.tcp_mem = 25600 51200 102400 net.ipv4.tcp_rmem = 4096 87380 67108864 net.ipv4.tcp_wmem = 4096 65536 67108864 net.ipv4.tcp_mtu_probing = 1 net.ipv4.tcp_congestion_control = hybla # Сохраняем и выходим CTRL + o CTRL + x # Принимаем правила без перезагрузки ОС. $ sudo sysctl -p

8. Конфликт портов или автозапуск из ниоткуда apache2.

Иногда, не только в VPS или VDS, но и при установке на домашний ПК или в организации при установке совершенно нового образа Debian или Ubuntu может встретиться такая ситуация - когда вы попросту не можете запустить какой-либо сервис на выбранном порту.

Я встретился с ситуацией, когда на совершенно новом дистрибутиве Debian 11 не cмог запустить только что установленный nginx на 80 порту.

Что делать в таком случае?

Во первых отследить - сервис, который перекрывает вам доступ, а точнее порт сервиса.

$ sudo netstat -tlnp

Команда покажет все запущенные процессы и прослушиваемые порты. По портам сможете найти интересующий вас сервис. В последнем столбце как раз и увидете наименование сервиса, который портит вам жизнь.

Теперь необходимо именно выключить найденый сервис, а не просто убить процесс. В моём случае это был сервис apache2.

$ sudo update-rc.d apache2 disable

9. Apparmor.

AppArmor - программный инструмент упреждающей защиты, основанный на политиках безопасности, которые определяют, к каким системным ресурсам и с какими привилегиями может получить доступ то или иное приложение. В AppArmor включён набор стандартных профилей, а также инструменты статического анализа и инструменты, основанные на обучении, позволяющие ускорить и упростить построение новых профилей.

Т.е. AppArmor - это реализация Модуля безопасности линукс по управлению доступом на основе имен. AppArmor ограничивает отдельные программы набором перечисленных файлов и возможностями в соответствии с правилами Posix 1003.1e.

AppArmor устанавливается и загружается по умолчанию. Он использует профили приложений для определения какие файлы и права доступа требуются приложению.

AppArmor является важным элементом безопасности, который по умолчанию включен в Ubuntu начиная с версии Ubuntu 7.10. Тем не менее, AppArmor работает в фоновом режиме, поэтому Вы можете не знать, что это такое и что AppArmor делает.

AppArmor блокирует уязвимые процессы, ограничивая уязвимость в системе безопасности, которая может возникнуть из-за уязвимости этих процессов. AppArmor можно также использовать для того, чтобы заблокировать Mozilla Firefox для повышения безопасности, но по умолчанию это не делается.

Например, одним из приложений, для которого по умолчанию в Ubuntu задано такое ограничение, является Evince — программа просмотра файлов PDF. Когда Evince работает под вашей пользовательской учетной записью, он может выполнять только вполне определенные действия. Для Evince предоставлены минимальные права доступа, необходимые только для запуска и работы с документами PDF. Если при рендеринге PDF с помощью Evince или при открытии вредоносного PDF, который хочет перехватить управление от Evince, были обнаружены уязвимости, AppArmor сможет ограничить ущерб, который может нанести Evince. В традиционной модели безопасности Linux для Evince будет разрешен доступ ко всему тому, к чему у вас есть доступ. При использовании AppArmor, доступ имеется только к тем вещам, которые требуются программе для просмотра PDF.

AppArmor, в частности, полезен для ограничения работы программ, в которых могут быть экспойты, например, веб-браузера или серверного программного обеспечения.

Для просмотра текущего состояния AppArmor, выполните в терминале следующую команду.

$ sudo apparmor_status

Вы также можете заметить, что AppArmor поставляется с профилем для Firefox - это файл usr.bin.firefox, находящийся в каталоге /etc/apparmor.d. По умолчанию он не включен, так как в нем для Firefox задано слишком много ограничений и из-за этого могут возникать проблемы. В каталоге /etc/apparmor.d/disable имеется ссылка на этот файл, что указывает, что этот профиль отключен.

Чтобы включить профиль Firefox и с помощью AppArmor ограничить действия, выполняемые Firefox, выполните следующие команды.

$ sudo rm /etc/apparmor.d/disable/usr.bin.firefox

$ cat /etc/apparmor.d/usr.bin.firefox | sudo apparmor_parser –a

После выполнения этих команд, снова запустите команду sudo apparmor_status и вы увидите, что теперь загружены профили для Firefox.

Чтобы отключить профиль Firefox в случае, если из-за него возникают проблемы, выполните следующие команды.

$ sudo ln -s /etc/apparmor.d/usr.bin.firefox /etc/apparmor.d/disable/

$ sudo apparmor_parser -R /etc/apparmor.d/usr.bin.firefox

Создать профиль для AppArmor не так сложно как кажется на первый взгляд. Для этого в системе существует несколько утилит. Но для начала давайте рассмотрим синтаксис файла, чтобы было понятно с чем мы имеем дело. Возьмем опять же файл от man.

include <tunables/global>

/usr/bin/man {

#include <abstractions/base>

#include <abstractions/nameservice>

capability setgid,

capability setuid,

/usr/bin/man r,

/usr/lib/man-db/man Px,

}

Основу профиля составляют адреса файлов, к которым программа может иметь доступ, а также разрешения для этих файлов. Синтаксис такой.

/адрес/файла права

Доступны такие права.

- r - разрешить чтение

- w - разрешить запись

- a - разрешить запись в конец файла

- px - разрешить запуск новых процессов если для них есть профиль

- Px - разрешить запуск новых процессов, если для них есть профиль и стереть переменные окружения

- ix - разрешить запуск нового процесса под профилем текущего

- m - разрешить загружать исполняемые файлы в память и запускать

- l - разрешить создавать символические ссылки на исполняемые файлы

- k - разрешить блокировать файлы

- ux - не контролировать новые процессы

- Ux - не контролировать новые процессы и очистить переменные окружения.

Этих полномочий вполне достаточно, для управления правами, но кроме списка файлов и их полномочий, файл профиля содержит еще директивы include и capability.

include позволяет включать другие файлы с разрешениями, они находятся в папке /etc/apparmor.d/abstractions/. Это такие же части профиля, со списком файлов и правами доступа. Они облегчают создание новых профилей.

С capability все немного сложнее. Программа может обращаться к ядру с помощью системных вызовов, эти вызовы Apparmor тоже контролирует. Посмотреть все доступные вызовы вы можете командой man capabilities. В нашем случае мы разрешаем процессу задать свой uid и gid, то есть сменить пользователя и группу, от которого он запущен.

Есть еще папка /etc/apparrmor.d/thunables с переменными, которые могут использоваться в каждом профиле. Но с ними разберемся по ходу. Теперь вы готовы к тому, чтобы создать профиль apparmor. Для примера будем создавать новый профиль для утилиты free. Напомню, что эта утилита показывает доступную оперативную память.

Сначала выполните такую команду, чтобы инициализировать шаблон профиля.

$ sudo aa-autodep free

Шаблон профиля создан, можете его посмотреть, теперь нужно выполнить профилирование программы, чтобы посмотреть какие ей файлы нужны и добавить их в профиль.

$ sudo aa-genprof free

Программа может попросить что запустить в отдельном окне терминала, и выполнить все действия, которые она может делать, затем нажать S.

Готово, теперь нажимаем F, чтобы завершить работу утилиты.

Если вы меняли профиль вручную, то его необходимо перезагрузить, чтобы изменения вступили в силу, для этого используйте команду.

$ sudo aa-parser имя_профиля -a

Перезагрузить все профили можно командой.

$ sudo service apparmor reload

Вообще, docker использует AppArmor для защиты, притом Docker Engine сам генерирует дефолтный профиль для AppArmor при запуске контейнера. Другими словами, вместо.

$ docker run --rm -it hello-world

запускается.

$ docker run --rm -it --security-opt apparmor=docker-default hello-world

Вообще, AppArmor не рекомендуется отключать, но бывает, что это необходимо - например из-за конфликта доступа, или потому что он потребляет слишком много оперативной памяти...

Если вам больше не нужен Apparmor и вы не не хотите, чтобы программа тратила системные ресурсы или хотите просто отключить ее для отладки, это можно сделать следующей командой.

$ sudo systemctl stop apparmor && sudo systemctl disable apparmor && sudo systemctl mask apparmor

Включить обратно можно аналогичной командой.

$ sudo systemctl unmask apparmor && sudo systemctl enable apparmor && sudo systemctl start apparmor

10. Настройка времени и локали.

Настройка и синхронизация времени.

10.1. Синхронизация timesyncd.

Системное время - важный параметр в работе сервера, так как на него завязаны почти все службы. Сегодня мы рассмотрим с вами, как настроить время в сервере Debian - установить его, указать или сменить часовой пояс, а так же настроить автоматическое обновление.

Во время установки Debian, сервер автоматически настраивает системное время на основе информации из bios. Инсталлятор предлагает вам выбрать только часовой пояс. При этом, если вы не правильно указали часовой пояс (timezone), его без проблем можно изменить после установки.

Так же ситуация, когда необходимо изменить время или часовой пояс, может возникнуть, если вы арендуете сервер за границей и вам разворачивают систему из готового образа. В таком случае timezone может быть указана не такая, как вы хотите.

Зачем, собственно, следить за точным временем на сервере, кроме непосредственно удобства восприятия этого времени? Причин может быть много.

- Для корректного логирования всех событий и последующего расследования инцидентов. Более того, одинаковое время должно быть на всех серверах, которые участвуют в работе.

- В доменной середе Windows для корректной работы протокола аутентификации Kerberos требуется примерно одинаковое время на всех участниках домена. Если ваш сервер Debian является членом домена, важно, чтобы его время не сильно отличалось от времени контроллера домена. Его нужно обязательно синхронизировать с ним.

- На сервере может располагаться какой-то сервис, который взаимодействует с пользователями. Если неправильно настроить часы или timezone, может возникнуть ситуация, когда для некоторых пользователей материалы будут отображаться со временем из будущего.

- Планировщик cron в своей работе использует системные часы. Если вы хотите предсказуемое поведение запланированных задач, время и часовой пояс должны быть настроены правильно.

Сначала посмотрим на системное время.

$ date

Сразу видим часовой пояс, дату и время в 12-ти или 24 часовом формате. Если у вас отображается 12-ти часовой формат добавьте +%R к date.

$ date +%R

Подобные параметры удобно использовать в скриптах.

$ date +%Y-%m-%d

$ date +%H-%M-%S

$ date +%Y-%m-%d_%H-%M-%S

$ date +%H-%M_%d.%m.%Y

Чтобы увидеть более подробную информацию о состоянии воспользуемся другой командой.

$ timedatectl status

Для того, чтобы вручную установить дату, используем упомянутую выше команду date, только уже с дополнительными параметрами.

$ sudo date 04220900

Здесь 04 — месяц, 22 — число, 09 — час, 00 — минут. Таким образом, формат команды получился вот такой - date MMDDhhmm.

То же самое, только через timedatectl.

$ sudo timedatectl set-time "2023-04-22 08:45:00"

Если вы получили ошибку - Failed to set time: Automatic time synchronization is enabled, значит у вас уже настроено автоматическое обновление времени. В таком случае timedatectl, в отличие от date, время менять не будет.

В моем случае timezone установлена как MSK, то есть московский часовой пояс. Если у вас указан другой часовой пояс, а вы, к примеру, хотите установить московский, то делается это просто. Смена часового пояса выполняется через timedatectl.

# Перед настройкой или изменением часового пояса, рекомендуется обновить список timezone на сервере. $ sudo apt update && sudo apt upgrade tzdata # Список всех timezоne, доступных для установки на сервере $ timedatectl list-timezones # Устанавливаем выбранную зону $ sudo timedatectl set-timezone Europe/Moscow # Включаем автообновление времени $ sudo timedatectl set-ntp true

В большинстве современных дистрибутивов с systemd служба синхронизации времени уже присутствует в дефолтной установке и реализуется через systemd-timesyncd. Эта служба призвана заменить ntpd. Со слов разработчиков, она легче и быстрее, чем ntpd, плюс интегрирована в systemd, поэтому для автоматической синхронизации времени рекомендуется использовать именно ее.

Тут важно понимать, что systemd-timesyncd не может работать в качестве сервера времени. Так что, если у вас одиночный сервер, вам вполне подойдет timesyncd. Если же вы хотите использовать свой сервер времени, то надо настраивать ntp.

Посмотрим на службу timesyncd.

$ timedatectl timesync-status

# Для надежности, можно убедиться, что служба работает, плюс, добавим ее сразу в автозагрузку, если ее там нет.

$ sudo systemctl status systemd-timesyncd

$ systemctl enable systemd-timesyncd

Список серверов для синхронизации времени в timedatectl настраивается в конфигурационном файле «/etc/systemd/timesyncd.conf». В случае, когда вы используете timesyncd, а не ntp, то сервера будут браться из этого файла.

Если у вас возникают ошибки при попытке синхронизировать время, возможно настройка этого файла поможет решить проблему.

В этом файле нас интересуют 2 строки: «NTP» и «FallbackNTP». Раскомментируйте их. Первая стркоа отвечает за сервера по умолчанию, вторая за сервера, если не удалось установить соединение с первыми.

Итак, вот пример конфигурации, например, Российской федерации. Сервера можно посмотреть на официальном сайте: «ntppool.org». Самое интересное в том, что сервера можно выбирать как с суб-зонами, так и без суб-зон.

NTP=0.ru.pool.ntp.org 1.ru.pool.ntp.org 2.ru.pool.ntp.org 3.ru.pool.ntp.org FallbackNTP=0.arch.pool.ntp.org 1.pool.ntp.org 2.europe.pool.ntp.org 3.asia.pool.ntp.org

Пробуем синхронизироваться.

$ sudo timedatectl set-ntp true

10.2. Синхронизация времени с помощью ntp и ntpdate.

Если вам по какой-то причине не подходит описанная выше синхронизация, либо вам нужен свой сервер времени в сети, то timesyncd можно выключить.

$ systemctl stop systemd-timesyncd $ systemctl disable systemd-timesyncd

Теперь установим ntpdate.

$ sudo apt install ntpdate

# Запускаем для разовой синхронизации.

$ sudo systemctl start ntp

$ sudo systemctl enable ntp

$ sudo ntpdate pool.ntp.org

# Проверяем.

$ sudo systemctl status ntp

Если у вас ntpdate выдает ошибку — the NTP socket is in use, exiting, значит у вас уже установлена и запущена служба ntp, которая заняла udp порт 123, необходимый для работы ntpdate.

При этом, для проверки статуса службы времени ntp можно использовать утилиту ntpq. Посмотрим статус синхронизации.

$ ntpq -p

Настройка своего NTP сервера синхронизации в данной статье не рассматривается.

Рассмотрим настройку ntp чуть более подробно.

Если вы хотите изменить сервера своей страны, воспользуйтесь файлом «/etc/ntp.conf».

Посмотреть сервера в зависимости от страны можно на официальном сайте ntppool.org.

Соответственно вставляйте эти настройки вместо таких же строк. Или просто закоментируйте такие же строки настроек и вставляйте свои чуть ниже.

server 0.ru.pool.ntp.org iburst

server 1.ru.pool.ntp.org iburst

server 2.ru.pool.ntp.org iburst

server 3.ru.pool.ntp.org iburst

Опция 'iburst' рекомендуется, с ее помощью посылается шквал пакетов, если не удается установить соединение с сервером с первого раза. Напротив, опцию 'burst' не используйте никогда без особого разрешения, так как Вы можете попасть в "черный список".

10.3. Настройка локали и языка.

Системная локаль устанавливается с помощью переменной LANG.

Программы, использующие gettext для перевода, учитывают также переменную LANGUAGE в дополнение к стандартным переменным. Это позволяет пользователям установить список локалей, которые будут использоваться в указанном порядке для поиска перевода. Если перевод для более предпочтительной локали (которая идет первее в списке) недоступен, будет произведена попытка получить перевод для следующей, и так далее.

Переменная LC_TIME отвечает за формат даты и времени.

Переменная LC_COLLATE отвечает за порядок сортировки и регулярных выражений. Установка значения LC_COLLATE=C, например, приведет к тому, что команда ls будет располагать файлы, имена которых начинаются с точки, первыми, за ними последуют имена, начинающиеся с цифры, затем с заглавной и, наконец, со строчной буквы.

Переменная LC_ALL переопределяет своим значением все LC_*-переменные, включая LANG, независимо от того, установлены они или нет.

Переменная LC_ALL — единственная из всех LC_-переменных, которую нельзя установить в «/etc/locale.conf». Она предназначена только в целях проверки при решении проблем.

Посмотрим определение текущей locale в системе.

# Текущая locales

$ locale

# Список сгенерированных locales в системе

$ locale -a

# Список сгенерированных locales с подробным описанием

$ locale -a -v

Настраиваем «/etc/default/locale»

$ sudo nano /etc/default/locale LANG=en_US.utf-8

Теперь записываем переменные окружения, чтобы при перезагрузке сервера настройки остались.

$ sudo nano /etc/environment LANGUAGE=en_US.UTF-8 LANG=en_US.utf-8 LC_ALL=en_US.UTF-8 LC_COLLATE=en_US.UTF-8 LC_TIME=en_US.utf-8

Чтобы не перезагружать систему, выполним ещё несколько команд.

$ export LANGUAGE=en_US.UTF-8

$ export LANG=en_US.utf-8

$ export LC_ALL=en_US.UTF-8

$ export LC_COLLATE=en_US.UTF-8

$ export LC_TIME=en_US.utf-8

$ sudo locale-gen

В Debian 12 и старше измените файл /etc/locale.gen:

$ sudo nano /etc/locale.gen

Сгенерировать файлы настроек выбранной локали можно так.

$ sudo locale-gen ru_RU.UTF-8

Назначьте русскую локаль по умолчанию с помощью следующей команды:

$ udo update-locale LANG=ru_RU.UTF-8

# или

$ sudo localectl set-locale LANG=ru_RU.UTF-8

Перезагрузить хост Linux, чтобы применить новые настройки локализации.

11. Настройка фаервола.

Настройка фаервола.12. Настройка Fail2ban.

Настройка Fail2ban.13. Настройка DNS.

Введение.

DNS — это система для связывания доменных имен с соответствующими им IP-адресами. DNS-серверы позволяют хранить данные IP-адресов соответствующих доменов, обеспечивать их кэширование и выдачу информации пользователю по запросу в сжатые сроки. Расположенные в разных локациях серверы повышают скорость загрузки страницы и, соответственно, лояльность пользователя к ресурсу.

На самом деле весь интернет работает именно с системой IP-адресов, а привычные нам названия нужны только для удобства людей: их проще запоминать и вводить. Поэтому всё, что вам нужно, — написать в адресной строке браузера веб-адрес и нажать Enter. Дальше браузер всё сделает сам: отправит нужные запросы, разыщет IP-адрес и откроет страницу.

Вообще, DNS состоит из двух частей: протокола и сети серверов. Протокол отвечает за способ передачи данных по сети, а серверы представляют собой машины, которые помогают протоколу эффективно работать. Но когда говорят о DNS, чаще всего подразумевают именно протокол.

По сути DNS-сервера в более простом понимании - это адресная книга. Мы вводим в браузер адрес, но он его не знает. Поэтому отправляет запрос в адресную книгу. По умолчанию в любой системе настроен только DNS провайдера, т.е. только то, что ПК (пусть даже и виртуальный) получил по сети в виде DHCP ответа на свой запрос при подключении к локальной, в данном случае домашней, сети.

В операционных системах Windows и Linux имеется файл hosts, в котором можно установить IP адреса для любых имён — хостов и доменных имён. По умолчанию операционные системы работают так.

- Если запрашиваемое имя присутствует в файле hosts, то его IP берётся из этого файла и запрос к DNS серверу не делается.

- Если в файле hosts имя хоста не найдено, то выполняется запрос к DNS серверу.

В ОС Linux-ах помимо файла hosts есть ещё так называемый порядок источников имен NSSWITCH. Вот как раз он в Linux системах и определяет порядок обращения.

Обычно порядок тот же, что и в Windows, описанный выше - сначала файл hosts, затем dns-сервера. Порядок обращения можно изменить. Например, установить сначала обращение к DNS серверам. Если запрашиваемое имя не было найдено на dns-серверах, то обратиться к файлу hosts.

Однако, помимо NSSWITCH и файла hosts в Linux системах существует также ещё и так называемый DNS-резолвер. Когда система начинает обращаться к DNS-серверам, резолвер определяет порядок обращения к различным dns-серверам. Тут может быть настроен как один единственный DNS-сервер, например, провайдера, так и несколько различных серверов на ваше усмотрение.

При запросе имени на один сервер, если он не ответил, или ответил, что не знает такого имени, то ваша система будет пытаться запрашивать ту же информацию с другого dns-сервера. И вот когда ни один из настроеных списков dns-серверов не ответит, или ответит, что такого адреса нет - то только в этом случае система сообщит пользователю или браузеру, что ничего не найдено.

Бывает много случаев, когда может понадобиться свой собственный DNS-сервер. Например, при создании и использовании собственного VPN.

Даже простой резолв адресов также требует правильной настройки.

Один из примеров - свой собственный фильтр рекламы, например, пусть AdGuard или Pi-Hole. При неправильном резолве адресов фильтр не будет ничего фильтровать.

Перейдём ко всем настройкам по порядку.

13.1. Порядок источников имен NSSWITCH.

NSSWITCH - это файл конфигурации Linux, который определяет, как система должна переключаться между различными поставщиками услуг имен.

Этот файл можно использовать для настройки того, какие службы следует использовать для поиска имени хоста, поиска паролей и т.д.

Файл /etc/nsswitch.conf считывается библиотекой Name Service Switch (NSS) при запуске системы. Затем библиотека NSS использует информацию в файле /etc/nsswitch.conf, чтобы определить, какие поставщики услуг имен должны использоваться для каждого типа поиска.

/etc/nsswitch.conf является важной частью операционной системы Linux, и любые изменения в этом файле могут привести к серьезным проблемам. Поэтому важно понимать, как работает /etc/nsswitch.conf, прежде чем вносить какие-либо изменения в этот файл.

В операционных системах Windows и Linux имеется файл hosts, в котором можно установить IP адреса для любых имён — хостов и доменных имён. По умолчанию операционные системы работают так.

- Если запрашиваемое имя присутствует в файле hosts, то его IP берётся из этого файла и запрос к DNS серверу не делается.

- Если в файле hosts имя хоста не найдено, то выполняется запрос к DNS серверу.

В операционной системе Linux можно поменять приоритет источников для получения IP адреса или вовсе отключить некоторые из них. Для этого используется файл «/etc/nsswitch.conf».

Строка, которая отвечает за преобразование имён хостов начинается на «hosts».

hosts: files dns

В старых или более новых системах она может быть такой.

hosts: files mymachines myhostname resolve [!UNAVAIL=return] dns

- hosts — это указание на службу, для которой предназначена строка.

- files означает файл, относящийся к этой службе. У каждой службы в системе свой файл, в данном случае имеется ввиду «/etc/hosts».

- mymachines — судя по названию, означает имя машины.

- myhostname - hostname, логично.

- resolve — это системная служба резолва.

- Строка «[!UNAVAIL=return]» - означает, что если предыдущая служба недоступна, то немедленно будет возвращён результат без запроса в следующем источнике.

Файлы других служб.

- aliases /etc/aliases

- ethers /etc/ethers

- group /etc/group

- hosts /etc/hosts

- initgroups /etc/group

- netgroup /etc/netgroup

- networks /etc/networks

- passwd /etc/passwd

- protocols /etc/protocols

- publickey /etc/publickey

- rpc /etc/rpc

- services /etc/services

- shadow /etc/shadow

Чтобы отключить файл «/etc/hosts» просто уберите слово «files».

Чтобы сделать приоретет dns выше файла «/etc/hosts» поставте это слово перед словом «files».

13.2. DNS-Кеш.

Иногда вам может понадобится очистить кеш dns. Например, вам в организации для вашего выделенного белого ip адреса предоставлен доступ к какой-нибудь базе данных. И частенько бывает что у кого-нибудь что-нибудь не грузится, или возникают проблемы с dns-сервером.

Обычно очистка dns-кеша помогает временно решить проблему. Чтобы постоянно не чистить кеш dns стоит внести в файл «hosts» вашей системы сопоставление доменного имени и ip-адреса этой базы данных.

В Linux-е очистить кеш-dns немного сложнее, чем в Windows-е.

Сначала необходимо определить кто занимается кешированием. Например, посмотрим на systemd-resolved. Он бывает гораздо удобнее, чем встроеный резолвер в Network Manager.

$ sudo systemd-resolve --statistics

Команда вернет ошибку, если резолвер не используется.

Если всё-таки используется для его очистки и перезапуска можно воспользоваться следующими командами.

$ sudo systemd-resolve --flush-caches

$ sudo systemctl enable systemd-resolved.service

Не забудьте про службу кеширования запросов службы имён «nscd».

$ sudo systemctl restart nscd

$ nscd -K; nscd

Для её установки и настройки в Debian выполните следующие команды

$ sudo apt install nscd

$ sudo systemctl restart nscd

$ sudo ncsd -g

$ sudo strings /var/cache/nscd/hosts

В Archlinux она есть только в «AUR».

При использовании «Network Manager», его просто необходимо перезапустить.

$ sudo service networking restart # или $ sudo systemctl restart NetworkManager

13.3. DNS-резолвер.

systemd-resolved — это сервис systemd для локального резолвинга DNS запросов. По сути это локальный мини DNS-сервер с поддержкой кеширования, DNSSEC и DNSOverTLS. При включенном кешировании он позволяет ускорить резолвинг DNS запросов, особенно при включенном DNSSEC.

Он полезен для уменьшения задержек резолвинга при использовании нестабильных интернет-провайдеров и при недолгих падениях DNS серверов (в пределах TTL DNS записей доменов, к которым идут запросы). Также не помешает на серверах, где идет много запросов на резолвинг имен (почтовые сервера, сервера мониторинга, сервера с большим количеством задач с запросом данных с удаленных источников).

Этот сервис в Debian системах уже идет из коробки вместе с systemd. Собственно как и в Archlinux системах. Устанавливать его не нужно. И по умолчанию он обычно отключен.

Для того, чтобы резолвинг DNS в Debian сервере шел через systemd-resolved, необходимо установить libnss-resolve, плагин для механизма NSS (GNU Name Service Switch). В Archlinux библиотека встроена в systemd.

Также установим утилиту resolvconf которая хранит системную информацию о доступных в настоящее время серверах имен и управляет содержимым конфигурационного файла resolv.conf, который определяет параметры распознавателя системы доменных имен.

$ sudo apt install libnss-resolve resolvconf -y

По умолчанию резолвинг адресов настраивается в файле «/etc/resolv.conf».

Если вы хотите изменить порядок обращения к dns-серверам, а также задать и другие настройки DNS, необходимо сделать резервную копию этого файла и сделать его ссылкой на «systemd-resolved».

$ sudo mv /etc/resolv.conf /etc/resolv.conf.backup

$ sudo ln -s /run/systemd/resolve/resolv.conf /etc/resolv.conf

Если systemd-resolved не получает адреса DNS-серверов от сетевого менеджера и никакие сервера не были настроены вручную, то он использует специальные зарезервированные DNS-адреса. Таким образом, разрешение доменных имён работает всегда.

Вообще, все глобальные настройки задаются в файле «/etc/systemd/resolved.conf», но рекомендую в нём либо закоментировать всё, кроме «[Resolve]» строки, либо если никогда не настраивали, то не трогать этот файл вообще. Лучше перепроверьте, что все настройки закоментированы.

Дело в том, что systemd-resolved сначала будет читать настройки из этого файла, и только потом, из других. Если здесь первым указан адрес, например DNS-Google, то при попытке использования на вашем сервере того же фильтра рекламы, запросы будут направляться именно на DNS-Google, а не туда куда вам нужно. Поэтому создадим отдельную конфигурацию, чтобы управлять порядком обращения стало значительно проще.

После всех манипуляций не забывайте обязательно перезагружать systemd-resolved.

$ sudo mkdir -p /etc/systemd/resolved.conf.d/

$ sudo nano /etc/systemd/resolved.conf.d/dns_servers.conf

[Resolve]

DNS=8.8.8.8 8.8.4.4

FallbackDNS=77.88.8.8 77.88.8.1

Domains=~.

DNSStubListener=no

DNSSEC=true

DNSOverTLS=yes

# Обязательно перезагружаем systemd-resolved

$ sudo systemctl restart systemd-resolved

# И проверяем что у нас получилось.

$ sudo resolvectl status

Рассмотрим каждый из пунктов поподробнее. Вся информация взята из «ArchMan RESOLVED.CONF(5)».

- DNS - первичный DNS-сервер, к которому будет производиться запрос в первую очередь.

- FallbackDNS - Запасные DNS-сервера.

- Domains - это «домены поиска» обрабатываются строго в том порядке, в котором они указаны, до тех пор, пока не будет найдено имя с добавленным суффиксом. По соображениям совместимости, если этот параметр не указан, вместо него используются домены поиска, перечисленные в «/etc/resolv.conf» с ключевым словом search, если этот файл существует и в нем настроены какие-либо домены. Домены с префиксом «~» называются «домены только для маршрутизации». Все перечисленные здесь домены (и домены поиска, и домены только маршрутизации после удаления префикса «~») определяют путь поиска, который предпочтительно направляет DNS-запросы к этому интерфейсу. Этот путь поиска действует только тогда, когда известны подходящие DNS-серверы для каждой ссылки. Такие серверы могут быть определены с помощью параметра DNS= (см. выше) и динамически во время выполнения, например, из аренды DHCP. Если DNS-серверы для каждой ссылки неизвестны, домены только для маршрутов не действуют. Используйте конструкцию «~». (который состоит из «~», чтобы указать домен только для маршрута, и «.», чтобы указать корневой домен DNS, который является подразумеваемым суффиксом всех доменов DNS) для использования DNS-серверов, определенных для этой ссылки, предпочтительно для всех доменов. См. «Протоколы и маршрутизация» в systemd-resolved.service(8) для получения подробной информации об использовании доменов поиска и маршрутизации.

- DNSStubListener - Принимает логический аргумент или один из «udp» и «tcp». Если указано «udp», преобразователь заглушки DNS будет прослушивать запросы UDP по адресам 127.0.0.53 и 127.0.0.54, порт 53. Если «tcp», то заглушка будет прослушивать запросы TCP по тем же адресам и порту. Если «yes» (по умолчанию), заглушка прослушивает как UDP-, так и TCP-запросы. Если «no», прослушиватель-заглушка отключен. Резолвер-заглушка DNS на 127.0.0.53 предоставляет полный набор функций локального резолвера, включая разрешение LLMNR/MulticastDNS. Преобразователь заглушки DNS на 127.0.0.54 предоставляет более ограниченный преобразователь, который работает только в «прокси-режиме», т. е. он будет передавать большинство сообщений DNS относительно неизмененными на текущие вышестоящие DNS-серверы и обратно, но не будет пытаться обрабатывать сообщения локально, и, следовательно, не проверяет DNSSEC и не предлагает LLMNR/MulticastDNS. (Однако при необходимости он будет переведен на связь DNS-over-TLS.) Обратите внимание, что прослушиватель-заглушка DNS неявно отключается, если его адрес прослушивания и порт уже используются.

- DNSSEC - Принимает логический аргумент или «разрешить переход на более раннюю версию». Если установлено значение true, все поисковые запросы DNS проходят локальную проверку DNSSEC (за исключением LLMNR и многоадресной DNS). Если ответ на запрос поиска оказывается недействительным, в приложения возвращается ошибка поиска. Обратите внимание, что для этого режима требуется DNS-сервер, поддерживающий DNSSEC. Если DNS-сервер не поддерживает должным образом DNSSEC, все проверки завершатся неудачей. Если установлено значение «разрешить переход на более раннюю версию», выполняется попытка проверки DNSSEC, но если сервер не поддерживает DNSSEC должным образом, режим DNSSEC автоматически отключается. Обратите внимание, что этот режим делает проверку DNSSEC уязвимой для атак с понижением версии, когда злоумышленник может инициировать переход на режим без DNSSEC, синтезируя ответ DNS, предполагающий, что DNSSEC не поддерживается. Если установлено значение false, запросы DNS не проверяются DNSSEC. Рекомендуется установить для DNSSEC= значение true в системах, где известно, что DNS-сервер правильно поддерживает DNSSEC, и где регулярно происходят обновления программного обеспечения или якоря доверия. В других системах рекомендуется установить для DNSSEC= значение "allow-downgrade". Частные зоны DNS обычно конфликтуют с работой DNSSEC, если только для них не настроена отрицательная (если частная зона не подписана) или положительная (если частная зона подписана) якорь доверия. Если выбран режим «разрешить переход на более раннюю версию», будет предпринята попытка обнаружить частные зоны DNS с использованием доменов верхнего уровня (TLD), которые не известны корневому серверу DNS. Эта логика не работает во всех настройках частной зоны.

- DNSOverTLS - Принимает логический аргумент или «оппортунистический». Если true, все подключения к серверу будут зашифрованы. Обратите внимание, что для этого режима требуется DNS-сервер, поддерживающий DNS-over-TLS и имеющий действительный сертификат. Если имя хоста было указано в DNS= в формате «адрес#имя_сервера», оно используется для проверки его сертификата, а также для включения индикации имени сервера (SNI) при открытии соединения TLS. В противном случае сертификат сверяется с IP-адресом сервера. Если DNS-сервер не поддерживает DNS-over-TLS, все DNS-запросы завершатся ошибкой. Если установлено значение «оппортунистический», DNS-запросы пытаются отправить в зашифрованном виде с помощью DNS-over-TLS. Если DNS-сервер не поддерживает TLS, DNS-over-TLS отключен. Обратите внимание, что этот режим делает DNS-over-TLS уязвимым для атак с понижением версии, когда злоумышленник может инициировать переход к незашифрованному режиму, синтезируя ответ, который предполагает, что DNS-over-TLS не поддерживается. Если установлено значение false, запросы DNS отправляются по протоколу UDP. Обратите внимание, что DNS-over-TLS требует отправки дополнительных данных для настройки зашифрованного соединения, что приводит к небольшому увеличению времени поиска DNS. Обратите внимание, что в «оппортунистическом» режиме преобразователь не может аутентифицировать сервер, поэтому он уязвим для атак «человек посередине». В дополнение к этой глобальной настройке DNSOverTLS= systemd-networkd.service(8) также поддерживает настройки DNSOverTLS= для каждой ссылки. Для системных DNS-серверов (см. выше) действует только глобальный параметр DNSOverTLS=. Для DNS-серверов для каждой ссылки действует настройка для каждой ссылки, если только она не отключена, и в этом случае вместо нее используется глобальная настройка.

А теперь рассмотрим сами параметры описанного конфигурационного файла. Настройки параметров взяты из «ArchWiki systemd-resolved».

DNS=8.8.8.8 8.8.4.4

В случае когда у вас на сервере предполагается использование любого DNS-сервера - будь то bind9 или фильтра рекламы, вроде AdGuard - то сначала здесь по любому необходимо указать какие-либо сторонные DNS адреса. Просто чтобы система смогла вообще загрузить установочные пакеты. Затем, когда вы установите какой-либо DNS-сервер можно будет сменить все адреса этой строки одним единственным адресом вашего DNS-сервера.

Ну, например, вы установили самый простой вариант - bind9 и dnsutils. Тогда в этой строке ничего менять не придётся. Если конечно у вас есть собственные dns-зоны и вы их настроили - то строка будет выглядеть примерно так: «DNS=127.0.0.1».

В другом примере вы установили филтр рекламы, пусть, AdGuard в docker-container. DNS оставили на 53 порту. Тогда после запуска фильтра, строка измениться следующим образом: «DNS=172.20.0.2». Разумеется у вас будет свой IP-адрес. Но об этом будет рассказано в следующем разделе.

В случае использования Wireguard-а и Bind9 - то оставьте конфигурацию в описанном выше виде.

Если же, когда у вас Wireguard и AdGuard - «DNS=172.20.0.2».

В пункте о DNS-серверах вы узнаете почему именно такие настройки.

FallbackDNS=77.88.8.8 77.88.8.1

Запасные адреса DNS-серверов. У меня указаны yandex, но можно и другие или добавить в эту строку перед ними или даже после них. В любом случае они обязательно должны быть. Чтобы, например, при обновлении docker-контейнера с фильтром рекламы AdGuard - не потерять интернет в принципе.

Domains=~.

Если не указать в файле resolved.conf(5) опцию Domains=~., то systemd-resolved может использовать DNS-серверы из настроек отдельных сетевых интерфейсов, если параметр Domains=~. в них есть. Данная опция не повлияет на запросы доменных имён, которые совпадают с каким-то более точным поисковым доменом из настроек интерфейса — разрешение таких имён будет выполняться посредством соответствующих "интерфейсных" DNS-серверов.

DNSStubListener=no

Преобразователь заглушки DNS выключен.

DNSSEC

Если ваш DNS-сервер не поддерживает DNSSEC и вы испытываете проблемы в стандартном (используется по умолчанию) allow-downgrade-режиме, попробуйте полностью отключить DNSSEC в systemd-resolved параметром DNSSEC=false. systemd-resolved может отключить DNSSEC после нескольких неудачных попыток выполнить проверку. Если задано значение DNSSEC=true, то разрешение имён вообще перестанет работать.

DNSOverTLS=yes

DNS over TLS по умолчанию не работает. Чтобы включить проверку сертификата DNS вашего провайдера, добавьте соответствующее имя хоста в параметр DNS= в формате «ip_адрес#имя_хоста». DNS-сервер должен тоже поддерживать DNS over TLS, иначе он просто не будет отвечать на запросы.

13.4. DNS-сервер.

Сегодня невозможно представить себе интернет без DNS. Однако многие администраторы не уделяют время настройке этой службы на своих серверах, поэтому не используют всю ее мощь даже на треть.

Основная цель DNS — это преобразование доменных имен в IP-адреса и наоборот — IP в DNS.

По моему глубокому мнению DNS-сервер - это не просто сервер имен, в котором в текстовых файлах содержится информация о тех или иных адресах, а полноценная огромная база данных, но уже не только с сопоставлением имен и ip-адресов, а база, которая также для каждого сопоставления содержит в себе ресурсные записи.

Ресурсные записи DNS — это записи о соответствии имени и служебной информации в системе доменных имен, например, соответствие имени домена и IP-адреса. Редактирование ресурсных записей для доменного имени производится на стороне держателя NS-серверов (например, хостинг-провайдера, на NS-серверы которого делегировано доменное имя).

Чтобы при вводе домена в поисковую строку браузера открывался сайт, а не ошибка, нужно указать для домена ресурсные записи DNS. Они «расскажут» другим DNS-серверам интернета о вашем домене. Если не настроить ресурсные записи (записи DNS-зоны), серверы не смогут передавать информацию между собой и сайт просто не будет работать.

Вы вполне можете делегировать права управления своим зарегистрированным доменом на свой собственный сервер, на сервере установить и настроить как простейший (bind9), так и какой-либо более сложные DNS-сервер (например, PowerDNS). Или установить хостинг систему (BrainyCP, ISPanel, VestaCP и другие) и уже в ней настраивать DNS череp панель управления хостингом.

Любой выбранный вариант можно установить как напрямую в сервер, т.е. посредством пакетного менеджера из репозиториев, так и в docker или podman контейнер.

Если хотите узнать о настройке DNS сервиса в хостинг панели VestaCP - то вам «Сюда». Однако, данные DNS настройки будут по сути одинаковыми для любой подобной панели управления. Всё что изменится - расположение настроек для разных панелей.

В данном цикле уроков мы не будем с вами рассматривать настройку собственных DNS-зон, делегирование прав и прочих подобных настроек. Мы рассмотрим с вами более простую задачу - в случае когда, вам нужен простой DNS-сервер, спрятанный за VPN.

Роль такого сервера достаточно проста - либо перенаправлять запросы из одного места в другое, либо перезаписывать (фильтровать) определенные виды запросов для закрытого доступа, т.е. доступа только за VPN, не ограниченного с какой-либо другой стороны или если вам необходим доступ к определенным внутренним сервисам между организациями и вы не хотите или не можете выставлять их в инернет.

Зачем в принципе ставить DNS-сервер внутри VPN - вопрос одновременно и простой и сложный.

Дело в том, что systemd-resolved перенаправляет запросы только для физических интерфейсов. Когда запрос приходит от виртуального интерфейса - например, wireguard-а, то резолвер по сути не знает что с этим запросом делать. Даже если у вас будут настроены все разрешения на проход трафика в обоих направлениях и указан первичный dns 127.0.0.1 - в системе всё равно запрещена обработка запросов с виртуальных интерфейсов. Когда же у вас установлен любой dns-сервер и в резолвере указан адрес этого сервера - резолвер понимает что не важно откуда пришёл запрос - даже если с виртуального интерфейса- его обязательно надо сначала отправить в этот dns-сервер. А уже DNS-сервер разрешает системе обрабатывать полученные запросы, например перенаправить на другой dns-сервер или обработать самому.

Здесь мы рассмотрим с вами 2 варианта - простейший bind9 как наименее требовательный и простой в настройке, так и AdGuard фильтр рекламы, установленный в docker-контейнер.

Самое забавное в том, что AdGuard по сути не совсем фильтр рекламы - это скорее навороченный малоуправляемый DNS-сервер. Почему малоуправляемый сейчас расскажу.

У него есть меню, где вы можете настроить свой собственный список dns-адресов к которым AdGuard может в процессе работы обращатья. Точно также как и systemd-resolved со своим списком dns-адресов.

В нём также есть масса различных уже готовых фильтров рекламы и плохого контента. Вы вполне можете добавить собственные фильтры или написать свои.

У него ещё масса полезных настроек, но нас интересуют ресурсные записи. Да, у AdGuard-а есть такая настройка, но она весьма скудная и сильно ограниченная, т.е. много в ней не настроишь. Даже в bind9 куда больше возможностей.

Но это 2 наиболее простых в использовании и настройке DNS-сервера, которые помогут значительно упростить вам жизнь.

А теперь повогорим о недостатках таких dns-серверов, прежде, чем приступить к установке и настройке.

Недостаток у каждого свой. У Bind9 - все ресурсные записи и настройки зон храняться в текстовых файлах, а не полноценной базе данных. У AdGuard необходимость установки и настройки веб-панели управления. Самый большой недостаток - у обоих утилит не выйдет как-либо ускорить процесс получения let'sencrypt-сертификатов. У них нет никакого API, чтобы можно было скопировать ключ доступа и вставить в сервис автоматического перезапроса сертификатов. Вам, скорее всего, придётся проделывать ручные настройки ресурсных записей для подтверждения владения тем или иным доменом - в случае если ваш DNS-сервер будет использовать некие собственные доменные зоны. Если вам доменные зоны не нужны - то это великолепные сервера, которые решат большинство ваших задач.

К слову о bind9 - у него куда больше возможностей, чем есть в интернете, но настривается он куда более нудно, долго и порой сложно.

Обратите внимание!

Вместе разные dns-сервера работать не будут - только один - тот который выберите.

AdGuard.

Начнем с AdGuard-а, как с наиболее интересного, но наиболее требовательного. Ибо съедает он немало оперативной памяти. Но, взамен практически половина контента будет у вас без мусора и мелкого вредоноса.

Устанавливать будем в docker-контейнер. Можете конечно установить и напрямую, но я бы всё-таки рекомендовал ставить в docker. Так управлять им будет значительно проще, да и в случае проблем - избавиться от него будет в разы легче, чем когда вы установите его напрямую из того или иного репозитория.

Итак, создадим папку, запишем в неё docker-compose.yml файлик и запустить контейнер. Обратите внимание, что контейнер будет создавать новую docker-подсеть. Поэтому если у вас запущен Firewalld и Fail2ban - рекомендую их временно выключить. После запуска, вновь включите, посмотрите на сеть, чтобы узнать новые имена интерфейсов и добавить их в зону internal вашего фаервола.

Для начала давайте временно выключим фаервол, и запустим AdGuard.

$ sudo systemctl stop fail2ban.timer && sudo systemctl stop fail2ban

$ sudo systemctl stop firewalld.timer && sudo systemctl stop firewalld

$ mkdir adguard && cd adguard && nano docker-compose.yml

version: "3"

services:

adguardhome:

image: adguard/adguardhome

container_name: adguardhome

ports:

- "53:53/tcp" # DNS

- "53:53/udp" # DNS

- "853:853/tcp" # DNS

- "853:853/udp" # DNS

- "3123:3000/tcp" # DashBoard Setup, do not change 80

- "5449:5443/tcp"

- "3080:80/tcp"

- "3443:443/tcp"

volumes:

- ./workdir:/opt/adguardhome/work

- ./confdir:/opt/adguardhome/conf

restart: unless-stopped

networks:

adguard_net:

ipv4_address: 172.20.0.2

networks:

adguard_net:

driver: bridge

ipam:

config:

- subnet: 172.20.0.0/16

gateway: 172.20.0.1

# Сохраняем и выходим

CTRL + o

CTRL + x